Il dirigente a capo di WhatsApp ha promesso che non comprometterà la sicurezza del servizio di messaggistica, piegandosi alle richieste del governo britannico che spinge per l’integrazione di funzionalità che prevedono la scansione delle immagini nelle conversazioni private.

La dichiarazione arriva da Will Cathcart, che lavora per l’azienda sotto il cappello di Meta da oltre 12 anni, e a capo di WhatsApp dal 2019. In una dichiarazione alla BBC ha riferito che il servizio in questione non verrà declassato o verranno integrati sistemi per bypassare la crittografia end-to-end impiegata attualmente quando si avvia una chat con qualcuno tramite WhatsApp Messenger.

L’idea di integrare un meccanismo per individuare automaticamente la presenza di determinate immagini è del governo britannico ma WhatsApp la rifiuta, evidenziano la necessità di offrire agli utenti un insieme coerente di standard in tutto il mondo.

“Abbassare il livello di sicurezza in giro per il mondo, per soddisfare i requisiti di una nazione, sarebbe una scelta assurda da accettare, rendendo il nostro prodotto meno desiderabile per il 98% degli utenti, per requisiti richiesti da un 2%”, ha riferito Cathcart. “Ciò che viene proposto è – direttamente o indirettamente mediante software – di leggere i messaggi di tutti; non credo che le persone vogliono questo”.

La crittografia end-to-end sfruttata da WhatsApp garantisce che solo noi e la persona con cui la quale stiamo comunicando, e nessun altro, nemmeno WhatsApp, possa leggere o ascoltare i contenuti inviati. Con la crittografia end-to-end, i messaggi sono protetti e solo il mittente e il destinatario dispongono della “chiave speciale” necessaria per sbloccarli e leggerli. Tutto questo avviene automaticamente: non c’è bisogno di attivare alcuna impostazione o creare speciali chat segrete per proteggere i messaggi.

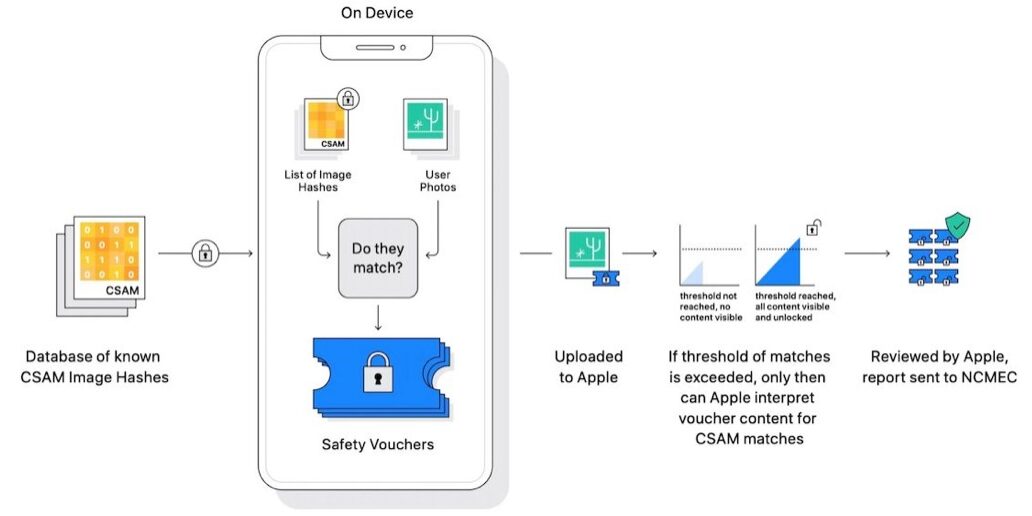

Il governo britannico propone agli sviluppatori di app l’integrazione di un meccanismo controllato da una intelligenza artificiale in grado di scansionare la pipeline dei dati, individuare e segnalare contenuti illegali, in questo caso materiale che mostra abusi sessuali sui minori (CSAM, da child sexual abuse material in inglese).

Un sistema simile era stato proposto da Apple scatenando molte polemiche. Il problema sono i potenziali “falsi positivi” che si potrebbero generare. Apple aveva previsto un sistema che, prima di inviare segnalazioni automatiche, richiedeva verifiche tramite moderatori umani, che avrebbero a loro volta eventualmente segnalato l’utente alle forze dell’ordine. Apple aveva riferito di un sistema estremamente sicuro mediante il controllo di specifiche porzioni di hash già note, un meccanismo che secondo Cupertino assicurava “meno di un caso su mille miliardi di falsi positivi all’anno”.

Resta da capire ora che succederà: non solo il Regno Unito ma anche la Commissione europea ha previsto in una bozza l’obbligo per aziende come Google, Meta e altre ancora di individuare e rimuovere la pedopornografia online. Il Digital Markets Act – la legge europea sui mercati digitali che sarà applicata tra circa un anno – obbligherà Apple a ripensare gran parte dei meccanismi di funzionamento di iOS, con tanto di apertura obbligatoria a store di terze parti, motori di rendering per i browser di terze parti e molto altro ancora.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)