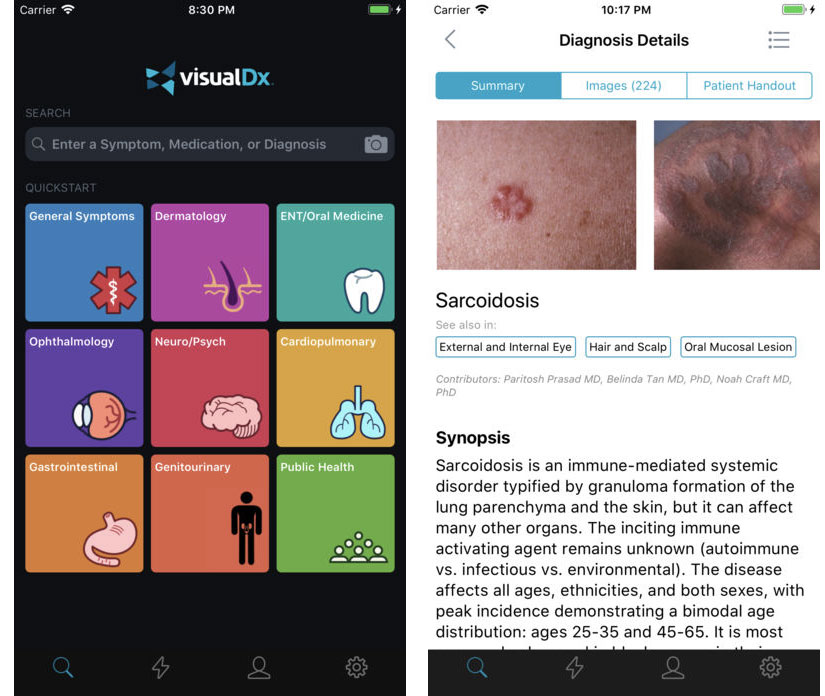

Durante l’ultima presentazione dei risultati fiscali, il CEO di Apple Tim Cook ha fatto cenno a VisualDX, un’app per medici. L’app è presente nell’App Store (scaricabile da chiunque) ma è in realtà un’app destinata a medici esperti e accreditati che possono usarla come ausilio per diagnosticare malattie e altri disturbi della pelle.

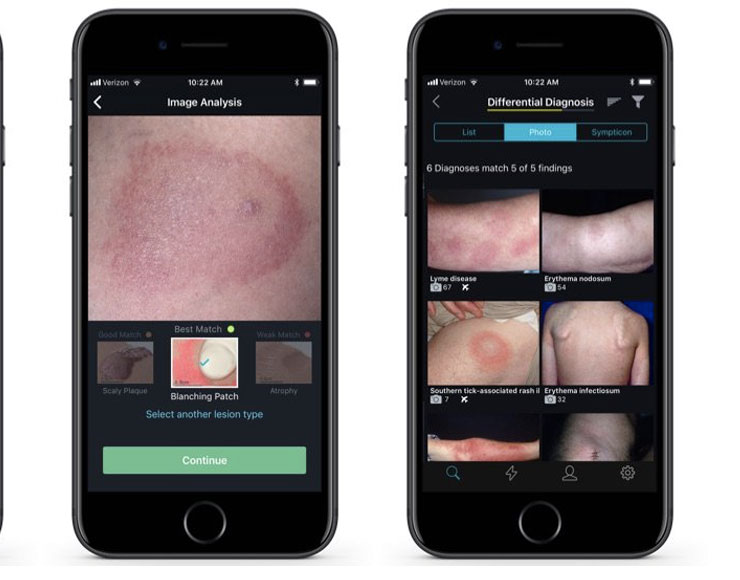

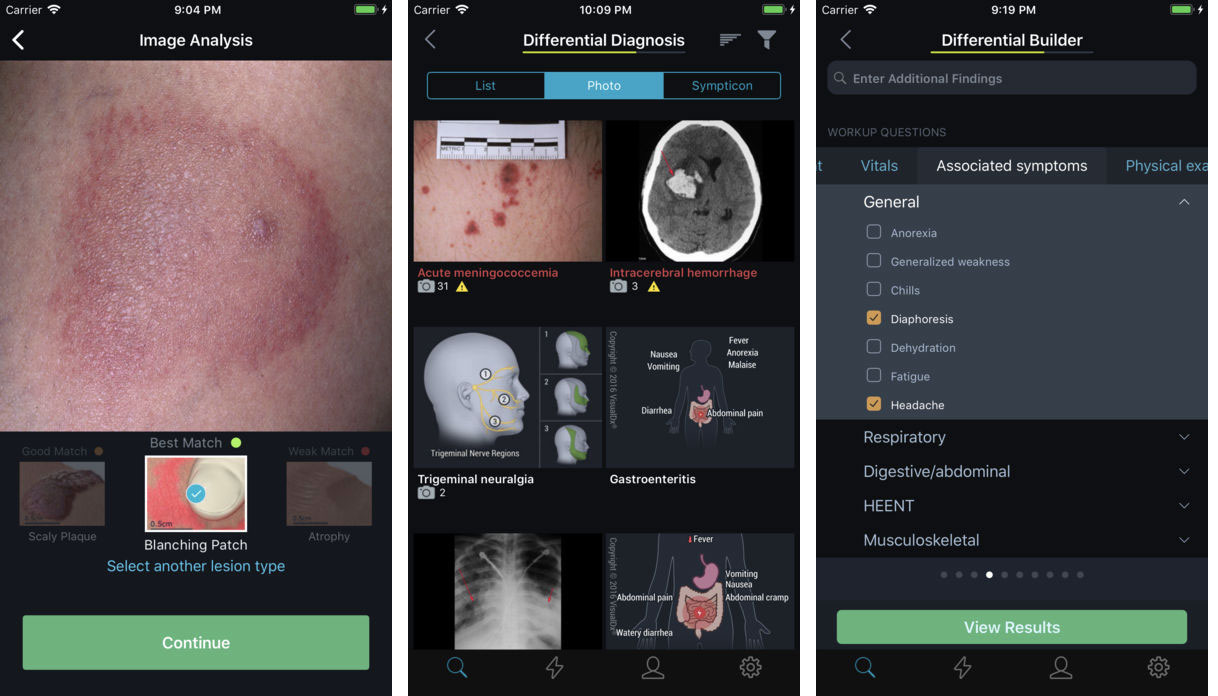

Di VisualDX parla BusinessInsider spiegando che da qualche tempo l’app è in grado di sfruttare la fotocamera dell’iPhone e funzionalità di apprendimento automatico per identificare malattie della pelle o ad ogni modo restringendo i possibili tipi di patologie.

Tim Cook ha evidenziato le funzionalità all’avanguardia di VisualDx, app che si appoggia a Core ML, un framework di Apple che permette agli sviluppatori di sfruttare potenti funzioni di apprendimento automatico (machine learning) e creare app in grado di prevedere, imparare e diventare via via più “intelligenti”.

Sotto diversi punti di vista VisualDx mostra i profondi cambiamenti in corso in campo medico anticipando quello che potrà diventare in futuro la medicina: l’ausilio di funzionalità di elaborazioni avanzate e l’intelligenza artificiale permetteranno in vari casi di avere a disposizione strumenti diagnostici utilizzabili in abbinamento ad app dedicate. Gli utenti potranno scattare foto a una parte del loro corpo e capire se c’è sulla loro pelle un problema che richiede cure mediche o si tratta di semplici eruzioni cutanee. Gli sviluppatori di VisualDx stanno a questo proposito sviluppando anche un’app denominata Aysa destinata al pubblico, in grado di analizzare comuni disturbi cutanei.

Gli utenti non vogliono giocare a fare il dottore, spiega Art Papier, dottore in medicina e CEO di VisualDx, ma un sabato qualunque potrebbero avere bisogno di uno strumento in grado di suggerire loro se portare al pronto soccorso il figlio o se attendere lunedì per vedere il pediatra. «È semplicemente una questione di sensibilizzazione e triage (termine utilizzato per selezionare i soggetti secondo classi di urgenza/emergenza crescenti, ndr)» ha spiegato Papier. «Non è una diagnosi, alla quale non facciamo affidamento. Per almeno altri cinque anni non diremo ai pazienti: è tutto a posto, non c’è bisogno di vedere un dottore».

L’annuncio di CoreML da parte di Apple a giugno ha stuzzicato la fantasia degli sviluppatori. VisualDx ha creato un’app addestrata partendo da modelli con immagini mediche analizzate da professionisti della medicina, collaborando con università e singoli medici riconosciuti come esperti.

Molte delle immagini sfruttate da VisualDx sono parte di vecchie collezioni di slide e pellicole di importanti dipartimenti e medici. Per creare la libreria per il training dell’app per iOS si è partiti da 32.000 immagini, sviluppando una sorta di reputazione pari a quella di qualcuno che si occupa della salvaguardia di un patrimonio di fotografie mediche. Nonostante sia stato possibile creare modelli e sfruttare dati di training di alta qualità, Papier pensa che non sia ancora il momento di parlare di diagnosi automatiche, aspettative in questo campo ancora fuori dal comune per il machine learning.

Da tempo varie aziende sono interessate all’intelligenza artificiale e al machine learning in diversi ambiti medici. Anche Mark Zuckerberg di Facebook lo scorso anno ha annunciato di avere messo a disposizione tre miliardi di dollari, da investire nei prossimi dieci anni, per aiutare scienziati e ricercatori a sviluppare nuovi strumenti. Il Ceo del social network ha spiegato che l’intelligenza artificiale potrebbe essere di ausilio nella cura dei disturbi neurologici, gli algoritmi di machine learning utili per analizzare i genomi tumorali e i chip per monitorare i flussi sanguigni e diagnosticare alcune malattie più velocemente.