Uno sviluppatore che si chiama Asuhariet Yvgar riferisce di avere usato tecniche di reverse engineering per scoprire come funziona l’algoritmo di NeuralHash usato da Apple nel sistema anti-pedofilia che dovremmo vedere su iOS 15, iPadOS 15 e macOS 12 Monterey e che permetterà di identificare automaticamente determinate immagini caricate su iCloud.

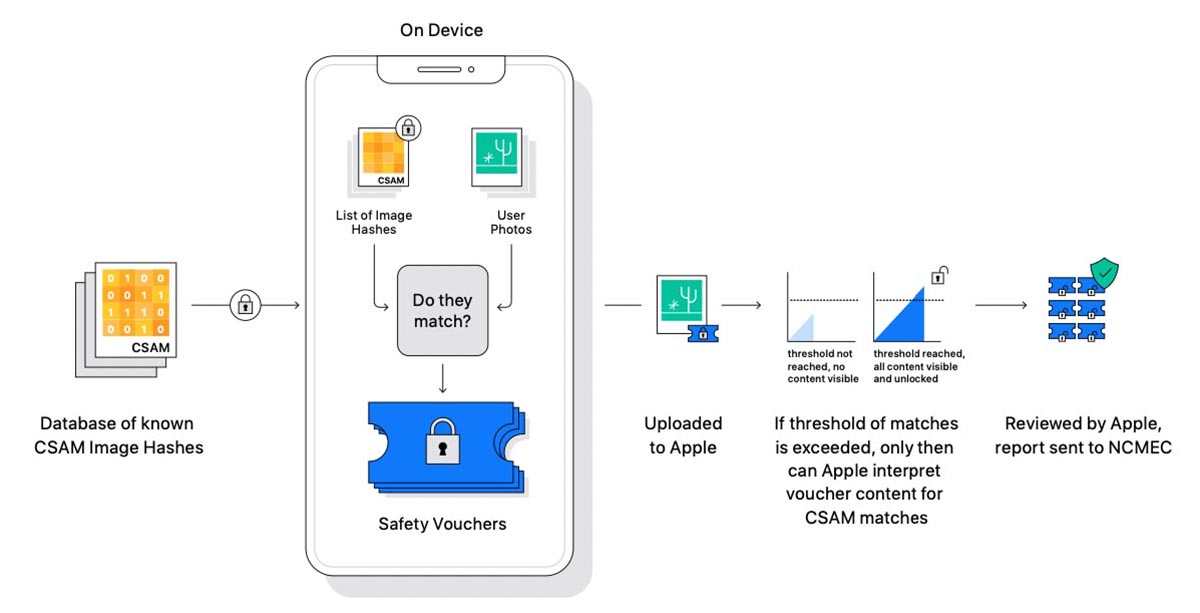

Il sistema che esegue la scansione sul dispositivo prima che venga eseguito il backup di un’immagine in iCloud si chiama “Neural Hash” (qui un documento in PDF di Apple con dettagli sul funzionamento). Questa intelligenza artificiale confronta le immagini con un archivio fornito da organizzazioni per la protezione dei minori come il National Center for Missing & Exploited Children (NCMEC) e altre ancora, cercando corrispondenze. Il confronto è possibile grazie a un doppio processo crittografico che trasforma l’archivio di immagini pedopornografiche note in stringhe di testo (hash). La sequenza di stringhe permette di analizzare le caratteristiche delle immagini caricate su iCloud Foto. Le immagini che in qualche modo risulteranno simili a quelle del database di riferimento, saranno caricate insieme ad una etichetta nascosta. Dopo una certa soglia di probabili contenuti pedopornografici, Apple riceve una segnalazione e scatta un controllo sulle immagini da parte di personale incaricato, decifrando e rivedendo manualmente le immagini, alla fine inoltrando eventualmente il tutto al NCMEC per le verifiche.

Il sistema anti-pedofilia di Apple è stato apprezzato da alcune organizzazioni che tutelano i minori (compreso il nostro MOIGE) ma non sono mancate critiche da parte di associazioni che si occupano di privacy, preoccupate da un potenziale diverso uso in futuro di questo sistema: la possibilità che governi e regimi vari obblighino Apple a identificare e segnalare la presenza di simboli e immagini varie nelle foto dell’utente non gradite al regime di turno.

Asuhariet Yvgar riferisce di avere sfruttato tecniche di reverse engineering per analizzare l’algoritmo di NeuralHash già presente su iOS 14.3, ricostruendo in Python il sistema di identificazione usato da Apple. In seguito alle conclusioni di Yvgar, un diverso utente è stato in grado di individuare quelle che in gergo si chiamano “collisioni” (hash identici su immagini che potrebbero far scattare erroneamente allarmi, alterando la bontà̀ del dataset). Gli esperti in sicurezza hanno già evidenziato i pericoli che potrebbero nascere dalle “collisioni” e potenziali problematiche dai falsi positivi.

In una dichiarazione al sito Motherboard, Apple ha riferito che la versione di NeuralHash sulla quale Yvgar ha applicato tecniche di ingegneria inversa, non è la stessa implementazione che sarà usata nel futuro sistema anti-pedofilia di Apple. Cupertino ha riferito ancora di avere reso pubblico l’algoritmo sfruttato per permettere ai ricercatori specializzati in sicurezza di verificare la bontà del sistema, evidenziando ancora che esiste ad ogni modo un secondo algoritmo lato-server che verifica le corrispondenze dopo il raggiungimento di una determinata soglia di segnalazioni, che alla fine prevede sempre e comunque verifiche da parte di personale incaricato di questi compiti.

Un altro ricercatore, Nicholas Weaver, ha riferito sempre a Motherboard la possibilità di manipolare immagini attivando continui controlli anche per immagini non pedopornografiche, con ovvie perdite di tempo per Apple che continuerebbe a ricevere segnalazioni con falsi positivi ma per fare questo bisognerebbe disporre dello stesso database usato da Apple che permette di creare gli hash di verifica. Secondo Apple la possibilità di ricevere false segnalazioni sulle immagini è altamente improbabile e la possibilità che immagini del tutto diverse da quelle presente nel database di riferimento siano segnalate è pari a uno su mille miliardi.