Alla presentazione dell’iPhone Apple non si fa mai mancare le iperboli. E di solito è Schiller ad essere il più generoso in questo ambito, ma questa volta il buon vecchio Phil potrebbe avere picchiato davvero in testa quando ha parlato della fotocamera di iPhone Xs, almeno questo è quello che pensa TechCrunch, in un articolo dove non si esita a definire alcune delle affermazioni che sono “fibs” che tradotto altro non significa che “balle”. Secondo il sito infatti, in qualche caso sono state osannate funzioni come novità assolute che non lo sono affatto altre volte sono stati lanciati superlativi per aggiornamenti che, schede tecniche alla mano, appaiono più come dei ritocchi. Insomma un intervento che avrebbe meritato di essere sottolineato ad ogni passaggio rispolverando lo stornello delle Iene

- 1 «La fotocamera più famosa al mondo»

- 2 «Nuovo straordinario sistema a doppia fotocamera»

- 3 «Sensore 2x più veloce…per una migliore qualità d’immagine»

- 4 «Di completamente nuovo c’è il modo in cui l’ISP si connette al Neural Engine, che ora funzionano insieme»

- 5 «Abbiamo una nuova funzionalità che abbiamo chiamato Smart HDR»

- 6 «Questo è quel che non dovreste fare: scattare una foto al sole, perché creerete foto sottoesposte»

- 7 «E’ possibile regolare la profondità di campo…questo non è stato mai reso possibile da nessun tipo di fotocamera»

«La fotocamera più famosa al mondo»

E’ vero, in commercio ci sono tantissimi iPhone, ma come fa notare TechCrunch i numeri parlano chiaro e gli smartphone (con fotocamera) più diffusi sono Android. Generalizzare poi con “fotocamera” è anche peggio, perché in questo caso bisogna tenere conto di compatte, reflex e mirrorless. Più probabile che le persone rispondano “Sony”, oppure “Nikon” o “Canon” quando si chiederà loro qual è la fotocamera più famosa al mondo, non trovate?

«Nuovo straordinario sistema a doppia fotocamera»

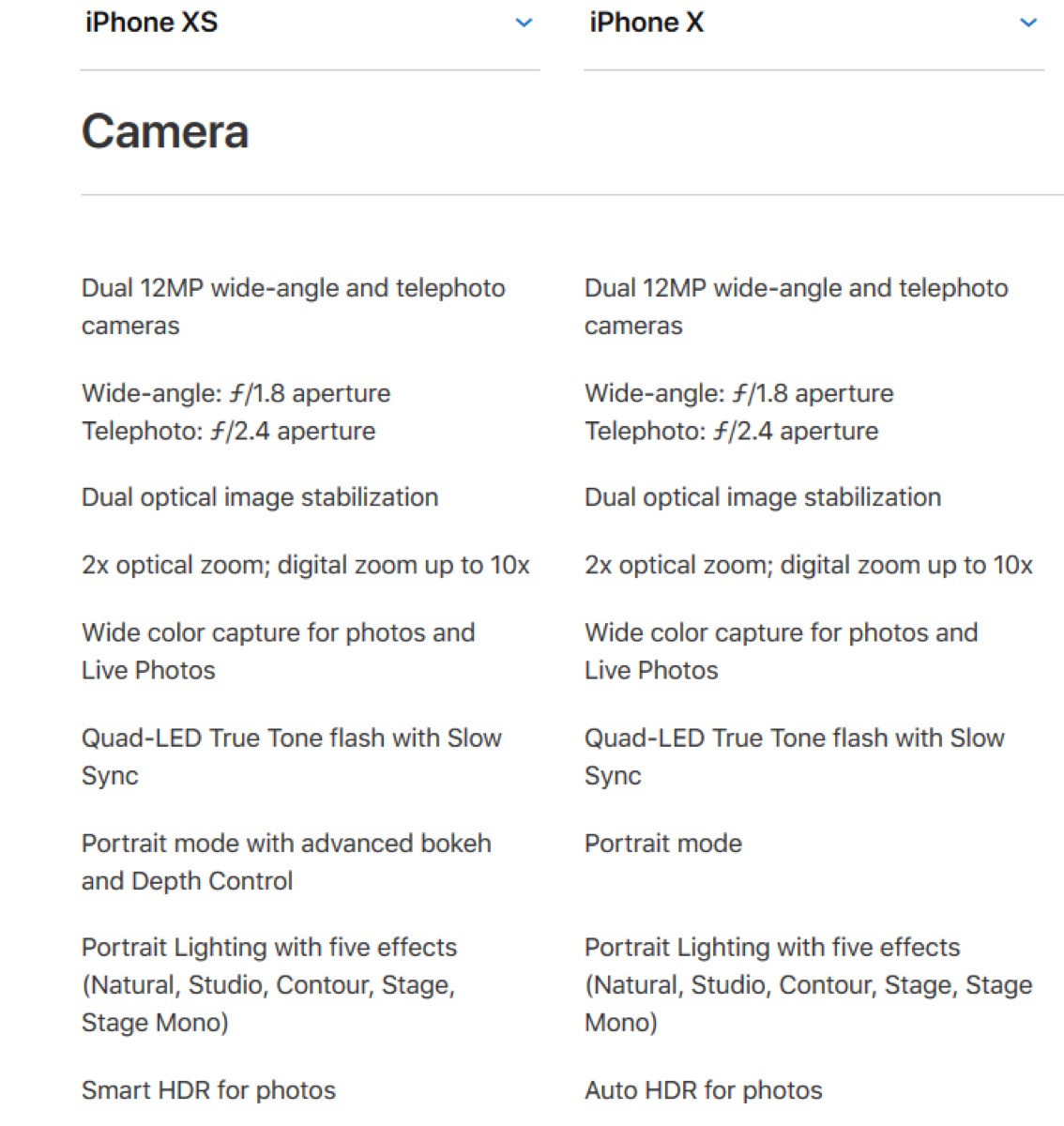

Sul palco dell’auditorium di Apple Park, Phil Schiller ha spiegato che gran parte delle novità fotografiche sono frutto di miglioramenti a sensori e processore d’immagine. Ha parlato però di “sistema nuovo”, mostrando un esploso dell’hardware della doppia fotocamera posteriore. In realtà però qui di diverso c’è ben poco: basta confrontare la scheda tecnica di iPhone X con quella di iPhone XS per notare ben poche differenze.

Se vi dicessimo che queste telecamere sono diverse, ci credereste? Stessa apertura di diaframma, apparentemente stesso sistema di stabilizzazione ottica. Insomma, Apple ha mostrato componenti uguali spacciandoli per “diversi”. Per TechCrunch la descrizione è del tutto «Fuorviante».

In realtà quel che cambia è il passo dei pixel sul sensore: 1,4 micrometri sulla fotocamera grandangolare, che è maggiore degli 1,22 micrometri della fotocamera di iPhone X. Poiché hanno gli stessi 12 MP, possiamo supporre che il sensore «Più grande» è semplicemente una conseguenza di questo diverso pixel pitch, e non una novità nelle dimensioni del sensore. Per un’analisi più approfondita si dovranno attendere test e confronti tra il vecchio e il nuovo modello.

«Sensore 2x più veloce…per una migliore qualità d’immagine»

Per chi mastica un po’ di fotografia questa frase è tutt’altro che chiara. Sappiamo che ad essere più veloce è il processore, ma come può questo migliorare la qualità dell’immagine? C’è più potenza per calcolare i colori, per codificare le immagini, per raccogliere la luce? Secondo TechCrunch questa dichiarazione sembra un po’ buttata là per far spettacolo, senza numeri reali o test che vanno più a fondo. Anche qui, un’analisi più approfondita (magari da professionisti) potrà chiarire ogni dubbio.

«Di completamente nuovo c’è il modo in cui l’ISP si connette al Neural Engine, che ora funzionano insieme»

Quel che forse Apple voleva spacciare come nuovo è la migliore integrazione del percorso di elaborazione delle immagini, con il processore che si occupa ad esempio di autofocus e colore mentre il Neural Engine (il motore neurale) rileva il volto. Ok, forse è una novità…per Apple, perché una tecnologia simile in realtà esiste da anni.

Sia diversi smartphone che moltissime reflex con lenti intercambiabili già utilizzano sistemi per il rilevamento di volto e occhi, tra questi diversi anche quelli che sfruttano reti neurali per guidare l’autofocus e l’esposizione. E’ qualcosa che troviamo anche in tantissime fotocamere “punta e scatta” e che negli anni ha avuto una sua evoluzione.

Quel che fa iPhone XS potrebbe sicuramente essere ancora migliore, ma non è sicuramente completamente nuovo per Apple, né per centinaia di smartphone e reflex già in commercio.

«Abbiamo una nuova funzionalità che abbiamo chiamato Smart HDR»

Quella che Apple chiama “nuova funzione” in realtà c’è già da tempo sui Google Pixel. Molte fotocamere già mantengono attivo un buffer del frame, sostanzialmente scattando foto in background mentre l’app è aperta ed utilizzando solo l’ultimo fotogramma quando si preme il pulsante di scatto. Google, tra le altre cose, è l’unica che fino ad oggi aveva avuto la brillante idea di usare queste immagini “invisibili” come materia prima per uno scatto in HDR.

Probabilmente il metodo che usa Apple è diverso e potrebbe anche essere migliore, ma fondamentalmente è la stessa cosa. Ancora una volta è stata usata la parola “Novità” che in realtà riguarda soltanto gli utenti iPhone, in quanto è ben nota tra i dispositivi di punta Android.

«Questo è quel che non dovreste fare: scattare una foto al sole, perché creerete foto sottoesposte»

Quando si include il Sole in una fotografia, il problema non è dell’esposizione, ma piuttosto della mancanza di una gamma dinamica causata da una grande differenza tra l’esposizione necessaria le catturare lo sfondo illuminato dal Sole e il soggetto in primo piano ovviamente sottoesposto.

Come dice giustamente Phil Schiller, questa è una delle migliori applicazioni dell’HDR, capace di bilanciare bene l’esposizione assicurando un soggetto ben dettagliato pur mantenendo correttamente esposto il paesaggio.

Peccato che nella foto scelta per spiegare come lavora il nuovo Smart HDR il soggetto pare tutt’altro che correttamente esposto. A dirla tutta – rincara TechCrunch – non c’è neanche bisogno di una qualche funzione HDR per catturare al meglio le gocce d’acqua, un particolare su cui invece Apple ha giocato molto nell’elogiare questa nuova tecnologia.

«E’ possibile regolare la profondità di campo…questo non è stato mai reso possibile da nessun tipo di fotocamera»

Via con lo slogan de Le Iene: regolare la profondità di campo è qualcosa che possono fare già i Galaxy S9 e presto sarà disponibile anche su Google Foto. Vi ricordate poi le fotocamere Lytro? Lo fanno già dal 2015. Questa volta l’errore non è stato soltanto quello di generalizzare al mercato delle fotocamere, ma la totale esclusione della concorrenza. Forse sarebbe stato meglio dire “E’ la prima volta…per un iPhone”.