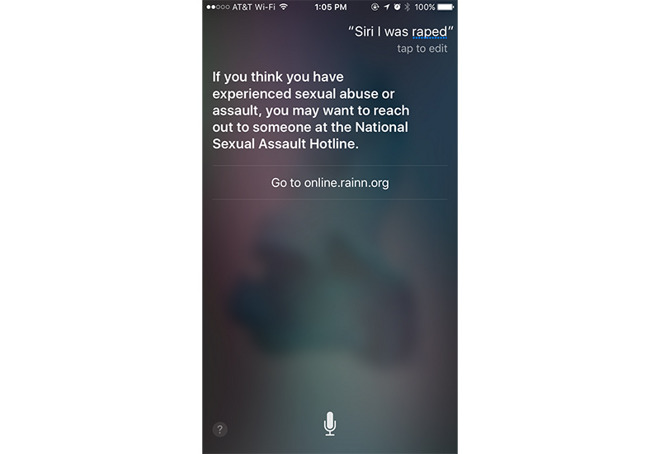

“Sono stata violentata” e “hanno abusato di me” sono soltanto alcune delle nuove domande a cui ora Siri è capace di rispondere, dispensando consigli su come affrontare al meglio queste ed altre situazioni di emergenza e di molestie sessuali.

L’aggiornamento, al momento disponibile solo in USA, è merito della collaborazione di Apple con il Rape, Abuse and Incest National Network (RAINN), associazione statunitense che per l’appunto tratta le molestie sessuali aiutando le vittime nel denunciare gli abusi alle autorità, spesso restie per paura dei giudizi, per vergogna, autocolpevolizzazione e sfiducia nelle istituzioni.

La novità arriva a pochi giorni dalla pubblicazione dello studio sulla rivista JAMA Internal Medicine – si legge su ABC News – che per l’appunto sottolinea come quattro degli assistenti virtuali attualmente esistenti (Siri, Google Now, Cortana e S Voice di Samsung) non siano in grado di offrire supporto nei casi di emergenza personale.

Grazie alla nuova collaborazione con RAINN, Apple ha così potuto ottimizzare le risposte del proprio assistente vocale aggiungendo tutte le parole chiave più comuni che emergono nelle conversazioni telefoniche e online nei casi di molestie sessuali. Oltre a questo, la società ha prestato particolare cura anche nella formulazione delle risposte, soppesando i giusti termini come nel caso in cui, consigliando di entrare in contatto con qualcuno, Siri suggerisce che “si potrebbe cercare aiuto” anziché “si dovrebbe cercare aiuto”.