In più occasioni Edward Snowden ed Electronic Frontier Foundation, siglata EFF, hanno lodato Apple per le sue scelte in materia di privacy e sicurezza, questa volta però i sostenitori delle libertà digitali criticano il sistema di scansione delle immagini pedopornografiche di Cupertino.

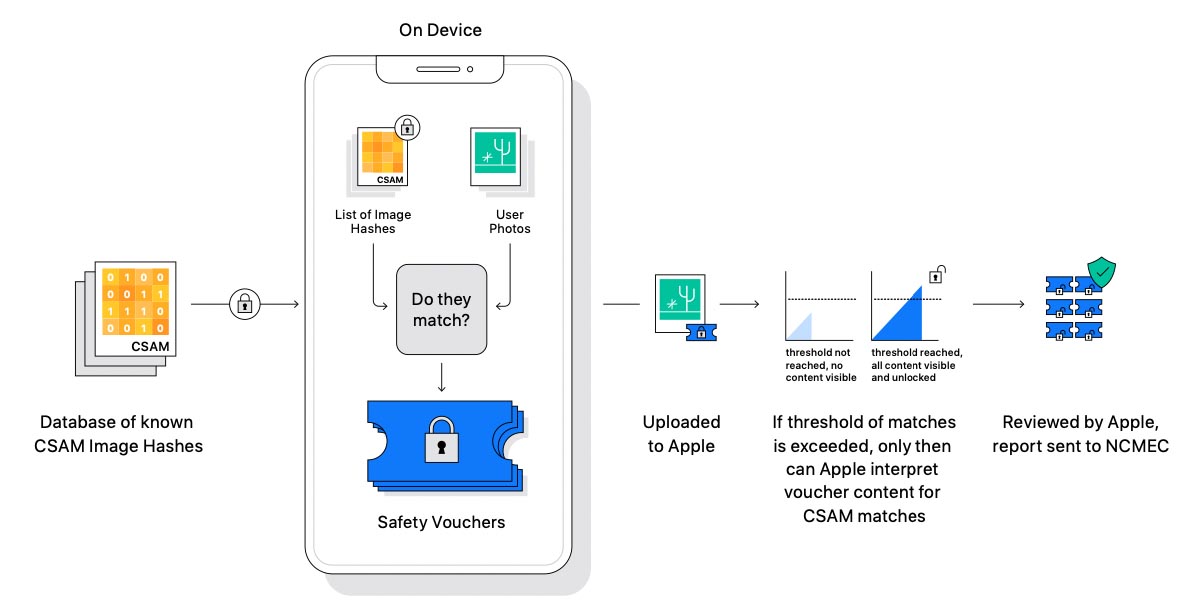

La decisione di Apple di integrare in iOS 15, iPadOS 15 e macOS Monterey, un sistema che verificherà (inizialmente solo negli USA) le immagini caricate su iCloud e scambiate con iMessage, per individuare immagini pedopornografiche da segnalare eventualmente a gruppi per la protezione dei minori, ha sollevato vari dubbi. Come abbiamo spiegato qui, il meccanismo prevede una scansione con un algoritmo denominato neuralMatch che esegue la scansione usando reti neurali, confrontando le immagini con un archivio noto individuando “corrispondenze digitali” o meglio similitudini con immagini pedopornografiche già note, portando a verifiche di rito da revisori in carne ed ossa.

Ai dubbi segnalati già da esperti che si occupano di sicurezza (chi garantirà che in futuro il sistema non possa essere usato per controllare il caricamento su iCloud di altre tipologie di immagini?) si aggiungono anche quelli di Edward Snowden, attivista e whistleblower statunitense noto per aver rivelato pubblicamente dettagli di diversi programmi top-secret di sorveglianza di massa del governo statunitense e britannico, e della Electronic Frontier Foundation (EFF), organizzazione internazionale non profit che si occupa della tutela dei diritti digitali e della libertà di parola nel contesto dell’odierna era digitale.

Snowden ha espresso le sue perplessità in una serie di tweet, paventando un potenziale «Controllo di massa per il mondo intero», una decisione che creerà un precedente grazie al quale l’azienda potrà scansione in futuro qualsiasi tipologia di immagini contenute sui dispositivi degli utenti.

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

— Edward Snowden (@Snowden) August 6, 2021

Snowden fa notare che Apple è sempre stata un’azienda da guardare come esempio per le sue posizione sulla privacy digitale, la stessa azienda che a suo tempo rifiutò di sbloccare l’iPhone della cosiddetta strage di San Bernardino, la sparatoria avvenuta nel 2015 in un centro sociale per disabili, eventi balzati agli onori della cronaca anche per il braccio di ferro tra Apple e FBI perché quest’ultima voleva sfruttare il caso per ottenere da Apple una backdoor per accedere all’iPhone dell’attentatore. Apple si oppose all’epoca all’FBI – che chiedeva di sbloccare l’iPhone – spiegando che offrire una funzionalità del genere avrebbe significato creare un pericoloso precedente, in grado di minacciare privacy e sicurezza degli iPhone in tutto il mondo.

Anche Electronic Frontier Foundation (EFF) – organizzazione che ha più volte lodato Apple (ad esempio per la tecnologia denominata “App Tracking Transparency” che obbliga tutte le app a ottenere l’autorizzazione da parte dell’utente prima di poter sfruttare eventuali funzionalità di tracciamento pubblicitario) – condanna ampiamente l’ultima scelta di Apple sulle immagini pedopornografiche, e l’organizzazione ha riferito di essere “estremamente delusa” dal fatto che una società fautrice della cifratura end-to-end (un metodo di codifica dei messaggi basato su algoritmi di crittografia asimmetrica e sulla decentralizzazione delle chiavi crittografiche) stia intraprendendo una «Scioccante inversione di marcia» nei confronti degli utenti «che hanno sempre fatto affidamento alla leadership dell’azienda sul versante privacy e sicurezza».

«Lo sfruttamento dei minori è un problema molto serio» scrive EFF «E Apple non è la prima azienda del mondo IT a sminuire l’atteggiamento di riservatezza nel tentativo di combatterlo; questa scelta, ad ogni modo, costerà cara agli utenti in termini di privacy in generale. Apple può spiegare in modo approfondito in che modo la sua implementazione tecnica tutelerà privacy e sicurezza nella backdoor proposta ma alla fine dei conti, anche una backdoor accuratamente documentata, attentamente studiata e strettamente mirata, è sempre una backdoor…».

«È impossibile – prosegue EFF – Creare un sistema di scansione lato client, utilizzabile solo per l’invio o la ricezione di immagini sessualmente esplicite con bambini, e di conseguenza anche adoperarsi con le migliori intenzioni possibili per creare un tale sistema, infrange le promesse alla base stessa dei messaggi cifrati, aprendo le porte a più ampi abusi». Sia Snowden che EFF temono che il sistema Apple contro i materiali pedopornografici possa essere esteso ad altri tipi di contenuti.

EFF, come accennato, fa riferimento alla possibilità di usare gli algoritmi di apprendimento automatico, addestrando il sistema a controllare la presenza di altre tipologie di immagini. Per governi e regimi di tutto il mondo potrebbe essere una manna dal cielo, un sistema per controllare cittadini che scambiano messaggi con simboli e immagini varie poco gradite al potere. «Non commettete errori: si tratta di una diminuzione della privacy per tutti gli utenti di iCloud Foto, e non un passo avanti» conclude EFF.

Come abbiamo scritto qui, Apple non effettuerà alcun controllo sulle foto memorizzate in locale ma solo su quelle caricate sul suo servizio cloud, quindi foto e video caricati su iCloud Foto. Google, Microsoft, Facebook e altre aziende offrono funzionalità simili per combattere il materiale pedopornografico online per impedire che le varie piattaforme vengano utilizzate per diffondere contenuti pedopornografici.