Un nuovo articolo su Machine Learning Journal – il blog preparato da Apple allo scopo di documentare le ricerche e le innovazioni dell’azienda nel campo dell’intelligenza artificiale e dell’apprendimento automatico – offre una panoramica sul lavoro dietro le quinte per consentire a Siri di riconoscere i nomi dei punti di interesse (POI, Point of interest) tenendo conto della localizzazione dell’utente.

Sfruttando i dati dell’Ufficio del Censimento statunitense Apple è riuscita a fare comprendere meglio a Siri la posizione dell’utente e determinare i POI per i quali quest’ultimo chiederà probabilmente informazioni. La Casa di Cupertino spiega che l’accuratezza dei sistemi di riconoscimento vocale è stata migliorata enormemente negli ultimi anni grazie alle tecnologie di deep learning. Le migliorie in termini di performance riguardano ad ogni modo il parlato in generale mentre il riconoscimento di nomi di entità come quelli di piccole imprese locali, rappresenta ancora un impedimento.

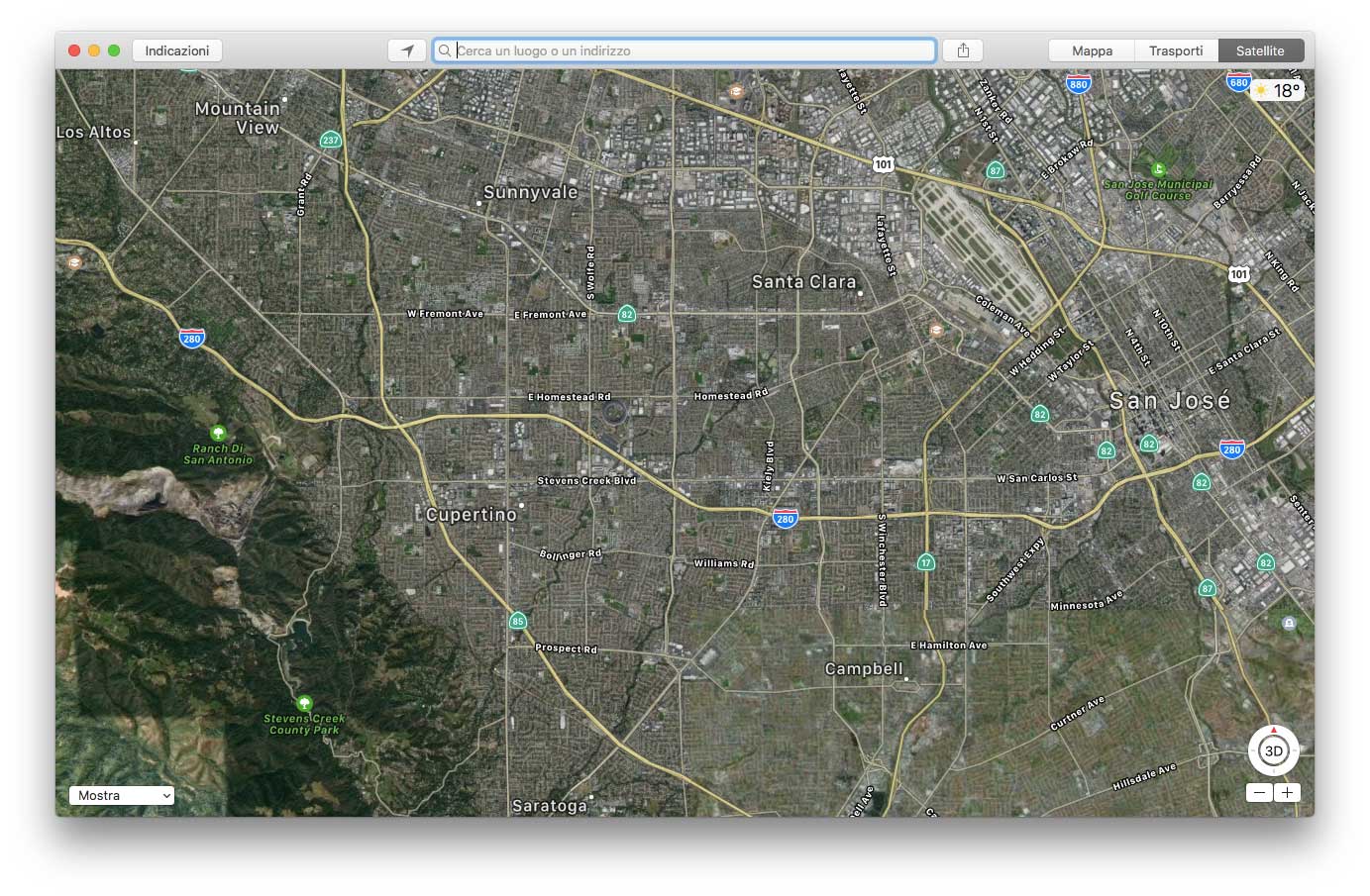

“Abbiamo deciso di migliorare la capacità di Siri di riconoscere i nomi dei POI locali” si legge nel post, “integrando nel nostro sistema di riconoscimento vocale conoscenze legate alla localizzazione dell’utente”. “Abbiamo definito aree geografiche combinando aree metropolitane statistiche (CSA, Combined Statistical Area) ottenute dall’Ufficio del Censimento. Le aree statistica combinate consistono in aree metropolitane limitrofe collegate economicamente e socialmente secondo pattern legati al pendolarismo. Esistono 169 CSA che coprono l’80% della popolazione USA. Abbiamo definito modelli di linguaggio geolocalizzati (Geo-LM) per ogni CSA, con un solo Geo-LM in grado di coprire aree non definite da CSA. Questo meccanismo è stato testato con successo in diverse importanti città degli Stati Uniti, con tassi di errore nelle risposte notevolmente ridotti. Nel post di Apple illustra i vantaggi di questi sistemi, spiegando che il meccanismo è utilizzabile anche con altre lingue e luoghi.