Apple a quanto pare è interessata a un sensore 3D per la fotocamera frontale sviluppato da Sony, elemento che potrebbe essere sfruttato al posto della scansione a luce strutturata presente nella TrueDepth Camera di iPhone X e dispositivi seguenti.

L’azienda giapponese, già fornitore di Apple, ha creato un hardware che sfrutta la tecnologia time of flight (ToF) per catturare le immagini in 3D generando mappe di profondità calcolando il tempo impiegato dagli impulsi laser o dalla luce laser modulata per rimbalzare sulla superficie di un oggetto.

Satoshi Yoshihara, general manager responsabile dei sensori presso Sony, ha riferito che l’azienda intende avviare la produzione di chip 3D dalla prossima estate per soddisfare la domanda di “numerosi” produttori di smartphone, uno dei quali potrebbe essere Apple.

Sony, riferisce Bloomberg Quint, controlla quasi la metà del mercato dei chip che consentono di gestire le fotocamere degli smartphone e tra i suoi clienti ci sono: Apple, Alphabet (la società sotto il cui “cappello” c’è anche Google) e Samsung Electronics. Yoshihara non ha voluto fare nomi parlando di accordi di riservatezza ma accordi sono stati siglati anche con Huawei Technologies.

L’azienda giapponese non è l’unica che produce chip 3D ma sistemi simili sono stati creati anche da Lumentum e STMicroelectronics, mettendo a disposizioni soluzioni che consentono di sbloccare i telefoni con il volto o misurare la profondità per migliorare la messa a fuoco quando si scattano foto in ambienti con poca luce.

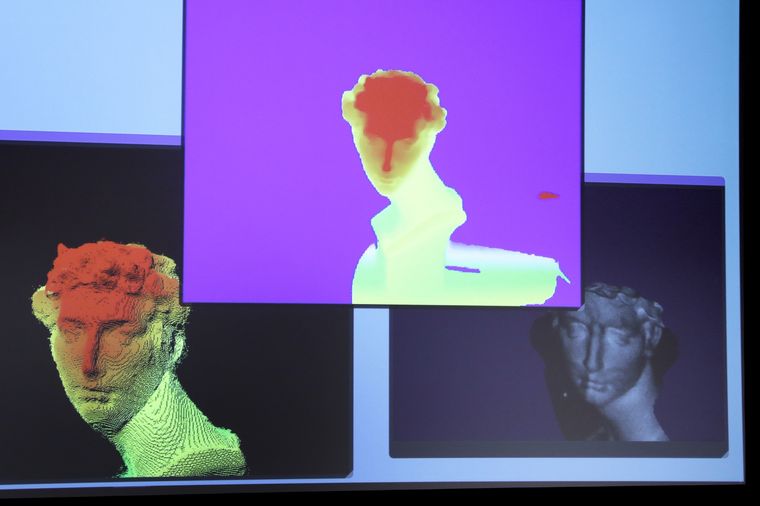

La tecnologia TrueDepth di Apple sfrutta i laser a cavità verticale a emissione superficiale (Vertical Cavity Surface Emitting, VCSEL) analizzando più di 30.000 punti invisibili per creare una mappa di profondità dei volti e cattura un’immagine a infrarossi. Una parte del motore neurale del chip A11, A12 Bionic e A12X Bionic trasforma la mappa di profondità e l’immagine a infrarossi in una rappresentazione matematica che confronta con i dati facciali registrati.

Il sistema di Sony consente di leggere i volti in 3D sfruttando la tecnologia time of flight (TOF) creando una mappa ottenuta misurando il tempo impiegato da una particella a percorrere una certa distanza avanti e indietro. Secondo Yoshihara, il sistema TOF non solo è più accurato rispetto alla scansione a luce strutturata ma è anche in grado di funzionare a distanze maggiori.

Non è la prima volta che si parla dell’intenzione di Apple di adottare il sistema TOF. Una simile voce era emersa a giugno dello scorso anno evidenziando possibili applicazioni non solo per il riconoscimento dei volti ma anche nell’ambito della Realtà Aumentata.