Il mercato dell’intelligenza artificiale (ma anche quello azionario) è stato sconquassato dalla improvvisa popolarità di DeepSeek, avanzato modello AI sviluppato da una startup nata grazie a fondi speculativi cinesi e che sembra in grado di rivaleggiare con o1 di OpenAI e alcuni dei modelli AI più avanzati degli USA.

DeepSeek ha creato trambusto perché in grado di offrire risultati comparabili a quelli che si ottengono con tecnologie sfrutto di investimenti miliardari, sfidando i presupposti fondamentali sull’economia e sulla struttura del mercato AI.

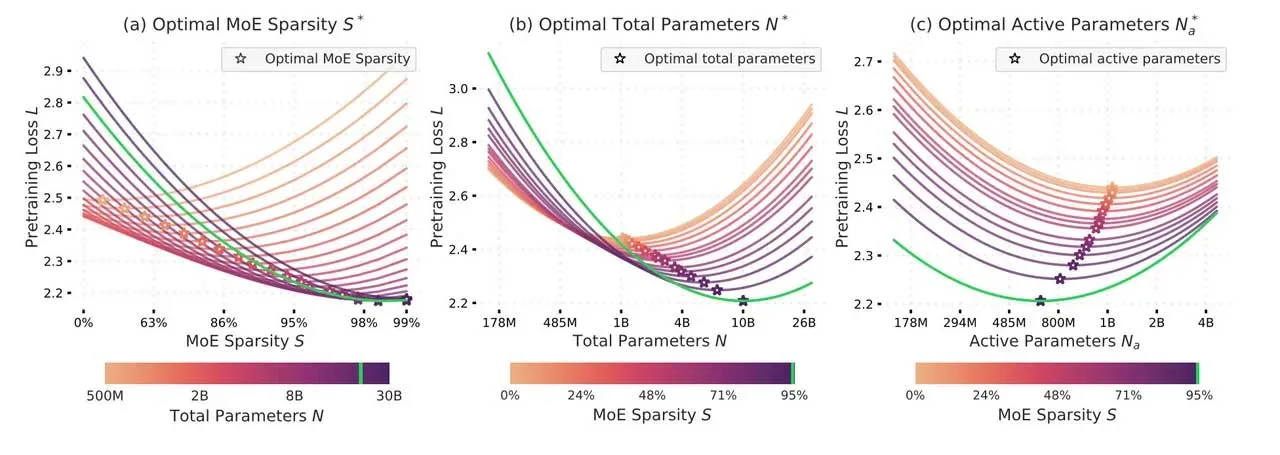

Apple non ha alcun legame con DeepSeek ma si occupa da tempo di intelligenza artificiale e in un documento intitolato “Parameters vs FLOPs: Scaling Laws for Optimal Sparsity for Mixture-of-Experts Language Models” pubblicato su arXiv (archivio di pubblicazioni scientifiche), l’autore principale, Samir Abnar di Apple, e altri ricercatori della Casa di Cupertino, insieme al collaboratore Harshay Shah del MIT, evidenziano la possibilità di sfruttare architetture che attivano una parte di una rete neurale per ogni compito specifico, migliorando l’efficienza e riducendo i costi hardware.

Abnar e il team di collaboratori in Apple, hanno condotto studi sfruttando una libreria di codice denominata “MegaBlocks” rilasciata nel 2023 da ricercatori AI di Microsoft, Google, e Università di Stanford, ma fanno capire come tecniche simili possono essere applicate da DeepSeek e altre innovazioni recenti nel settore AI.

DeepSeek e altre AI possono sfruttare architetture focalizzate sul miglioramento del ragionamento, ottimizzando l’efficienza pur mantenendo prestazioni elevate in contesti specifici; nel documento, i ricercatori Apple dimostrano che non è necessario sfruttare sempre la massima potenza per la comprensione e risoluzione di problemi matematici e affini.

Un fenomeno sottolineato inoltre dai ricercatori Apple è quello delle “curve di perdita”, con modelli che possono imparare gradualmente, imparando a riconoscere da esempi, vedendoli anche una sola volta, un concetto in contrapposizione con il tradizionale approccio all’approfondimento profondo (deep learning).

Elementi come questi spiegano l’approccio di DeepSeek, particolarmente rilevante perché richiede meno risorse computazionali rispetto ai concorrenti, meccanismi che potrebbero rivoluzionare l’approccio all’addestramento delle reti neurali, con modelli pre-addestrati di grandi dimensioni in grado di “imparare” da un numero molto più limitato di esempi di quanto precedentemente pensato.

Per capire come funziona DeepSeek e perché al debutto ha fatto crollare i maggiori titoli tecnologici USA rimandiamo a questo approfondimento . Tutti gli articoli dedicati all’Intelligenza Artificiale sono nella sezione dedicata di macitynet.