Volete guadagnare un milione di euro? Se siete abbastanza bravi da dimostrare la possibilità di “hackerare” i server di Apple Intelligence, la Mela è pronta a offrire fino a un milione di euro.

Questo e altri premi sono parte del programma di “bug bounty”, ricompense destinate ad esperti in cybersicurezza, allo scopo di ottenere aiuto per capire se esistono vulnerabilità o backdoor di cui Apple non ha tenuto conto, un modo per poter dire ad alta voce di non voler nascondere nulla e, anzi, di voler proteggere i clienti.

Le ricompense, come abbiamo riferito qui, sono pensate per chi dimostra la presenza di vulnerabilità nel Private Cloud Compute, i server che Apple invita a “scardinare” e attaccare per dimostrare la sicurezza e la possibilità di pregiudicare i dati.

Oltre ad iniziative pensate per gli esperti di sicurezza, Apple ha riferito di essere pronta a test indipendenti, invitando esperti a ispezionare il codice eseguito sui server con chip Apple per verificare costantemente che il livello di privacy sia esattamene quello promesso.

In un post sul blog di Apple dedicato alla sicurezza, si spiega che l’azienda consente auditing esterni, accesso anticipato ad alcuni ricercatori specializzati in sicurezza e anche accesso alle risorse create per il progetto, inclusi Virtual Research Environment (VRE), ambienti di lavoro digitali che facilitino la ricerca e in particolare l’analisi dei dati in maniera distribuita e collaborativa.

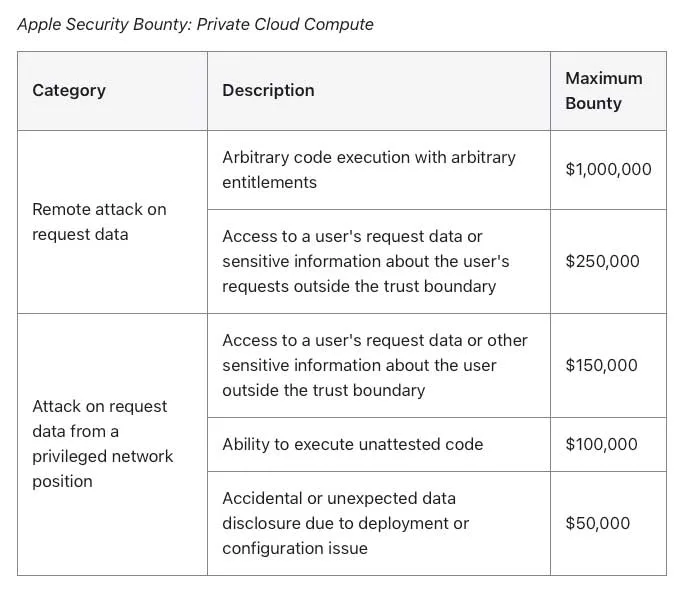

Le categorie nel programma di bug bounty includono la divulgazione accidentale dei dati, la compromissione dall’esterno partendo da richieste utente, e altre vulnerabilità accedendo fisicamente o internamente. I premi per chi scopre vulnerabilità legate al PCC partono da 50.000$ per arrivare a 1.000.000$.

Secondo la Casa di Cupertino tutte le funzionalità di cui si tiene conto con il PCC sono “uno straordinario passo avanti per la privacy nell’AI”. Il post sul blog di Apple si conclude affermando: “Riteniamo che il Private Cloud Compute sia la più avanzata architettura di sicurezza mai dispiegata per il cloud computing AI su larga scala, e non vediamo l’ora di lavorare con la comunità dei ricercatori per creare fiducia nel sistema, e renderlo ancora più sicuro e privato nel corso del tempo”.