Sente la voce ma non capisce le parole. Si potrebbe resuscitare un vecchio slogan pubblicitario di fronte all’esito del test su Siri (e i concorrenti), svolto dall’agenzia di marketing Stone Temple Consulting. Dalla prova sembra infatti emergere che l’assistente virtuale della Mela, come apparso da altre iniziative di misurazione della precisione dei sistemi di comprensione del linguaggio, perde il confronto con tutti i rivali

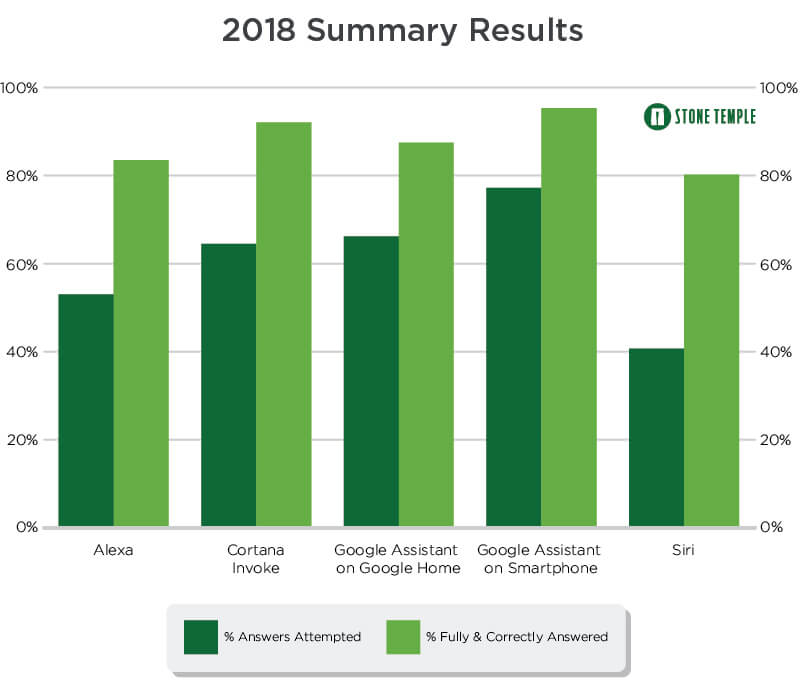

La battaglia degli assistenti vocali, naturalmente, è stata decisa a colpi di risposte fornita dai vari interlocutori digitali. Precisamente, lo studio è stato condotto su due fronti: capacità di rispondere al maggior numero di domanda e capacità di dare le risposte in modo corretto: in termini pratici, non capisce quel che diciamo. L’app Google Assistant installata su smartphone è stata in grado di battere la controparte Alexa di Amazon, Cortana di Microsoft, e Siri (per il quale del resto Apple cerca nuovi ingegneri) su entrambi i fronti.

Non è chiaro quali siano esattamente i dispositivi usati nell’esperimento, ma l’autore rende noto di possedere Home di Google, Pixel 2, iPhone e Amazon Echo. Google Assistant su smartphone fa meglio rispetto alla sua controparte su Google Home, tuttavia, entrambe le versioni dell’assistente di Big G risultano migliori di tutti gli altri assistenti, in entrambe le categorie dell’esperimento. La sola eccezione è Cortana, che risponde alle domande in modo più profondo, rispetto ad Assistant utilizzato su Google Home.

Dietro Google, la medaglia d’oro la ottiene Cortana di Microsoft, che in entrambe le categorie del test risulta essere molto vicini a Google. Amazon Alexa fa un buon lavoro nel rispondere correttamente alle domande, mentre Siri di Apple è molto indietro: risponde bene alle domande, ma non sembra essere così completo.

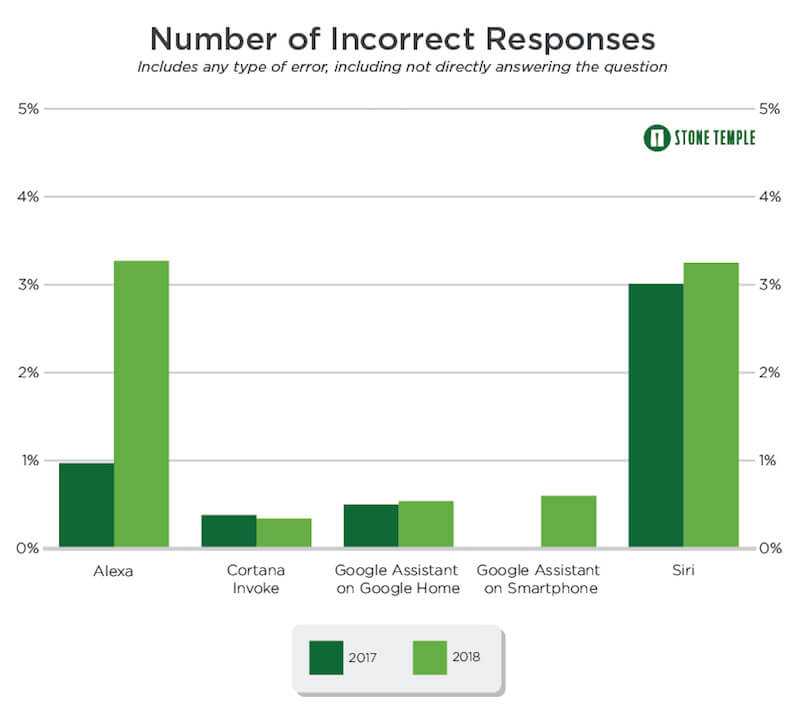

Per eseguire l’esperimento, i tester hanno consegnato un totale di 24.710 domande, un campione piuttosto elevato. Un secondo grafico diffuso da Stone Temple Consulting, visibile appena in basso, fornisce anche una visione chiara di quante siano state le risposte non corrette fornite dagli assistenti: anche in questo caso, purtroppo, a sbagliare di più,o oltre ad Alexa, è Siri di Apple. Tra tutti i quattro assistenti, Cortana ha il tasso più basso di risposte errate, superando entrambe le versioni di Google Assistant.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)