Nella seconda beta di iOS 18.4, versione preliminare di iOS che nel momento in cui scriviamo è stata distribuita ai soli sviluppatori, Apple mette a disposizione la Visual Intelligence anche su iPhone 15 Pro e iPhone 15 Pro Max, due dispositivi che finora non supportavano questa funzionalità.

Fino adesso, l’intelligenza visiva – funzionalità che permette di ottenere informazioni su luoghi e oggetti – era disponibile solo sugli iPhone 16, richiamabile tenendo premuto il controllo fotocamera per eseguire operazioni come cercare dettagli su un ristorante o su un’attività, tradurre, riassumere o leggere un testo, identificare piante e animali e altro ancora.

Su iPhone 15 Pro Max la funzione Visual Intelligence può essere richiamata dal tasto Azione o dal Control Center. Andando su Impostazioni > Tasto Azione è possibile selezionare la voce “Intelligenza visiva” tra le azioni che è possibile assegnare al tasto Azione, e quindi il la Visual Intelligence non è più limitata a iPhone 16, 16 Plus, 16 Pro e 16 Pro Max.

Ricordiamo che l’intelligenza visiva è disponibile anche su iPhone 16e, anche qui personalizzando il tasto Azione o la schermata di blocco oppure aprendo Centro di Controllo.

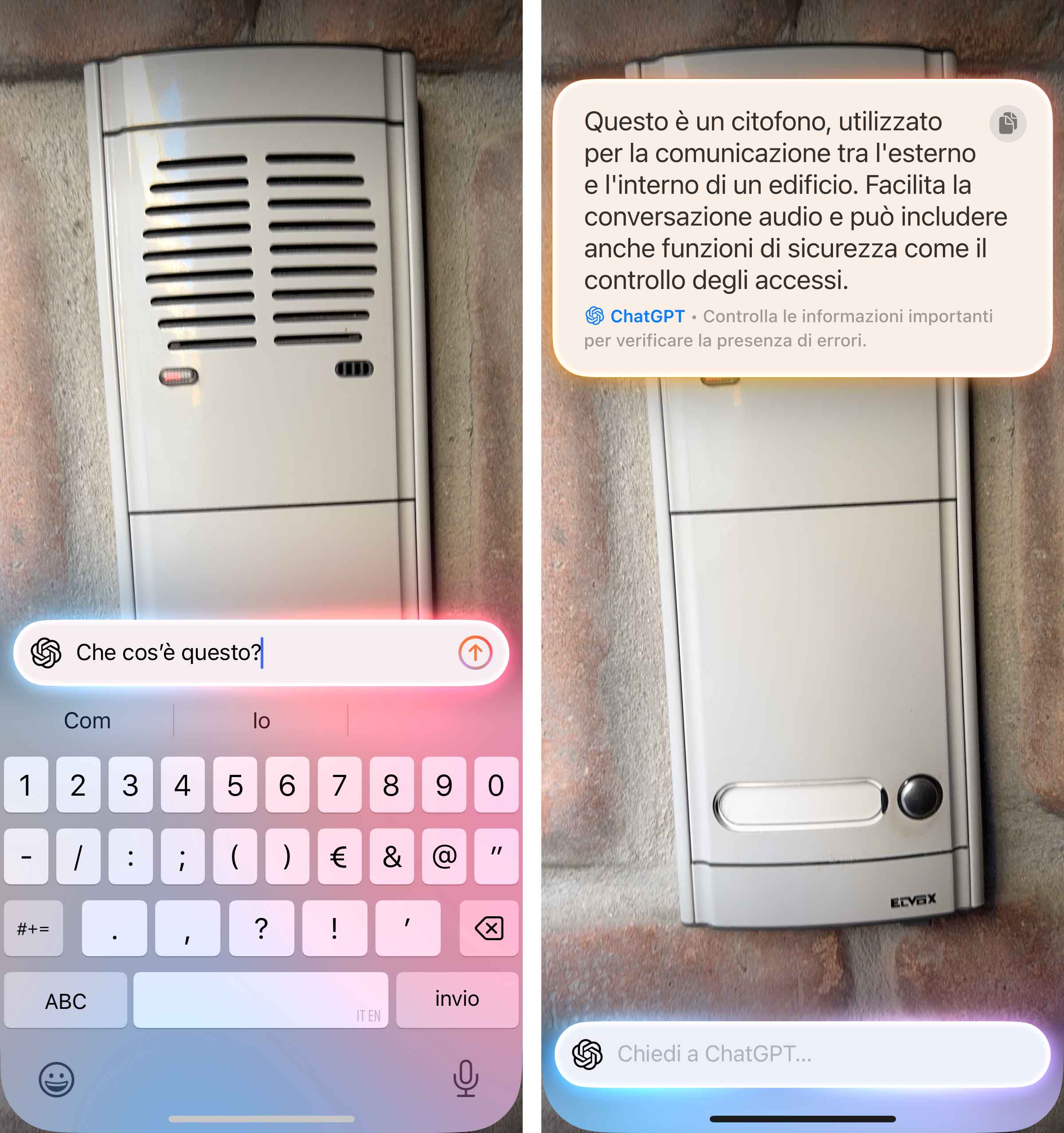

Con l’intelligenza visiva è possibile ottenere informazioni riguardo un attività (es. gli orari di apertura), identificare animali e piante ma anche interagire con il testo (ad esempio riassumere e tradurre un testo o leggerlo ad alta voce, identificare le informazioni di contatto in un testo, come i numeri di telefono e gli indirizzi email o i siti web, ed effettuare azioni in base al tipo di testo), chiedere a ChatGPT informazioni riguardo a ciò che stiamo vedendo, cercare elementi simili su Google, creare un evento nell’app Calendario quando ne vediamo uno su un poster o su un volantino e altro ancora.

Sempre a partire da una immagine o foto è possibile effettuare ricerche su Google per scoprire dove è possibile acquistare un articolo, o di sfruttare le capacità di problem solving di ChatGPT per chiedere spiegazioni su un diagramma complesso, per esempio negli appunti di una lezione.

L’utente ha il controllo su quando questi strumenti di terze parti vengono usati e su quali informazioni vengono condivise. È un primo esempio di AI multimodale offerto da Apple, con funzioni disponibili “al volo” senza bisogno di girare prima video o scattare immagini e poi effettuare la richiesta.

Per tutte le notizie che ruotano attorno a iOS 18 il link da seguire è direttamente questo,