Le prestazioni di ChatGPT sia in termini di velocità che di affidabilità delle risposte dipendono sia dai modelli di Intelligenza Artificiale AI di grandi dimensioni che dalla disponibilità di potenza di calcolo e quindi dal numero di processori grafici GPU disponibili, per lo più forniti da Nvidia: anche per questa ragione OpenAI sta valutando di progettare e produrre direttamente chip AI.

Anche se il piano interno di OpenAI risalirebbe fino allo scorso anno è portato alla luce in questi giorni da Reuters. Non solo si starebbe valutando la creazione di chip proprietari dedicati alla intelligenza artificiale, ma OpenAI si sarebbe persino spinta al punto di prendere in considerazione anche l’acquisizione di una società.

OpenAI ha fame di chip AI

Per il momento non sono emerse azioni concrete, ma il piano in discussione ha senso per diverse ragioni. Già in passato Sam Altman, fondatore e CEO di Open Ai, ha indicato che le preoccupazioni degli utenti su velocità e affidabilità delle API sono dovute alla carenza di GPU. Per questa ragione la società ha incrementato l’acquisto di chip grafici prodotti da Nvidia.

Nvidia e il dominio dei processori per Intelligenza Artificiale

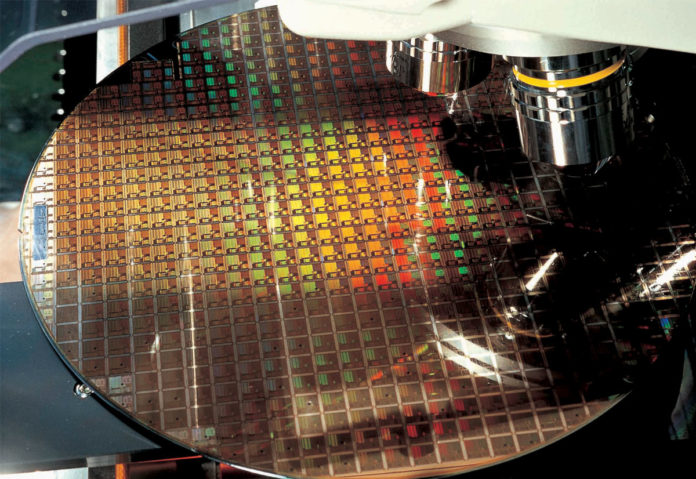

È noto che per sviluppare la sua tecnologia OpenAI ha impiegato un super computer Microsoft funzionante grazie a 10.000 GPU Nvidia. Ma la scarsità di queste componenti non è l’unica ragione. Secondo un’analisi di Bernstein ogni richiesta utente a ChatGPT costa circa 4 centesimi per OpenAI. Nei primi due mesi di funzionamento il chatbot ha registrato 100 milioni di utenti attivi al mese.

Se richieste e domande a ChatGPT raggiungessero anche solamente un decimo del volume di traffico delle ricerche di Google, si stima che OpenAI avrebbe bisogno di GPU Nvidia pari a un valore di circa 48 miliardi di dollari solo per iniziare, oltre a 16 miliardi di dollari di GPU ogni anno.

Tutti i colossi della tecnologia progettano chip AI

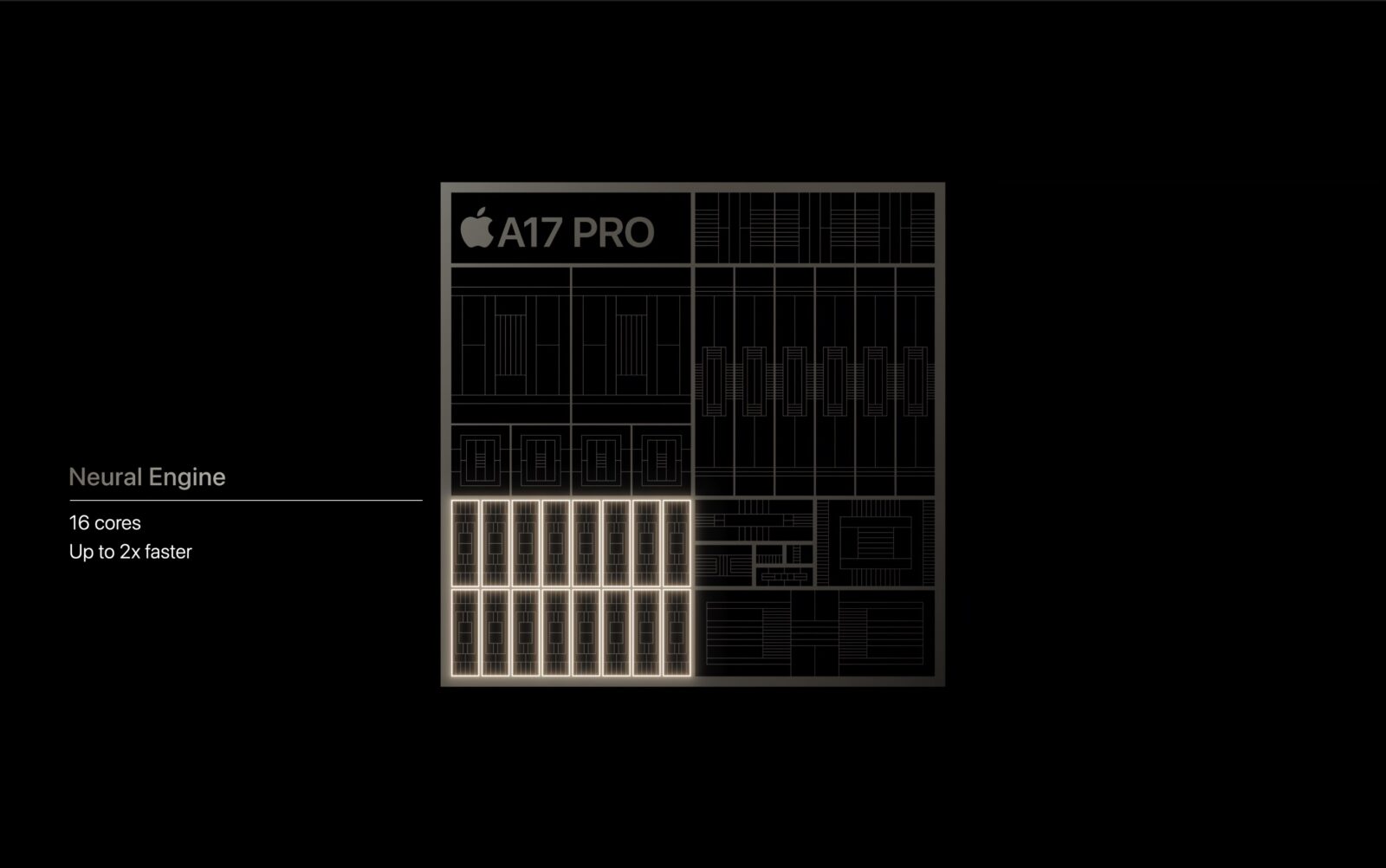

Il costo salato delle GPU e il dominio di Nvidia sono i fattori che hanno già spinto altri colossi della tecnologia a progettare chip AI proprietari, così come stanno facendo Google; Microsoft fino dal 2019 e Tesla: Apple è stata tra i primi a integrare core AI Neural Engine nei suoi processori.

Si tratta di manovre molto complesse e costose che richiedono anni di sviluppo. Anche se OpenAI decidesse di progettare chip AI proprietari i risultati concreti saranno visibili solamente tra diversi anni.

Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili nella sezione dedicata di macitynet.