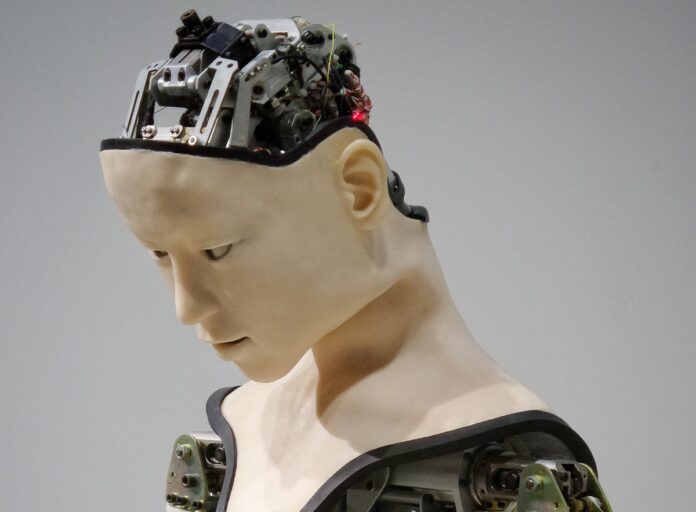

Prima del licenziamento di Sam Altman, il CEO a capo di OpenAI, diversi ricercatori dello staff dell’azienda che gestisce il sistema di intelligenza artificiale ChatGPT avevano inviato una lettera al consiglio di amministrazione avvisando di una importante scoperta nel settore dell’intelligenza artificiale, qualcosa che potrebbe diventare una minaccia per l’umanità.

A riferire a Reuters questa indiscrezione sono due persone legate a OpenAI che hanno voluto rimanere anonime. La lettera in questione, gli algoritmi AI ai quali si fa riferimento, e una guerra interna, a quanto pure sono stati alcuni degli elementi che avrebbero portato alla decisione del licenziamento di Altman (poi reintegrato).

Prima del trionfale ritorno in azienda (quasi tutti i dipendenti di OpenAI avevano firmato una lettera per chiederne il reintegro minacciando altrimenti le dimissioni in massa), Altman aveva già ottenuto l’assunzione da parte di Microsoft; ora alcuni membri del consiglio di amministrazione saranno sostituiti e solo uno dei membri in carica manterrà il posto.

Secondo le fonti citate da Reuters, il progetto denominato Q* (si pronuncia Q-Star) è indicato internamente come una svolta notevole verso la superintelligenza, nota come artificial general intelligence (AGI).

OpenAI definisce l’AGI come un sistema di IA ancora più intelligente; sfruttando vaste risorse di calcolo, il nuovo modello è in grado di risolvere alcuni problemi matematici. Si tratta di problemi semplici ma contrariamente all’AI generativa, che genera testi o sequenze di parole successive sempre diverse, in base ai contesti precedenti, l’AGI deve fornire sempre una risposta precisa, elemento che implica capacità di ragionamento che ricordano quelle degli esseri umani.

Questa modalità di “pensare” potrebbe essere applicata a ricerche in ambito scientifico. Anziché risolvere un numero limitato di operazioni, l’AGI è in grado di generalizzare, imparare e comprendere. Nella lettera al consiglio di amministrazione, i ricercatori hanno indicato queste abilità come pericolose; le fonti di Reuters non hanno indicato nello specifico quali sono i dubbi in termini di sicurezza, ma da tempo si discute dei pericoli dell’AI e le possibili conseguenze di una tecnologia fuori controllo.

Il filosofo svedese Nick Bostrom, oggi direttore del Future of Humanity Institute presso l’Università di Oxford, definisce la superintelligenza “qualunque intelletto che superi di molto le prestazioni cognitive degli esseri umani in quasi tutti i domini di interesse”, spiegando che il divario che si verrebbe a creare fra superintelligenza e intelligenza umana sarebbe paragonabile a quello fra un essere umano e un verme. Solo che questa volta il verme siamo noi.

Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili a partire da questa pagina di macitynet