Fotografare una lavagna piena di formule o caricare uno schizzo appena abbozzato per ricevere una risposta. È questa la promessa dei nuovi modelli di Intelligenza Artificiale lanciati da OpenAI: o3 e o4-mini. progettati, dice lo sviluppatore “per offrire capacità di ragionamento avanzate” e definiti come “i modelli più smart rilasciati fino ad oggi”.

“Modello” ed Intelligenza Artificiale?

Nel contesto dell’AI, un modello è un software addestrato su grandi quantità di dati, che apprende schemi, logiche, associazioni tra concetti e modi di rispondere alle domande. È ciò che permette a strumenti come ChatGPT e a tutte le altre piattaforme di intelligenza artificiale di scrivere testi, risolvere esercizi, tradurre lingue, creare immagini, analizzare dati o ragionare su problemi complessi.

Con ogni nuova generazione di modelli, questi sistemi diventano più bravi a capire il contesto, gestire compiti articolati, spiegarsi meglio e commettere meno errori.

o3, ragionamento, visione e coding

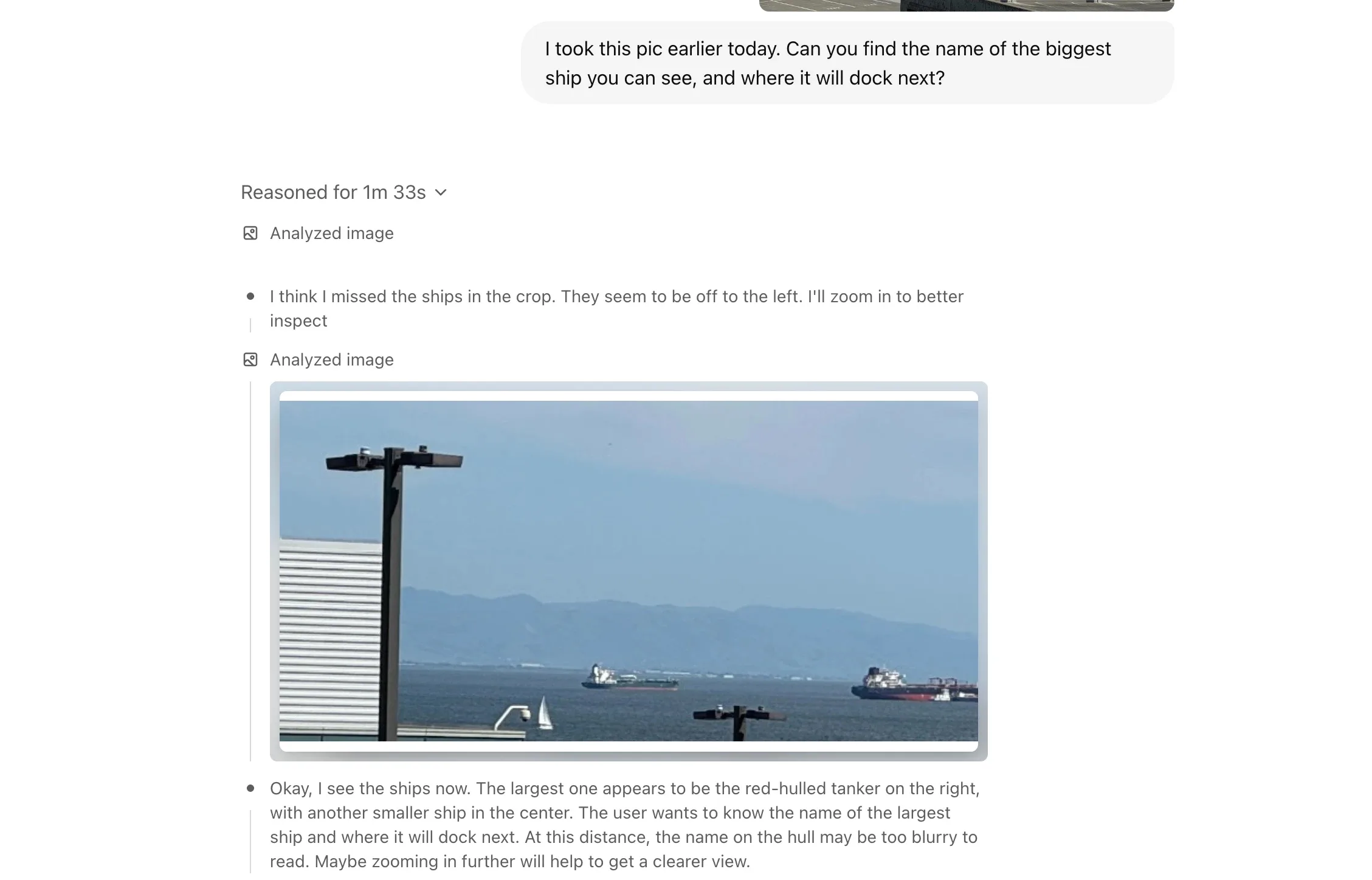

I nuovi modelli o3 e o4-mini prometto un cambio di passo in questa ottica: combinano più strumenti in un’unica interfaccia ChatGPT, tra cui la ricerca sul web, l’analisi di file con Python, la comprensione visiva avanzata e la generazione di immagini. Il loro punto di forza è saper decidere quando e come usare questi strumenti, in modo da fornire risposte più complete, accurate e rapide (di solito in meno di un minuto).

OpenAI spiega che o3 punta al coding, nella matematica, nelle scienze e nella percezione visiva. È utile per domande complesse, decifrare un grafico tecnico, trovare errori in un codice, o ragionare su più passaggi logici alla volta.

Diventa così possibile, ad esempio, caricare la foto di una lavagna bianca, uno schema tracciato su un foglio o un disegno sfocato, o3 sarà in grado di leggerlo, ruotarlo, ingrandirlo e comprenderlo, anche se l’immagine è parziale o di scarsa qualità. La capacità di “ragionare attraverso le immagini” è uno dei salti qualitativi più rilevanti di questa generazione.

o4-mini: potenza smart leggera

OpenAI propone o4-mini, un modello ottimizzato per attività meno complesse. Nonostante sia la versione più leggera, funziona bene per matematica, programmazione e analisi visiva. L’idea è offrire prestazioni elevate con un consumo di risorse più contenuto e con meno limitazioni rispetto ai modelli precedenti della stessa fascia.

Entrambi i modelli sono stati sviluppati per essere più naturali e conversazionali, e restituiscono risposte più utili, dettagliate e verificabili, migliorando l’esperienza utente anche per chi non è esperto di tecnologia.

Il contesto competitivo

Il lancio di o3 e o4-mini si inserisce in una fase di forte competizione tra i colossi dell’AI. Claude 3 di Anthropic, ad esempio, è apprezzato per la sua estrema precisione nei testi lunghi e per una comprensione fine del contesto conversazionale. È particolarmente indicato per chi lavora con documenti complessi o ha bisogno di interazioni fluide e coerenti nel tempo.

Gemini di Google (ex Bard), dal canto suo, punta sull’ integrazione con i servizi di Big G, come Gmail, Google Drive, Docs, e YouTube. Il suo punto di forza è quindi la capacità di lavorare su informazioni personali e contenuti cloud in tempo reale ed è rivolto a chi è dentro all’ecosistema Google o ha intenzione di valorizzarlo.

In confronto, OpenAI con o3 sta puntando su una visione più universale: modelli in grado di fare non solo conversazione o scrivere testi, ma anche vedere, ragionare, calcolare e interagire in modo autonomo. È un’evoluzione che guarda già agli agenti AI del futuro, capaci di agire al posto dell’utente su compiti sempre più articolati.

Come provare o3 e o4-mini

I modelli o3, o4-mini e anche o4-mini-high sono già disponibili per gli utenti ChatGPT Plus, Pro e Team, e sostituiscono i precedenti o1, o3-mini e o3-mini-high.

Chiunque però può provare gratuitamente o4-mini utilizzando l’opzione “Avvia il ragionamento” che compare nel composer (la casella in cui si scrivono le richieste) al momento dell’invio.

Tutte le notizie sull’Intelligenza Artificiale sono raccolte nella sezione dedicata di Macitynet