La robotica unita all’intelligenza artificiale promette miracoli e solleva dibattiti, anche per quel che concerne la sicurezza. C’è chi pensa alla presenza di un robot in casa come pericolosa, stile “I,Robot” di Will Smith. Eppure, Nvidia potrebbe mettere d’accordo tutti, con l’interessante idea di sfruttare Vision Pro di Apple per addestrare e controllare robot.

Nvidia ha introdotto una nuovo servizio di controllo che consente agli sviluppatori di lavorare su progetti riguardanti robot umanoidi, utilizzando Apple Vision Pro per il controllo e il monitoraggio degli stessi. Con questo nuovo progetto, già mostrato in un video ufficiale, Nvidia rende disponibili diversi strumenti per la simulazione robotica, alcuni dei quali assistono addirittura nel controllare i robot stessi.

La raccolta di strumenti presentati da Nvidia include microservizi e framework NIM, ma quel che probabilmente è più interessante è la possibilità di sfruttare il visore di Apple per controllare veri e propri robot.

Controllo con Apple Vision Pro

I microservizi NIM sono contenitori predefiniti che utilizzano il software di inferenza di Nvidia, progettati per ridurre i tempi di deployment. Uno di essi, il microservizio MimicGen NIM, è utilizzato per aiutare gli utenti a controllare hardware tramite l’Apple Vision Pro o un altro dispositivo di computing spaziale.

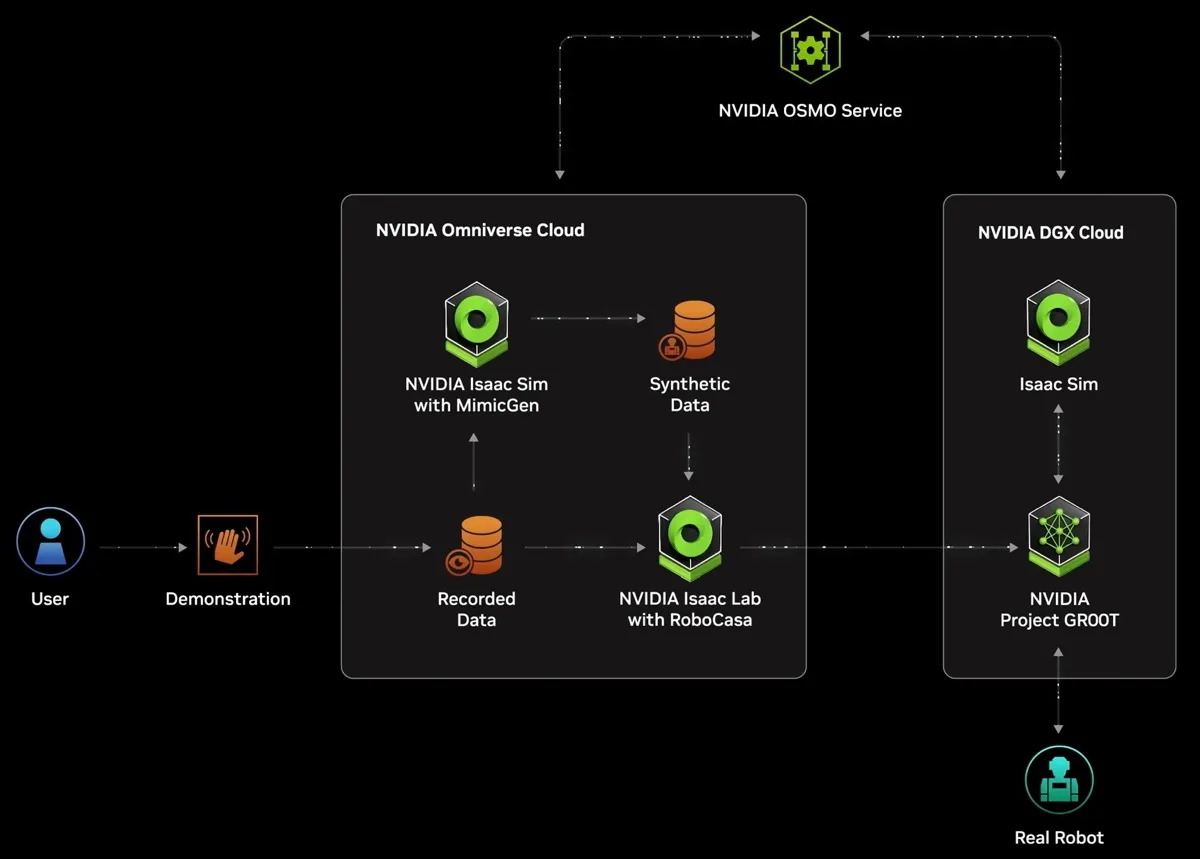

In pratica, il sistema genera dati di movimento sintetici per il robot basandosi su “dati teleoperativi registrati,” traducendo i movimenti fatti dall’utente tramite Apple Vision Pro in movimenti reali effettuati dal robot.

Video e immagini mostrano che questo sistema non si limita a spostare una telecamera in base ai movimenti del visore. In pratica, mentre l’utente muove le mani nella realtà virtuale tramite il visore, nella realtà un robot copia gli esatti movimenti.

In pratica, gli utenti possono osservare i movimenti del robot e controllarne direttamente mani e braccia, tutto tramite Apple Vision Pro. Sebbene tali robot umanoidi potrebbero già in autonomia tentare di imitare esattamente i gesti umani, sistemi come quelli di Nvidia traducono i movimenti dell’utente in movimenti del robot.

Come mostra il video, durante queste prime dimostrazioni, è stato utilizzato un Apple Vision Pro anche per catturare i movimenti delle mani di una persona. Questi sono stati poi utilizzati per simulare registrazioni tramite il microservizio MimicGen NIM e Nvidia Isaac Sim, che ha generato dataset sintetici.

Gli sviluppatori hanno potuto così addestrare un modello umanoide Project Groot con una combinazione di dati reali e sintetici. Questo processo è considerato utile per ridurre i costi e il tempo necessario per creare i dati.

I microservizi, insieme all’accesso ai modelli, al servizio di gestione robotica OSMO e ad altri framework, sono offerti nell’ambito del Programma Sviluppatori di Robot Umanoidi Nvidia. L’accesso, al momento, è fornito dall’azienda esclusivamente ai produttori di software, hardware o robot umanoidi.

Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili a partire da questa pagina di macitynet.