Quante volte l’intelligenza artificiale spietata, brutta e cattiva ha cercato di conquistare il mondo oppure di distruggerlo? Solo il cinema è pieno di esempi piuttosto facili da citare: dal supercomputer che gioca alla “guerra termonucleare totale” di “WarGames” (1983) al mitico Hal 9000 (il cui nome era la traslitterazione di una posizione della sigla IBM) di “2001 Odissea nello spazio” (1969), oppure lo Skynet della saga di “Terminator” (iniziata nel 1984) per passare ovviamente a “Matrix” (saga iniziata nel 1999). E come dimenticare “Il mondo dei robot” del 1973 con i cowboy guidati da Yul Brynner che si ribellano? Scritto e diretto da Michael Crichton, è stata l’ispirazione della serie “Westworld“, molto bella ma complessa da seguire (sempre con la stessa idea del computer senziente che ci vuol far fuori).

I nonni e le nonne delle AI di oggi

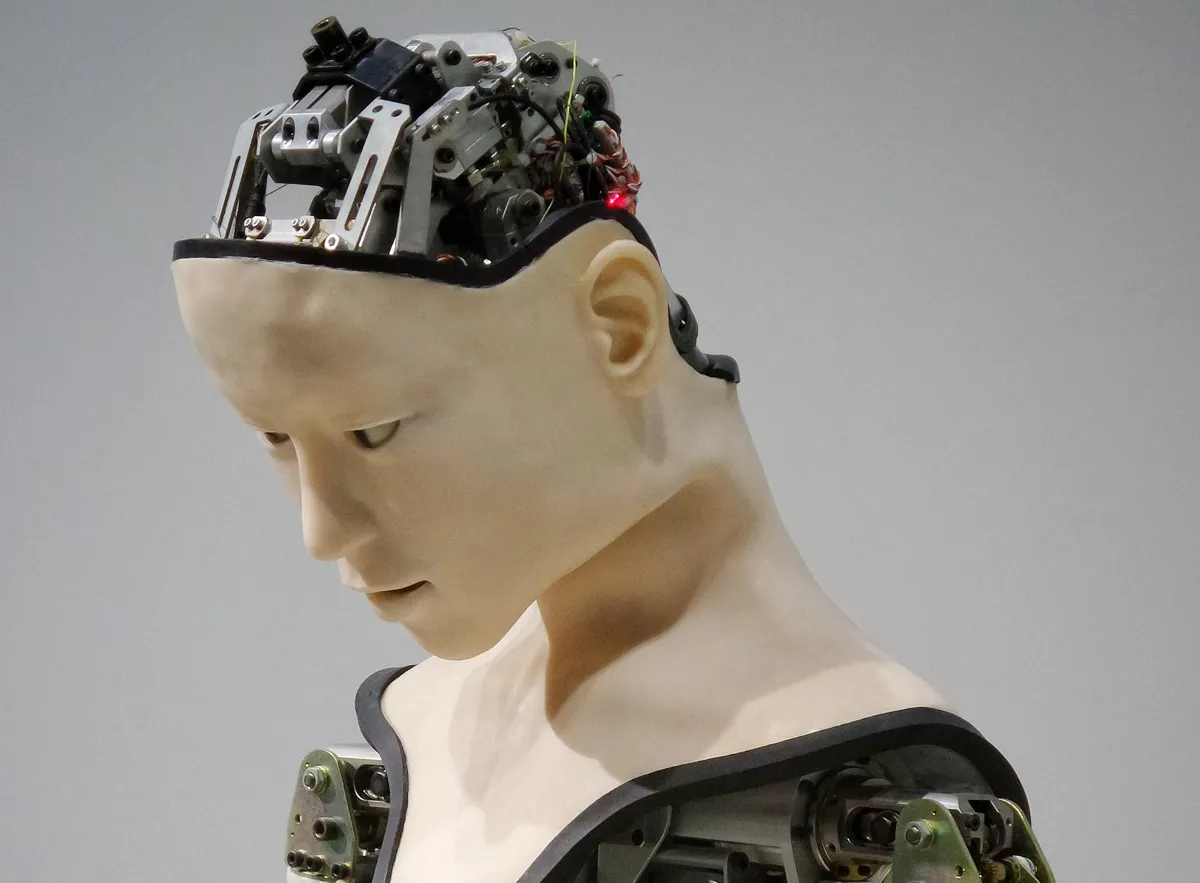

Nel cinema i robot senzienti e cattivi sono arrivati molto presto, riflesso della fantascienza degli anni Quaranta. Chi sono i “nonni” e le “nonne” di tutti i robot senzienti (mix di intelligenza artificiale e corpo umanoide) che ci vogliono far fuori?

Si può cominciare da “Metropolis” di Fritz Lang (1927) con l’iconica robot Maria, che è la prima creatura meccanica senziente della storia del cinema, seguita poi da “Ultimatum alla Terra” (1951) con il robot al servizio dell’alieno, pronto a sterminarci tutti. Ci sono poi “Il pianeta proibito“, un film di fantascienza del 1956 molto bello ambientato su un pianeta lontano e con un robot iconico, Robby, e ovviamente classici come “Kronos il conquistatore dell’universo” (1957) e “Il colosso di New York” (1958).

Non solo cinema: anche la televisione ci ha regalato da molto tempo dei robot senzienti e cattivissimi (almeno, verso di noi). Un classico sono i Dalek del “Dr. Who“, che da una vita cercano di far fuori l’immortale viaggiatore del tempo protagonista della serie della BBC. C’è anche “La fabbrica delle mogli” (1975) che è quasi una storia horror ambientata nella ricca periferia americana, e ovviamente i robot di Star Wars (saga iniziata nel 1977) che non sono tutti buoni, o gli androidi di Blade Runner (1982) che è stato preceduto nel 1980 dal bellissimo (e sottovalutato) “Saturno 3“.

Ancora, “Tron” (1982) e decine di altri film hollywoodiani, ma anche tantissimi anime giapponesi, a partire da “Patlabor“, “Appleseed” e ovviamente “Ghost in the Shell“, che nella vita artificiale e non trova il senso della sua ricerca narrativa, sino ad arrivare ai Borg di “Star Trek” e al bellissimo “Gigante di ferro“, cartone animato delicato e consigliatissimo per seguire la storia di un’amicizia tra un bambino e un robot gigantesco.

Dai film ai libri e viceversa

E questi sono quelli che vengono in mente, di primo acchito, con un piccolo aiutino per ritrovare le date esatte di uscita dei film. La fantascienza letteraria e a fumetti è strapiena di computer senzienti il cui scopo è farci fuori tutti. Almeno, la maggior parte delle volte, da Isaac Asimov a Philip K. Dick. Sono talmente tanti che non ha praticamente senso mettere assieme una lista. Però è questa la base sulla quale lavoriamo quando parliamo delle nuove intelligenze artificiali conversazionali di cui ChatGPT 4, l’ultimissima versione delle AI conversazionali, è il punto di partenza.

Infatti OpenAI ha deciso di verificare se GPT 4 può davvero conquistare il mondo: “La valutazione di ARC è che c’è una probabilità molto più bassa di portare a una conquista del mondo da parte dell’AI rispetto all’implementazione stessa”.

Perché è stato fatto questo test?

Nell’ambito dei test di sicurezza pre-rilascio del suo nuovo modello di IA GPT 4, lanciato martedì scorso, OpenAI ha concesso a un gruppo che fa test sulle AI di valutare i rischi potenziali delle capacità emergenti (quindi non esplicitamente previste) del nuovo modello, tra cui il “comportamento di ricerca di potere”, l’auto-replicazione e l’auto-miglioramento.

Sebbene il gruppo di test abbia riscontrato che GPT 4 sia “inefficace nel compito di replicazione autonoma“, la natura degli esperimenti solleva qualche domanda sulla sicurezza dei futuri sistemi di AI. Perché è stato fatto questo test?

“Nei modelli più potenti emergono spesso nuove capacità“, scrive OpenAI in un documento sulla sicurezza di GPT 4. Alcune di queste particolarmente preoccupanti sono la capacità di creare e agire su piani a lungo termine, di accumulare potere e risorse (“power-seeking”) e di esibire un comportamento sempre più “agonistico”. In questo caso, OpenAI chiarisce che il termine “competitivo” non intende necessariamente umanizzare i modelli o dichiarare che sono senzienti, ma semplicemente indicare la capacità di raggiungere obiettivi indipendenti.

Allarme AI

Nell’ultimo decennio, alcuni ricercatori di IA hanno lanciato l’allarme sul fatto che modelli di IA sufficientemente potenti, se non adeguatamente controllati, potrebbero rappresentare una minaccia esistenziale per l’umanità (spesso chiamata “x-risk”, espressione che sta per rischio esistenziale, cioè dell’esistenza della nostra specie). In particolare, la “presa di potere dell’AI” è un futuro ipotetico in cui l’intelligenza artificiale supera quella umana e diventa la forza dominante del pianeta. In questo scenario, i sistemi di AI acquisiscono la capacità di controllare o manipolare il comportamento umano, le risorse e le istituzioni, portando solitamente a conseguenze catastrofiche.

Sembra fantascienza, vero? In parte lo è, ma le ricerche fanno pensare di no. E allora come si può fare? A causa di questo potenziale rischio X, movimenti filosofici come l’Altruismo Efficace (“EA”) cercano di trovare il modo di evitare che l’AI prenda il sopravvento. Questo ha portato alla creazione di un campo di studio separato, ma spesso interconnesso, chiamato “ricerca sull’allineamento dell’AI“. Per “allineamento” di una AI si intende il processo volto a garantire che i comportamenti di un sistema di AI siano in linea con quelli dei suoi creatori o operatori umani.

In generale, l’obiettivo è quello di evitare che l’AI faccia cose che vanno contro gli interessi umani. Si tratta di un’area di ricerca attiva ma anche controversa, con opinioni diverse sul modo migliore di affrontare la questione, oltre a divergenze sul significato e sulla natura stessa dell'”allineamento”.

Ripensando alle tre leggi della robotica di Isaac Asimov, che con “Io, Robot” ha scritto forse una delle raccolte di racconti più belli e struggenti della narrativa mondiale a tema intelligenza artificiale, viene da chiedersi: perché non adottarle?

Le tre leggi della robotica:

- Un robot non può recar danno a un essere umano né può permettere che, a causa del suo mancato intervento, un essere umano riceva danno.

- Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non vadano in contrasto alla Prima Legge.

- Un robot deve proteggere la propria esistenza, purché la salvaguardia di essa non contrasti con la Prima o con la Seconda Legge.

Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili a partire da questa pagina di macitynet.