Conoscendo Apple e seguendola dal 1996, l’anno di nascita di Macity, ci sono alcune cose che sono decisamente chiare. Una di queste è che l’azienda, da quando tornò alla sua guida il fondatore Steve Jobs, è allergica a qualsiasi anticipazione. Nuovi prodotti, nuovi software, nuovi servizi: non si comunica niente di niente. È un mantra che anche l’era Tim Cook segue con assoluta e religiosa attenzione. Perché, spiegò una volta Steve Jobs, le aziende che anticipano i prodotti futuri mentre ancora stanno vendendo quelli attuali semplicemente si sparano sui piedi e rischiano di fallire.

Per questo motivo le volte in cui Apple ha effettivamente anticipato prodotti hardware, software o servizi si contano letteralmente sulle dita di una mano. Non intendiamo qui fare riferimento alle anticipazioni di qualche settimana, quando i prodotti sono semplicemente in corso di spedizione, bensì delle lunghe pause e attese.

Un esempio spettacolare è ovviamente l’iPhone, che nella sua prima incarnazione venne annunciato a gennaio e commercializzato solo a giugno. Oppure il Mac Pro “a cilindro”, che venne annunciato da Phil Schiller, l’ex capo del marketing mondiale, ma che arrivò parecchi mesi dopo.

Le ragioni del segreto

I prodotti non si annunciano prima che siano pronti non solo perché potrebbero cannibalizzare il loro stesso mercato, ma anche perché potrebbero non essere mai perfezionabili e non uscire dai centri di ricerca, test e sviluppo. Come AirPower, il sistema di ricarica contactless di più apparecchi contemporaneamente pensato e voluto da Apple al punto da essere annunciato e solo dopo quasi due anni cancellato perché “irrealizzabile”. Ecco, capita molto spesso che ci siano cose irrealizzabili, ma le aziende cercano (o dovrebbero cercare) di tenerla nascoste ben bene tra le pieghe dei loro centri di ricerca. Apple sistematicamente lo fa.

Tutto questo per dire che la giornata di presentazione delle novità in tema di accessibilità che Apple ha appena fatto per quanto riguarda le sue piattaforme (iPhone, iPad e Mac), in concomitanza con la giornata dell’accessibilità (la GAAD, Global Accessibility Awareness Day) sono sorprendenti non solo per l’interesse e la ottima qualità delle innovazioni presentate per l’uso assistito degli apparecchi di Apple, ma anche perché arrivano in anticipo di parecchi mesi, visto che verranno presentate solo “entro l’anno” (forse).

Le novità

“In Apple – ha detto Tim Cook – abbiamo sempre creduto che la migliore tecnologia sia quella costruita per tutti. Oggi siamo entusiasti di condividere nuove incredibili funzionalità che si basano sulla nostra lunga storia di rendere la tecnologia accessibile, in modo che tutti abbiano l’opportunità di creare, comunicare e fare ciò che amano”.

Apple dunque anticipa e mostra quel che è possibile fare con i suoi dispositivi. E lo fa con la convinzione di una azienda che ha messo l’accessibilità fin dal principio nei processi di costruzione dei suoi prodotti. L’accessibilità viene pensata sin dal primo momento di concezione e fa parte del Dna di ogni singolo prodotto hardware e software o servizio. In questo modo non è un pensiero che viene dopo bensì una preoccupazione costante fin dal momento del primo sviluppo. L’unico modo perché tutto sia integrato.

Point and Speak

La prima è forse una delle più utili per le persone che non vedono bene o sono completamente prive di capacità di visione. Point and Speak dentro l’app iPhone Lente di ingrandimento facilita gli utenti con disabilità visive nell’interazione con gli oggetti fisici che hanno diverse etichette di testo.

Ad esempio, durante l’utilizzo di un apparecchio elettrico, come un microonde, Point and Speak combina gli input provenienti dall’app Fotocamera, dallo scanner LiDAR e dal machine learning del dispositivo per ‘annunciare’ il testo su ciascun pulsante mentre l’utente muove il dito sulla tastiera.

Point and Speak è integrato nell’app Lente di ingrandimento su iPhone e iPad con LiDAR Scanner. Point and Speak può essere utilizzato con altre funzioni di Lente di ingrandimento, come il rilevamento delle persone, il rilevamento delle porte e le descrizioni delle immagini, per aiutare gli utenti a orientarsi nell’ambiente fisico.

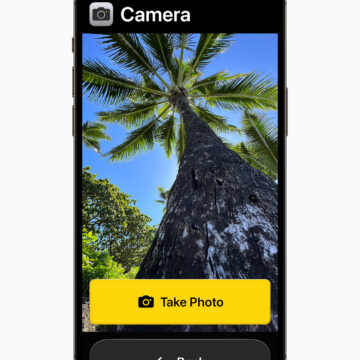

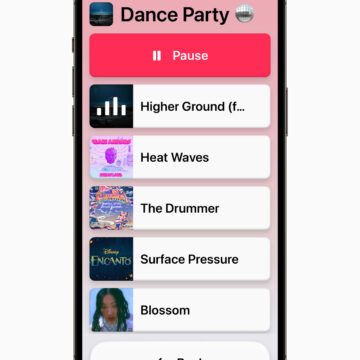

Assistive Access

Altra cosa molto interessante per chi ha difficoltà cognitive. Si tratta di Assistive Access, che include un’esperienza personalizzata per Telefono e FaceTime, che sono stati combinati in un’unica app Chiamate, oltre a Messaggi, Fotocamera, Foto e Musica.

La funzione offre un’interfaccia distinta con pulsanti ad alto contrasto e grandi etichette di testo, oltre a strumenti che aiutano la persona di fiducia che assiste la persona disabile ad adattare l’esperienza della persona che assistono. Assistive Access utilizza le innovazioni del design per ridurre le app e le esperienze alle loro caratteristiche essenziali, al fine di alleggerire il carico cognitivo.

La funzione riflette il feedback delle persone con disabilità cognitive e delle persone di fiducia che li assistono, concentrandosi sulle attività che amano e che sono fondamentali per l’iPhone e l’iPad.

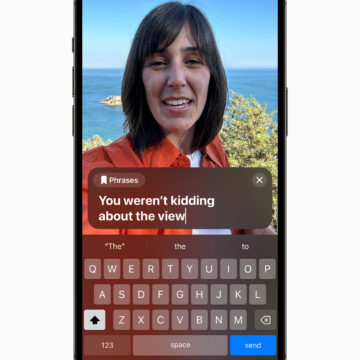

Live Speech

Altra funzionalità molto interessante è Live Speech su iPhone, iPad e Mac, grazie alla quale gli utenti possono digitare ciò che vogliono dire e farlo pronunciare ad alta voce durante le chiamate telefoniche, FaceTime e le conversazioni in persona.

Gli utenti possono anche salvare le frasi più usate per intervenire rapidamente durante le conversazioni con familiari, amici e colleghi. Live Speech è stato progettato per aiutare milioni di persone in tutto il mondo che non sono in grado di parlare o che hanno perso l’uso della parola nel tempo.

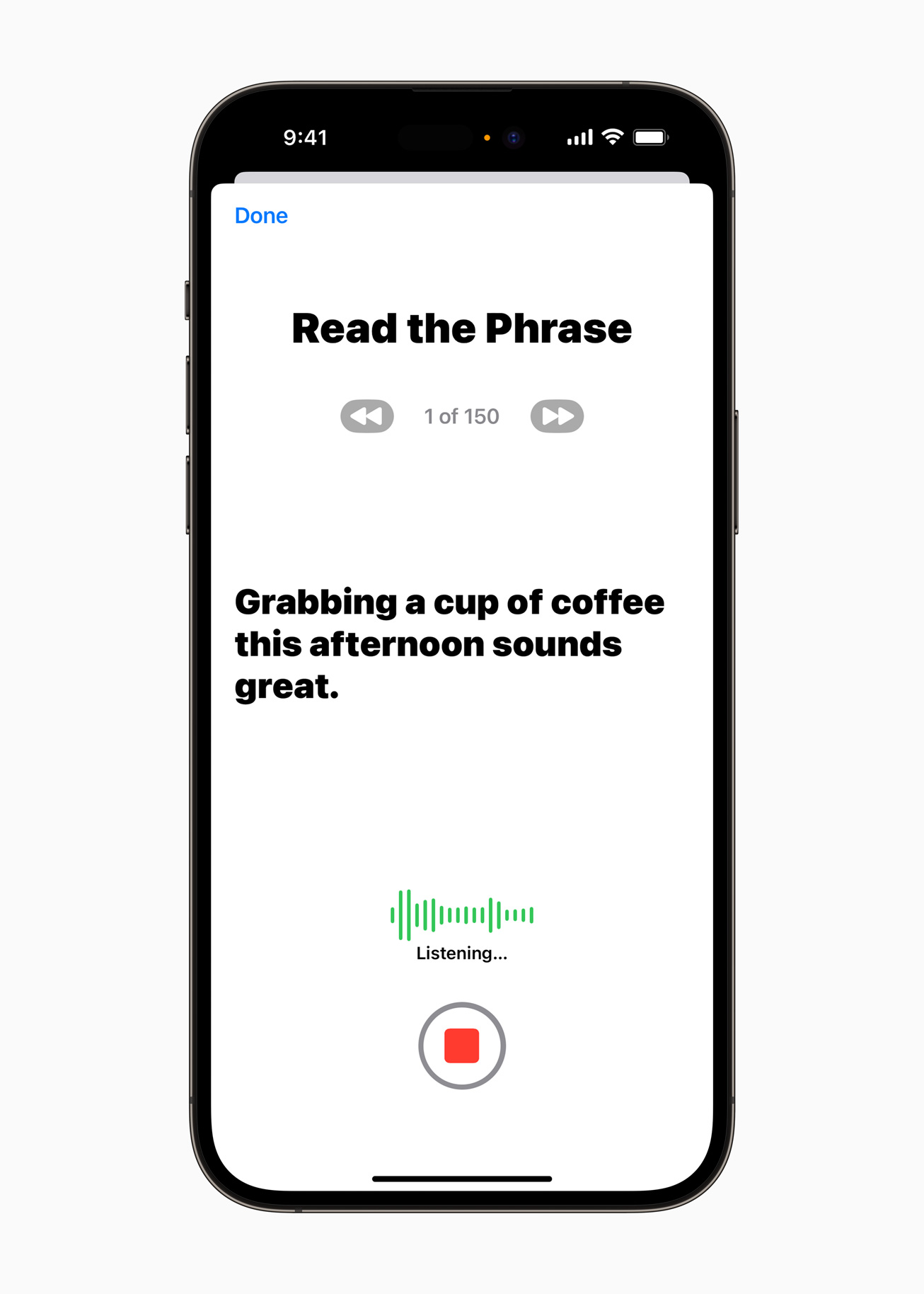

Personal Voice

Forse la funzionalità della quale si sta parlando di più. Per gli utenti che rischiano di perdere la capacità di parlare, Personal Voice è un modo semplice e sicuro per creare una voce che assomigli alla loro. Ma è un modo “sicuro” per farlo, perché progettato per non essere possibile abusarne.

Progettato per utenti come quelli con una recente diagnosi di SLA (sclerosi laterale amiotrofica) o altre patologie che possono compromettere progressivamente la capacità di parlare.

Gli utenti possono creare una voce personale leggendo messaggi di testo generati casualmente per registrare 15 minuti di audio su iPhone e iPad. Personal Voice utilizza il machine learning sul dispositivo per mantenere le informazioni degli utenti private e sicure, e si integra perfettamente con Live Speech in modo che gli utenti possano parlare con la loro voce personale quando si connettono con i propri cari.

La cultura non è acqua

Non è un caso se Apple da anni è al lavoro per fornire questo tipo di servizi e funzionalità, se partecipa sempre alla giornata sulla consapevolezza del bisogno di accessibilità, che si terrà il 18 maggio, e se viene riconosciuto alle piattaforme di Apple un primato in termini di accessibilità diretta (senza bisogno di app di terze parti) rispetto alla concorrenza.

Questi risultati non arrivano per caso e non arrivano da soli. Apple lavora in stretta collaborazione con i gruppi della comunità che rappresentano un ampio spettro di utenti con disabilità per sviluppare funzioni di accessibilità che abbiano un impatto reale sulla vita delle persone.

L’anticipazione di questi temi per il grande pubblico è un modo per regalare un momento di consapevolezza che faccia pensare innanzitutto che il diritto all’accesso delle tecnologie e l’inclusione in generale sono un diritto umano fondamentale. E poi che queste tecnologie possono, nel rispetto della privacy e con tutta la cybersicurezza possibile, essere utilizzate in maniera facile ed efficace. Un risultato confortante in questo momento storico e che fa capire quante cose si possano in realtà fare con strumenti quotidiani come uno smartphone, un tablet e un personal computer.