Apple continua a lavorare su tecnologie legate alla guida autonoma: in un nuovo documento di un progetto accademico evidenzia un metodo per individuare oggetti in nuvole di punti 3D (point cloud) sfruttando reti neurali addestrate allo scopo.

Benché si tratti di una tecnologia allo stadio iniziale, scrive AppleInsider, potrebbe maturare al punto da migliorare le soluzioni di navigazione basate sui sensori LiDAR (Laser Imaging Detection and Ranging) per il telerilevamento di oggetti e superfici. Vari sensori presenti nelle auto a guida autonoma si completano a vicenda combinando i dati per assicurare un riconoscimento affidabile dell’ambiente circostante, stabilendo strategie di guida.

Nell’articolo “VoxelNet: End-to-End Learning for Point Cloud Based 3D Object Detection” (qui in PDF) scritto da Yin Zhou (ricercatore specializzato in intelligenza artificiale) e da Oncel Tuzel (specialista in machine learning), Apple evidenzia la possibilità di individuare con precisione oggetti nei point cloud 3D, sulla falsariga degli array LiDAR, un elemento essenziale nel contesto di varie applicazioni pratiche, che vanno dalla guida autonoma, agli aspirapolvere robotizzati, macchinari che si muovono senza l’assistenza di operatori umani e tutti gli altri casi nei quali è fondamentale individuare con velocità e precisione oggetti in un contesto reale.

Rispetto alle tecnologie che fanno affidamento al 2D, il LiDAR si è dimostrato una alternativa più affidabile essendo in grado di rilevare informazioni in profondità con le quali è possibile localizzare meglio gli oggetti nello spazio. Apple spiega ad ogni modo che i point cloud LiDAR generati dalla scansione laser, richiedono tempo per la necessità di emettere impulso ad alta frequenza e dalla successiva lettura dei dati ottenuti dalla rifrazione delle superfici. Tecniche attualmente allo stato dell’arte prevedono l’interpretazione dei dati partendo da point cloud di riferimento creati manualmente, impedendo in alcuni casi di rappresentare in modo dettagliato le informazioni 3D.

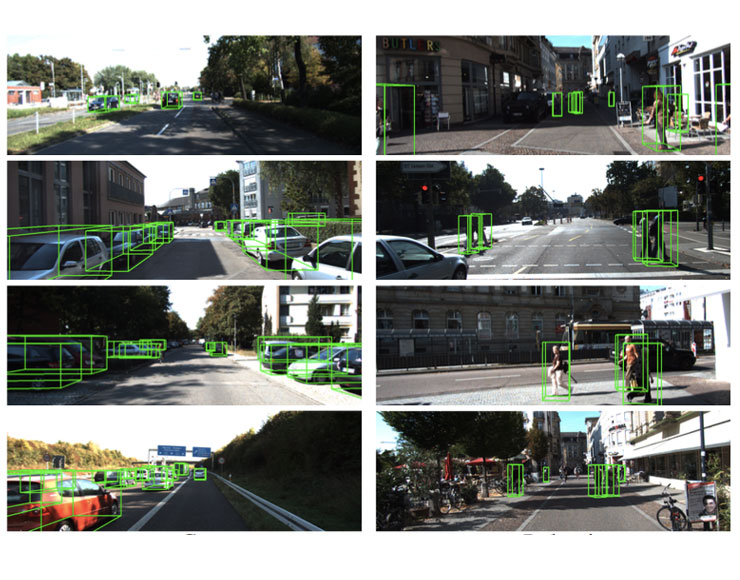

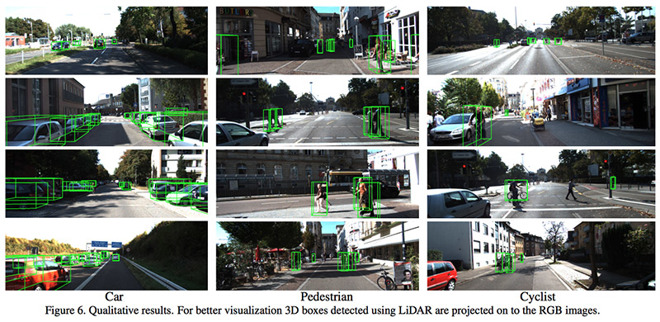

Zhou e Tuzel propongono l’implementazione di una architettura addestrabile per il riconoscimento di point cloud 3D. Il framework, denominato VoxelNet, sfrutta dei layer (voxel feature encoding, VFE) in grado di caratterizzare le forme 3D. La tecnica scompone il point cloud in voxel 3D (il voxel è la controparte tridimensionale del pixel bidimensionale) e li codifica usando layer con i quali è possibile ottenere la rappresentazione volumetrica di quanto osservato.

Secondo i test di Apple la metodologia proposta è “di gran lunga” superiore agli algoritmi di rilevamento usati in abbinamento ai sensori LiDAR, come dimostrato anche usando in abbinamento al Benchmark Suite Kitti Vision, il più grande insieme di dati relativi al traffio veicolare del mondo. Ricerche teoriche a parte, Apple da tempo starebbe sviluppando un suo veicolo a guida autonoma. Le ultime voci del cosiddetto “Project Titan” riferiscono che Cupertino ha ridimensionato il progetto iniziale e per il momento vorrebbe sviluppare un sistema per trasformare vetture normali in auto senza conducente, da usare come navette per i dipendenti tra Palo Alto e Cupertino.

Dopo che Bob Mansfield ha assunto il controllo del progetto “Titan” lo scorso anno, la squadra si è sfaldata, poiché focalizzata su software e soluzioni di supporto. Adesso, invece, Apple starebbe cercando di ricompattare il gruppo, ma con una rinnovata enfasi sulla ricerca di specialisti nei sistemi autonomi, e non sulla produzione automobilistica vera e propria, che sarebbe da esternalizzare a case automobilistiche terze. Negli scorsi mesi Apple ha ottenuto un permesso dal California Department of Motor Vehicles per iniziare la sperimentazione della tecnologia a guida autonoma, usando una piccola flotta di SUV Lexus RX450h, più volte avvistati nei dintorni di Cupertino e nella Silicon Valley.