Heat Initiative, associazione che si presenta come nata per la tutela dei minori, ha avviato una campagna pubblicitaria contro Apple, con l’obiettivo di fare pressione sull’azienda affinché ripristini il sistema che in precedenza aveva deciso di adottare (in seguito abbandonato) e che avrebbe dovuto consentire di verificare l’eventuale presenza di immagini pedopornografiche sugli iPhone, su altri dispositivi prodotti dall’azienda e su iCloud.

Heat Initiative afferma che la campagna predisposta contro Apple è nata per sapere perché l’idea in precedenza annunciata è stata abbandonata, decisione che era stata pensata per individuare con meccanismi automatici la diffusione di materiale che mostra abusi sessuali sui minori (CSAM, da child sexual abuse material in inglese).

Erik Neuenschwande, portavoce di Apple, ha riferito a Wired che il sistema che Cupettino intendeva adottare in precedenza, è stato abbandonato perché “l’analisi dei dati privati di ciascun utente su iCloud creerebbe nuovi vettori di minacce”, evidenziando come indebolimenti nei meccanismi di cifratura comportino “il rischio di scivoloni con conseguenze imprevedibili”.

In risposta alle dichiarazioni di Apple, il gruppo di pressione ha pubblicato una pesante affermazione nella home page del loro sito web di riferimento: “Gli abusi sessuali sui minori sono memorizzati su iCloud. Apple lo permette”.

“Apple ha fatto marcia indietro dopo l’importante annuncio del 2021 per funzionalità che avrebbero permesso di individuare immagini e video di abusi sessuali su minori, impattando sulla vita di minori in tutto il mondo”, riferisce ancora Heat Initiative. E ancora: “Ogni giorno che passa, bambini soffrono a causa di questo immobilismo, ed è per questo che chiediamo a Apple di mantenere il suo impegno”. Sul sito web in questione sono indicati presunti esempi di casi nei quali iCloud sarebbe stato sfruttato per memorizzare materiale che ritrae abusi sessuali, incluse foto, video e messaggi.

Sempre sul sito di Heat Initiative, è riportata una lettera inviata a Tim Cook (il CEO di Apple) nella quale si evidenzia “lo shock e lo sconforto” per la decisione di invertire la rotta sul versante della lotta alla pedofilia.

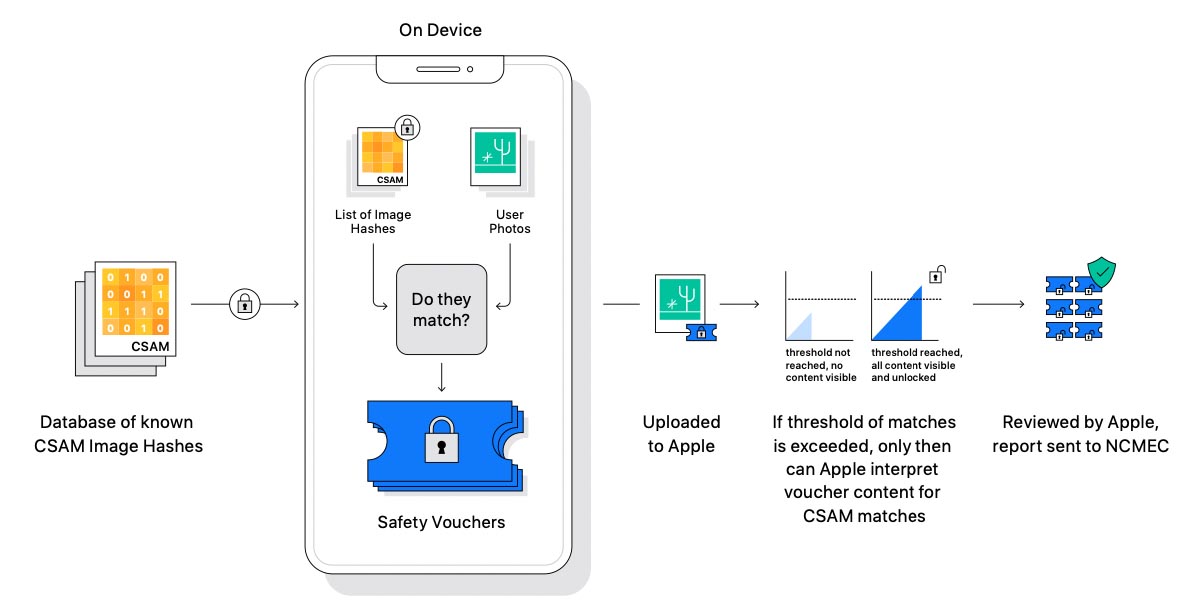

L’idea di Apple, lodata da alcuni e criticata da altri, era quella di adottare una tecnologia denominata NeuralHash, una IA che confronta le immagini con un archivio fornito da organizzazioni per la protezione dei minori come il National Center for Missing & Exploited Children (NCMEC) e altre ancora, cercando corrispondenze. Il confronto è possibile grazie a un doppio processo crittografico che trasforma l’archivio di immagini pedopornografiche note in stringhe di testo (hash). la sequenza di stringhe permetterebbe di analizzare le caratteristiche delle immagini caricate su iCloud.

Le immagini che in qualche modo risultano simili a quelle del database di riferimento, dovrebbero essere caricate insieme ad una etichetta nascosta. Dopo una certa soglia di probabili contenuti pedopornografici, Apple avrbebe dovuto ricevere una segnalazione, facendo scattare un controllo sul materiale da parte di personale incaricato, decifrando e rivedendo manualmente le immagini, alla fine inoltrando eventualmente il tutto al NCMEC per le verifiche.

Il sistema anti-pedofilia di Apple è stato apprezzato da alcune organizzazioni che tutelano i minori (compreso il nostro MOIGE) ma non sono mancate critiche da parte di associazioni che si occupano di privacy, preoccupate da un potenziale diverso uso in futuro di questo sistema: la possibilità che governi e regimi vari obblighino Apple a identificare e segnalare la presenza di simboli e immagini varie nelle foto dell’utente non gradite al regime di turno.

Tra i potenziali pericoli un sistema per individuare in automatico materiale pedopornografico, quelli che in gergo si chiamano “collisioni” (hash identici su immagini che potrebbero far scattare erroneamente allarmi, alterando la bontà̀ del dataset). Gli esperti in sicurezza hanno già evidenziato i pericoli che potrebbero nascere dalle “collisioni” e potenziali problematiche dai falsi positivi.

Ulteriori problemi tecnici sono con il passare del tempo stati segnalati da più parti, sollevando critiche contro il sistema che Apple e quest’ultima alla fine ha deciso di non adottare un sistema che in qualche modo costringe a ridurre privacy e sicurezza per gli utenti.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)