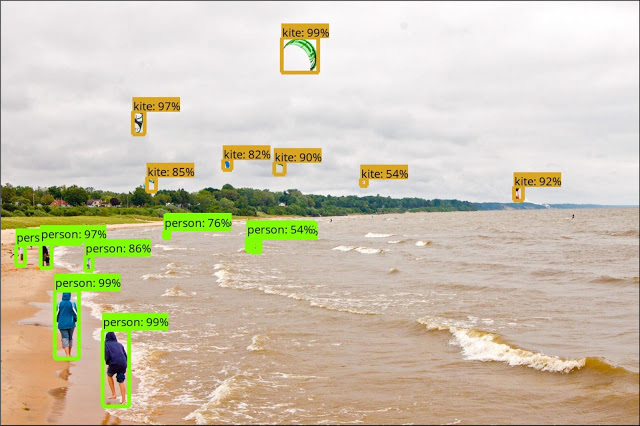

Google ha rilasciato “TensorFlow” una raccolta di API (Application Programming Interface – un insieme di procedure disponibili per i programmatori) che consentono di semplificare il lavoro di identificazioni oggetti nelle immagini da parte di sviluppatori e ricercatori. Il sistema sembra funzionare bene ed è già usato in vari campi di ricerca. Un insieme di modelli prevedono APi per l’individuazione che fanno uso sia di reti neurali convoluzionali (addestrate ad hoc), sia di modelli semplificati (che sfruttano meccanismo di individuazione molto meno complessi) utilizzabili anche su smartphone non molto potenti.

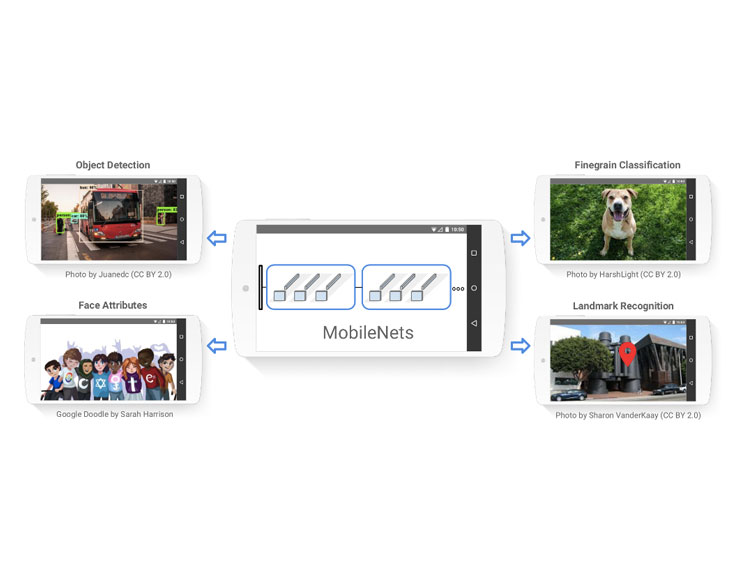

Recentemente Google ha anche annunciato MobileNet, modelli pre-addestrati per il riconoscimento di immagini; già ora molti meccanismi di machine learning sfruttati nelle app per dispositivi mobili funzionano passando i dati a servizi cloud per l’elaborazione e restituendo i risultati via rete; questo rende possibile appoggiarsi a computer molto potenti che si trovano in grandi data center ed abbreviare compiti per i quali bisognerebbe altrimenti rivolgersi al processore dello smartphone o tablet. Questo tipo di approccio crea però problemi dal punto di vista delle latenze e della privacy. La possibilità di elaborare dati direttamente sullo smartphone/tablet dell’utente, consente di ottenere risultati con maggiore velocità, senza bisogno che determinate informazioni escano fuori dal dispositivo. Ottimizzare i modelli di apprendimento affinché possano funzionare su uno smartphone non è ad ogni modo facile: è richiesta enorme potenza di elaborazione con ovvio dispendio in termini di consumo delle batterie.

Google afferma ad ogni modo di essere riuscita a ottimizzare questi meccanismi di machine learning, consentendo agli sviluppatori di usarli senza problemi sugli smartphone. Gli sviluppatori possono sfruttare i modelli in questione su Android, iOS e Raspberry Pi.

Non solo Google ma anche Facebook e Apple sono da tempo impegnate nel settore. Facebook ha tempo addietro annunciato il framework Caffe2Go specifico per gli smartphone. Apple propone CoreML, framework annunciato nel corso dell’ultima Worldwide Developers Conference WWDC17 (ne abbiamo parlato qui).