Quando Tim Cook ha aperto la via alla rivoluzione di Apple Silicon, dei chip progettati in casa da Apple su architettura ARM e prodotti da TSMC a Taiwan, in molti hanno tirato un sospiro di sollievo.

“Era ora”, si sono detti tanti osservatori, perché era un segreto di Pulcinella che Apple stesse lavorando a una rivoluzione dei chip dei suoi Mac. Lo aveva già fatto prima con gli iPhone (e gli iPod, in una certa misura) e poi con Apple TV, gli iPad e qualsiasi altro dispositivo dell’azienda, che aveva a bordo chip particolari per gestire funzioni diverse, incluse quelle di sicurezza dei chip T2, per esempio.

Insomma, era ovvio che si dovesse arrivare a un Mac con chip Apple Silicon. L’unica cosa che non si sapeva è come si sarebbe chiamato e quanto sarebbe stato diverso dai chip usati sugli iPhone e soprattutto sugli iPad. Anzi, dai SoC, perché una parte della rivoluzione introdotta da Apple nella gestione del silicio per i suoi dispositivi è stato puntare tutto su una formula all’opposto di quella scelta da Intel e AMD, cioè sull’integrazione di componenti diverse all’interno di uno stesso chip che ha più “strati”.

![]()

I perché di una scelta tecnologica

Questa scelta dei SoC, System on a Chip, dettata da bisogni di efficienza energetica e di spazio, visto che i telefonini sono molto più piccoli dei computer, ma anche dal fatto che Apple integra componenti sue che non deve rivendere in un mercato di produttori di schede madri e di computer i quali, a loro volta, devono costruire computer parzialmente diversi.

I processori Intel vengono venduti ai produttori di schede madri e ai produttori di personal computer che hanno bisogno, con lo stesso processore e lo stesso sistema operativo (Windows) di creare computer diversi e auspicabilmente interessanti per i loro clienti.

Questo non avviene solo con una scelta estetica di “carrozzeria”, ma sotto la scocca ci sono scelte architetturali che differenziano ad esempio un portatile Lenovo da uno HP da uno Asus, anche se tutti e tre utilizzano per ipotesi la stessa CPU di Intel.

Differenti tipi di memoria, di componenti, di acceleratore grafico. Apple cerca esattamente l’opposto di questa differenziazione perché i suoi chip vanno solo all’interno dei suoi prodotti e quindi si muove con una strategia opposta a quella di Intel e AMD, con risultati che sono, a parità di condizioni, vincenti.

Dicevamo però che l’arrivo dei chip Apple Silicon con la prima, memorabile generazione di SoC dal nome “M1” (“Mac 1”? Probabilmente sì) è andata al di là di tutte le aspettative. Questo sia per la bontà intrinseca del prodotto, che a oggi è ancora più rivoluzionario della versione M2 che lo ha seguito (più una evoluzione e affinamento che non una seconda rivoluzione). Ma sia anche perché Intel e i suoi chip erano in profonda crisi, e il Mac ne pagava duramente le conseguenze.

L’effetto stufetta

Intel è entrata in una crisi crescente, negli ultimi dieci anni, sia dal punto di vista della ricerca e innovazione che dal punto di vista industriale e manageriale, tanto che è stato licenziato il precedente amministratore delegato ed è stato chiamato alla guida Pat Gelsinger, uno dei manager più esperti nel mondo della produzione dei chip che ha iniziato proprio in Intel e che dei semiconduttori sa tutto.

Gelsinger è l’uomo che ha capacità di gestione e capacità di visione innovativa. Ma nonostante questo sta facendo molta fatica a cambiare le sorti di una azienda che sembra essere vittima soprattutto della sua eredità tecnologica. Cioè delle scelte di fondo che le rendono difficile essere competitiva oggi: un po’ come i produttori tradizionali di auto con motore termico che non riescono a produrre auto progettate da zero per essere elettriche e si trovano in crescenti difficoltà nel mercato destinato entro dieci anni all’elettrificazione totale.

Gelsinger ha il problema di una azienda che ha fatto delle scelte importanti dal punto di vista architetturale, produttivo e di business model nel mercato le quali oggi non pagano più come un tempo. Ma anche una azienda vittima in parte della sua più famosa predizione, la legge di Moore, che le è servita, assieme a una stretta alleanza con Microsoft, a creare un circolo virtuoso (per le due aziende) di crescita apparentemente senza limiti. Solo che i limiti c’erano ed erano fortissimi.

La dura legge di Wintel

Durante i due decenni dominati dall’economia “Wintel”, crasi di Windows e Intel, le due aziende si sono date il passo sfruttando la legge di Moore: un anno arrivava una nuova generazione di chip potenti il doppio rispetto a quella precedente, l’anno dopo una nuova versione di Windows che richiedeva ancora più potenza per funzionare. In questo modo, come ha stabilito anche l’antitrust americano, l’effetto era di spingere i clienti a cambiare PC praticamente ogni 24 mesi (a guardare bene, quasi una forma di obsolescenza programmata) e a mettere la concorrenza in un angolo (soprattutto AMD).

Questa Intel stava già vedendo la fine della Legge di Moore e aveva trovato una strategia interessante per rallentarla o superarla: la creazione delle architetture multi-core, con più nuclei di calcolo. Questo perché il funzionamento della parte interna di un processore non è sempre al 100% ma certi gruppi di microscopici transistor vengono usati più spesso di altri.

L’idea era che, dopo aver risolto uno dei problemi dell’ingegneria del software, cioè il Parallel computing (il parallelismo, disciplina che si è sviluppata soprattutto per i cluster di server) e quindi la programmazione per questo tipo di funzionalità, i computer con processori con più nuclei di calcolo interni fossero più efficienti di quelli con un nucleo solo e una frequenza di clock estremamente alta.

![]()

A cosa serve il calcolo parallelo

Il parallelismo dunque prima è stato a lungo utilizzato nell’elaborazione ad alte prestazioni, ma poi ha acquisito interesse più ampio a causa dei vincoli fisici che impediscono la scalabilità della frequenza di clock delle CPU tradizionali con un solo nucleo di calcolo. Poiché negli ultimi anni il consumo di energia (e di conseguenza la generazione di calore) dei computer è diventato un problema, il calcolo parallelo è diventato il paradigma dominante nell’architettura dei computer, soprattutto sotto forma di processori multi-core.

La mossa di Intel

Con questa strategia, che la Intel di Paul Otellini aveva battezzato “Core” e poi “Core 2” all’inizio degli anni Duemila, aveva convinto Steve Jobs che questa potesse essere la strada giusta per la Apple del passato, quella che ancora usava processori PowerPC. E che era in seria difficoltà.

La storia di Apple e dei PowerPC

Facciamo un passo indietro. nel 1997 Apple era sull’orlo della bancarotta: i Macintosh non vendono, ci sono un sacco di progetti che non funzionano, i “cloni” (computer di terze parti che usano Mac OS) cannibalizzano le vendite, i clienti scappano, Windows ha vinto su tutti i fronti.

Nel pieno del disastro, però, tutto cambia. Torna Steve Jobs, che era stato cacciato nel 1985 dalla sua stessa azienda. Il quale porta con sé l’eredità di un sistema operativo, NeXT, che è il papà dell’attuale macOS. Basato sulla distribuzione BSD di Unix, NeXT è molto potente e può funzionare sia sui processori PowerPC prodotti da Motorola e IBM (con la collaborazione di Apple) che su quelli Intel con architettura x86. Steve Jobs prima porta avanti la transizione dal vecchio Mac OS giunto alla versione 9 al nuovo Mac OS X (dove la X sta per “decimo”) oggi chiamato macOS. Ma intanto prepara anche un’altra rivoluzione.

Il dilemma di Steve Jobs

Dopo aver rimesso in pista Apple con computer di valore (iMac, PowerMac, PowerBook, iBook), Steve Jobs si trova di fronte al problema di un consorzio di produttori di chip che non lo supporta più come dovrebbe. Motorola non riesce ad andare oltre la generazione di processori G4, mentre Intel in ritardissimo offre il suo G5 che è potente ma ha problemi di consumi e calore, tanto che verrà usato solo sui computer fissi e mai su quelli portatili.

IBM, che all’epoca produceva nella sua fabbrica i microchip ed era a tutti gli effetti un concorrente della corazzata Intel, aveva una seconda linea sulla quale stava investendo con i processori Risc simili ai PowerPc G5, e cioè quello dei processori per Playstation. Molto più semplici, meno potenti e inadatti all’uso su un Mac, i processori Cell erano dei PowerPC che però avevano un vantaggio: sarebbero stati comprati in decine se non centinaia di milioni di esemplari, mentre di G5 se ne vendevano forse uno o due milioni.

IBM “tradì” Apple per investire altrove (e continuare a produrre i suoi processori server IBM Power) e così sancì la fine dell’amore nella famiglia allargata Apple-IBM-Motorola (quest’ultima che stava fallendo e sarebbe poi stata comprata dalla cinese Lenovo). Il figlio del trio, cioè il PowerPC o Performance Optimization With Enhanced RISC (anche Performance Computing), era finito.

La prima cosa capita da Steve Jobs

Jobs aveva capito due cose: la prima era che se Apple voleva vincere sul lungo periodo doveva dotarsi di un suo chip che fosse profondamente personalizzato e capace di integrarsi con il suo sistema operativo e il resto dell’hardware. Per questo la scelta di progettare chip era ritornata alla ribalta e Jobs aveva anche capito che poteva sfruttare un altro vecchio progetto di Apple: la partecipazione a un altro consorzio ancora più vecchio chiamato ARM, le cui iniziali al principio stavano per Acorn RISC Machine.

ARM è nata di fatto nel 1983 per progettare i chip per i computer Archimedes di Acorn. Nel 1990 ARM è stata incorporata, cioè è divenuta una azienda vera e propria e non solo una filiale di Acorn, cambiando il significato della sigla in “Advanced RISC Machines” perché era una joint venture tra Acorn e Apple. Il processore Arm interessava anche alla Apple guidata da John Sculley perché sarebbe stato il cuore del Newton, il primo PDA creato da Apple e “ucciso” da Steve Jobs al momento del suo ritorno.

A parte la storia aziendale dei prodotti di Apple, Jobs si era ritrovato questo pezzo di tecnologia dei chip in casa e, forte del fatto che Apple non pagava un centesimo per i diritti d’uso dell’architettura ARM, capì che in futuro quella sarebbe stata la strada giusta. Solo che ci sarebbe arrivato per gradi, e quindi la sfruttò per creare i primi processori degli iPhone e poi degli iPad, oltre che delle Apple TV e di alcune generazioni di iPod.

La seconda cosa capita da Steve Jobs

L’altra cosa che però era chiara era che ARM non era pronta a fornire processori per i Mac e che Apple non era in grado di progettarli, almeno non nel breve periodo. L’unica cosa fattibile sarebbe stata quella di scegliere una soluzione intermedia. E questa soluzione, grazie alle scelte tecnologiche della Intel guidata in quel momento da Paul Otellini, sarebbe stata quella dei nuovi processori Intel Core, cioè multicore. Unix, NeXT e Mac OS X (così come Linux) avevano già forti capacità di parallelizzazione del calcolo a 64 bit e compatibilità con architetture multi-core (il cui sfruttamento fu invece un grosso problema per Windows, almeno all’inizio) e quindi Intel era la scelta giusta.

La roadmap di prodotti Intel Core 2 presentata segretamente da Otellini a Jobs agli inizi del Duemila era evidentemente molto convincente: finalmente processori a basso consumo e capaci di avere ottime prestazioni. Iniziò così la seconda migrazione dell’era Jobs: da PowerPC a Intel. Era l’estate del 2005 e finì nel 2006, abbandonando di fatto l’architettura gestita da IBM con una piccola collaborazione di Freescale (il nome della divisione di Motorola che produceva i chip, messa in vendita dall’azienda americana per fare cassa).

La bontà di Intel

Quello del passaggio a Intel fu un momento tosto: la comunità di utenti Apple da decenni era “contro Intel” perché era il processore del “nemico”, il PC che usava Windows. Però Steve Jobs la vendette bene, a partire dal keynote agli sviluppatori di Apple durante la WWDC del 2005 in cui alla fine, dopo aver annunciato i nuovi processori e aver ospitato Otellini sul palco, disse che tutto il keynote che avevano visto (slide, video, etc) era stato fatto con un Mac con Intel. Classico Steve Jobs, colpo di scena perfettamente coreografato e applausi a scena aperta.

Quel che successe negli anni a seguire, sino all’arrivo di M1, è una stranissima traiettoria. Perché i processori Intel fecero tantissimo. Portarono i computer di Apple a livelli di performance davvero notevoli con i processori Xeon e Intel Core 2 i9, e sino alle ultime 1-2 generazioni dettero veramente il meglio. I Mac facevano di più, i portatili per la prima volta duravano fino a 8-9 ore. Una rivoluzione.

Certo, poi Intel inciampò nei limiti della sua stessa strategia. La trappola fu la legge di Moore che non funzionava più e la strategia delle architetture Multi-Core non veniva portata al suo prossimo logico passaggio, cioè l’integrazione con le altre componenti come avviene nei SoC, per questioni di “visione strategica” ma anche di modello di business, come dicevamo prima.

Il finale è stato che l’ultimo MacBook Pro 16 Core 2 i9 era una macchina ancora straordinaria ma con una batteria abbastanza limitata e che scaldava moltissimo, mentre il MacBook con schermo da 12 pollici, con processore Intel i3, era troppo sottopotenziata e non riusciva a performare, con una batteria che durava paradossalmente poco perché il processore andava sempre al massimo per cercare di lavorare bene (e veniva “castrato” dal limitatore intero vista la scarsa dissipazione del calore).

C’eravamo tanto amati

Insomma, dopo aver esordito con dei processori Motorola nei primi Macintosh dal 1984, dopo un matrimonio poliamoroso a tre con IBM e Motorola durato a lungo e con tanti figli ma finito male, il matrimonio con Intel è stato relativamente lungo (un decennio) ma molto fruttuoso.

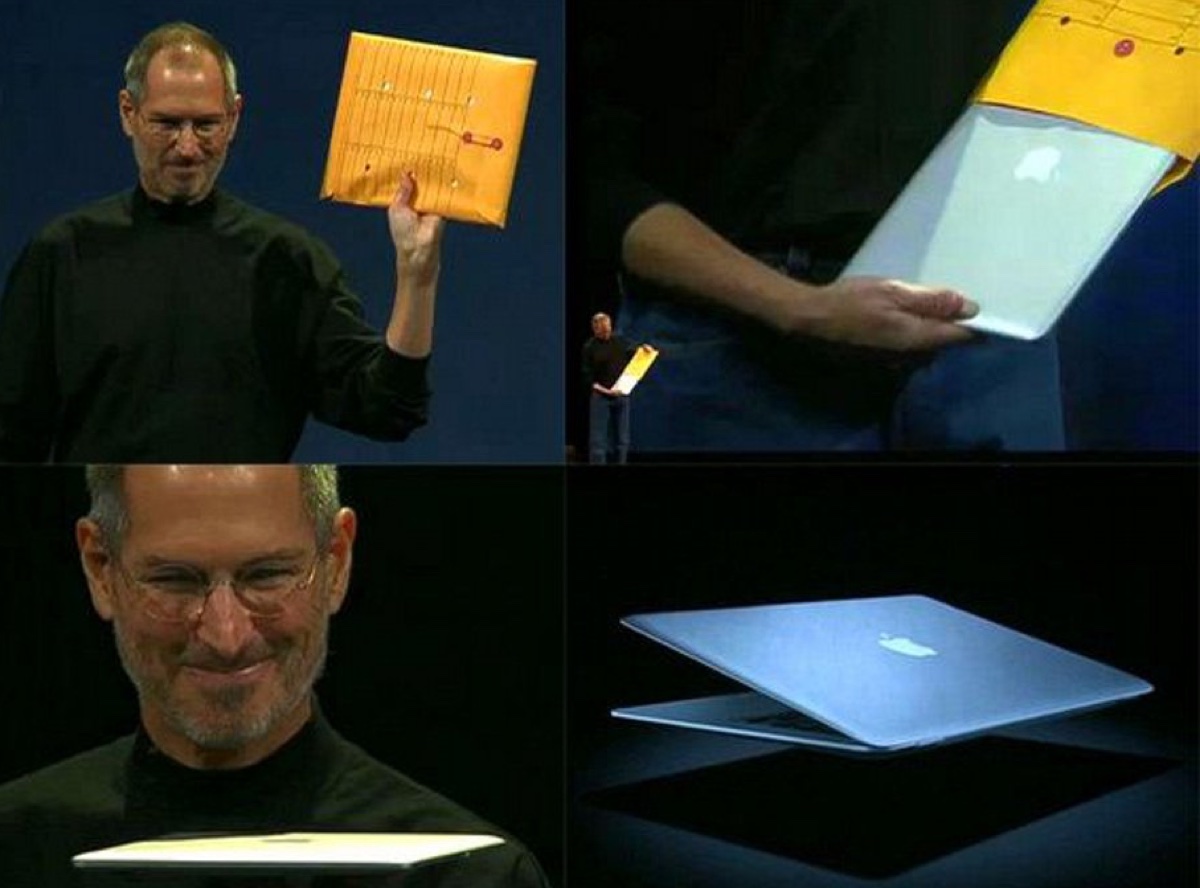

Il Mac è diventato una piattaforma di nuovi rilevante anche grazie a questo processore che ha reso per esempio molto semplice passare componenti e librerie dal mondo Windows e Linux a quello Mac OS X e viceversa. Sono stati inventati gli ultrabook con il primo MacBook Air: il computer che stava in una busta da ufficio e la cui scheda logica venne mostrata accanto a un lapis, e la cui batteria durava 12, 14 fino a 16 ore.

Tutto questo è stato possibile grazie a Intel oltre che agli ingegneri di Apple. Tantissime cose fatte con i processori Intel sono state ottime, sino a quando la capacità di dare più potenza e meno consumi si è fermata. O troppo calore o troppa poca potenza.

Ed è arrivato il momento di passare ad altro, cosa che è successa con Apple Silicon ed M1. La scelta di Apple di “fare da sola”, che oggi sposa la capacità tecnologica di ARM e la manifattura di TSMC ma che tra un decennio potrebbe riservare sorprese anche su questo fronte (Risc V?).

Di sicuro, come in tutte le separazioni, ci sono un po’ di sentimenti accesi, se non altro per essere liberi di aprirsi e accogliere la nuova vita. Ma bisogna anche ammettere che stare con Intel è stato a lungo molto bello e cose buone sono state fatte insieme. Non dimentichiamolo.