Facebook ha annunciato migliorie alla sua tecnologia di intelligenza artificiale usata per generare descrizioni alle foto pubblicate sui social network, indicazioni utili per gli utenti non vedenti o ipovedenti.

La tecnologia denominata Automatic Alternative Text (AAT) è stata presentata nel 2016 con l’obiettivo di migliorare l’esperienza d’uso degli utenti con problemi visivi; fino a quel momento, gli utenti con problemi di vista che controllavano il newsfeed su Facebook e si imbattevano in una immagine sentivano solo la parola “foto” e il nome delle persone che l’aveva condivisa. Con la tecnologia AAT gli utenti non vedenti o ipovedenti hanno la possibilità di sentire frasi del tipo: “Immagine con tre persone, sorrisi, all’aperto”.

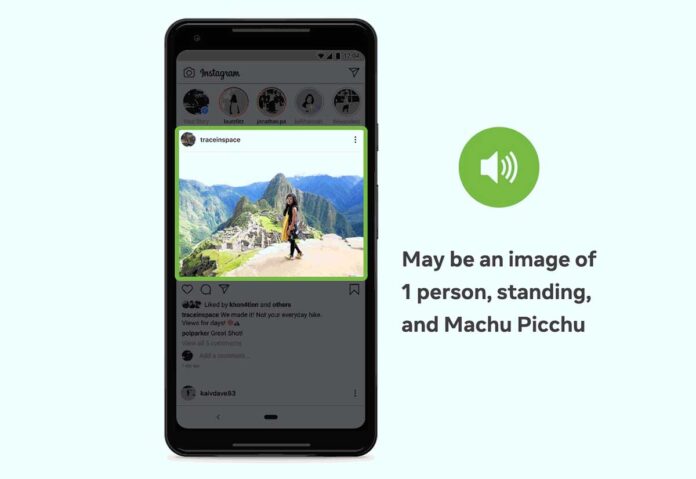

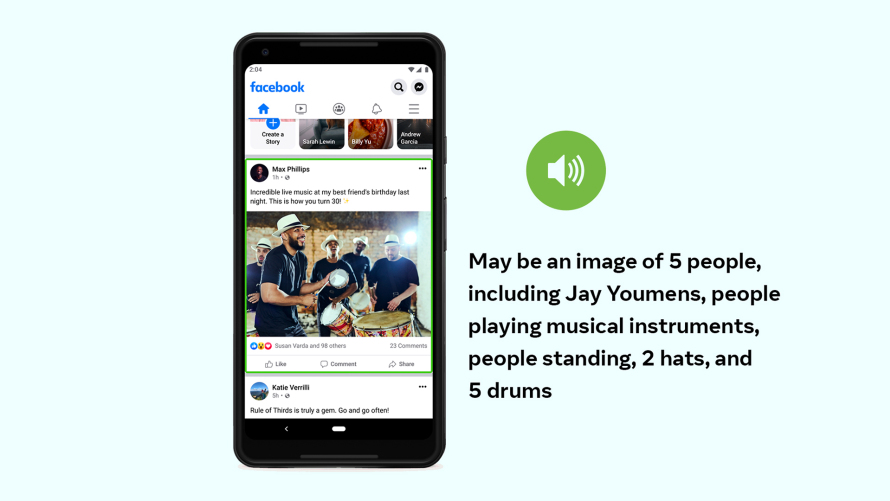

Facebook riferisce che con l’ultima versione di AAT aumentano i concetti che questa è in grado di descrivere, offrendo indicazioni ancora più dettagliate di attività, luoghi-simbolo, tipologie di cibo e tipi di animali, offrendo ad esempio con una descrizione del tipo: “Un selfie con due persone, all’esterno, la Torre di Pisa”, anziché la generica descrizione “immagine con due persone”.

Secondo l’azienda, i concetti che la tecnologia ora è in grado di riconoscere sono migliaia, rispetto al centinaio di prima, possibilità ottenute addestrando il modello settimanalmente usando campioni che a loro dire sono “più accurati, oltre che culturalmente e demograficamente inclusivi”.

Funzionalità simili a quelle offerte da Facebook sono state studiate anche da altre aziende per migliorare l’esperienza d’uso di utenti ipovedenti o non vedenti. Lo scorso anno, ad esempio, Google ha presentato la tastiera braille virtuale TalkBack per consentire agli utenti ipovedenti di Android di scrivere senza bisogno di utilizzare una periferica fisica esterna. Big G ha in precedenza presentato Lookout, un’app Android (disponibile anche in italiano) dedicata alle persone con disabilità visive che, puntando lo smartphone in ogni direzione, consente di ottenere una descrizione vocale dell’ambiente e degli oggetti visualizzati, possibile grazie a modelli di intelligenza artificiale. Amazon ha predisposto una funzionalità del genere con la funzione “Show and Tell” per l’Echo Show in grado di riconoscere oggetti nella dispensa di casa. È possibile tenere in mano un oggetto, avvicinarlo al display di Echo Show e chiedere: “Alexa, che cosa ho in mano?”. Lo sviluppo di Show and Tell è stato portato avanti con il contributo di alcuni dipendenti Amazon che soffrono di problemi visivi e con il Vista Center for the Blind di Santa Cruz che ha raccolto i feedback che hanno consentito di perfezionare la tecnologia.

Tutti i nostri articoli che parlano di Facebook sono disponibili da questo indirizzo; tutti gli articoli che parlano di Intelligenza Artificiale da questo indirizzo.