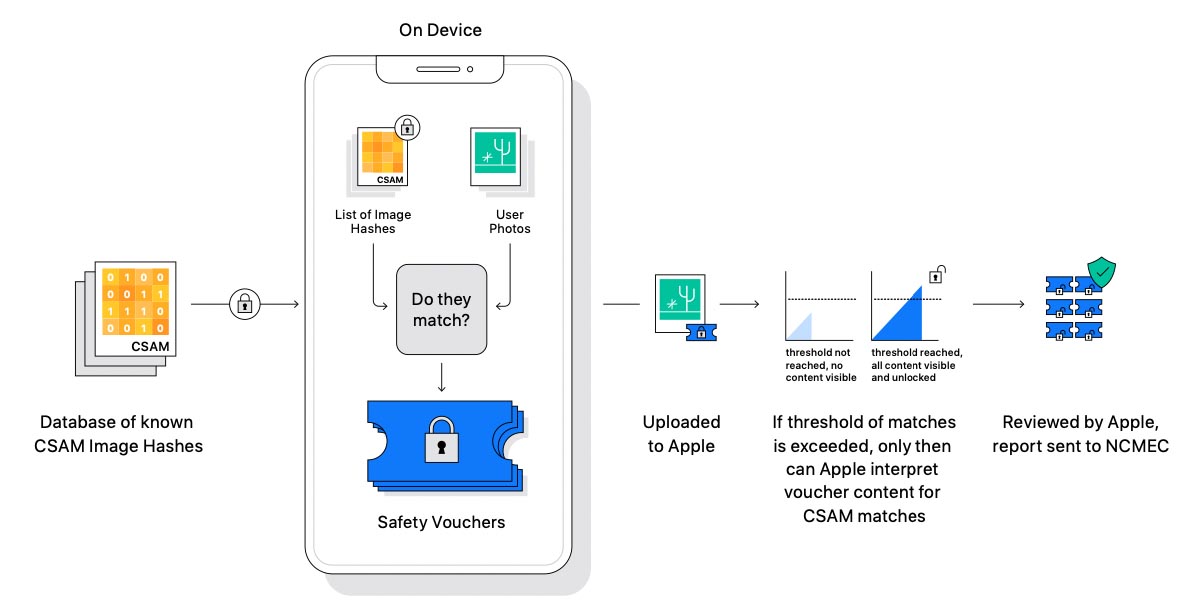

Alcuni dipendenti Apple avrebbero espresso dubbi sulle nuove funzionalità che in iOS 15, iPadOS 15 e macOS Monterey permetteranno di effettuare verifiche sulle foto caricate su iCloud e su quelle scambiate con iMessage per cercare materiale pedopornografico, una scelta controversa – lodata da associazioni quali il Centro Nazionale per Bambini Scomparsi e Sfruttati e anche il nostro MOIGE (MOvimento Italiano GEnitori) – ma fonte di preoccupazione per associazioni come l’Electronic Frontier Foundation (EFF) che vedono il sistema di scansione come una clamorosa invasione della privacy, chiedendosi cosa accadrebbe se un domani Apple modificasse il sistema per identificare non solo materiale pedopornografico, ma ad esempio anche simboli e immagini poco gradite a governi e regimi vari.

Da quando il meccanismo di identificazione automatica di determinate tipologie di immagini pensato per la protezione dei bambini è stato annunciato – riferisce Reuters – alcuni dipendenti Apple hanno pubblicato sul canale interno di Slack centinaia di messaggi sull’argomento, una questione che è rimasta al centro dell’attenzione per giorni. Le obiezioni maggiori arriverebbero ad ogni modo da dipendenti Apple che non fanno parte dei team che si occupano di sicurezza e privacy; questi ultimi non sembrano preoccupati e anzi ritengono i nuovi strumenti di controllo una risposta ragionevole per contribuire a impedire il diffondersi di pedopornografia.

In un thread del gruppo Apple su Slack nel quale si parla della funzionalità di “scansione” (lo strumento che cerca corrispondenze tra foto e immagini note presenti in un database di riferimento) alcuni dipendenti di Apple hanno fatto presenti le critiche ricevute, mentre altri hanno fatto notare che Slack non è il forum adatto per questo tipo di discussioni.

Apple si trova a dover affrontare non solo critiche ma anche disinformazione e fake news sulla questione; non mancano ad ogni modo i dubbi legittimi di chi vede un potenziale pericolo nel futuro di questi strumenti, preoccupati che sistemi simili possano essere usati per altri scopi.

La Mela ha cercato di rispondere alle critiche predisponendo una prima FAQ per spiegare la sua visione, evidenziando che si tratta di una soluzione ad un serio problema che tiene conto della privacy, spiegando di non avere accesso in alcun modo alle immagini che non risultano simili a quelle del database pedopornografico di riferimento e di non poter accedere ai metadati delle immagini segnalate finché non viene raggiunta la soglia che fa scattare le segnalazioni. Il meccanismo di verifica delle immagini caricate sul cloud rimane certamente controverso e Apple dovrà fare capire bene che la funzione per trovare le immagini pornografiche non crea una backdoor, non viola la crittografia end-to-end, non è stato creato per consentire ai Governi di monitorare i cittadini e funziona solo se l’utente ha attivato la funzione che consente di caricare le Foto su iCloud.

Tutti gli articoli di macitynet che parlano di Privacy e Sicurezza sono disponibili ai rispettivi collegamenti.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)