In una occasione più unica che rara, Apple ammette di aver gestito male l’annuncio del sistema antipedofilia, contribuendo alla confusione creatasi al riguardo: lo riconosce apertamente Craig Federighi intevistato dal Wall Street Jorunal, offrendo nuovi dettagli sul funzionamento che rassicurano gli utenti per quanto riguarda privacy e riservatezza dei dati.

«Col senno di poi, introdurre queste due caratteristiche contemporaneamente è stata una ricetta per questo tipo di confusione. Rilasciandoli allo stesso tempo, le persone li collegavano tecnicamente e si spaventavano molto: cosa sta succedendo ai miei messaggi? La risposta è… non sta succedendo nulla con i tuoi messaggi».

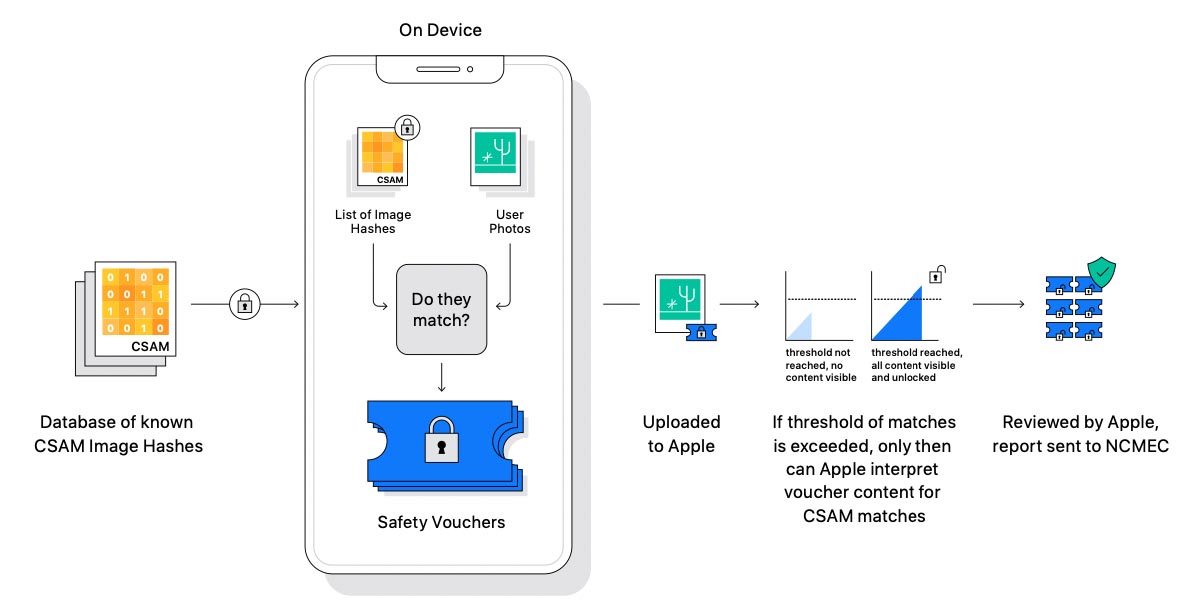

Il top manager di Cupertino precisa che il sistema antipedofilia di Apple non può essere sfruttato da governi e forze di polizia grazie a più livelli di verificabilità. Come spiega il documento pubblico FAQ, il sistema non fa un match fra le immagini presenti sul telefono e non riconosce contenuti di natura pedopornografica. Ciò che avviene è la generazione di codici univoci per le immagini, chiamati “perceptual hash”, che vengono confrontati con una lista di codici forniti dal NCMEC e relativi a contenuti pedopornografici già noti (il cui possesso negli USA è illegale).

Uno degli strumenti, annunciato la scorsa settimana per il rilascio entro la fine dell’anno, suona effettivamente un allarme quando qualcuno carica materiale pedopornografico noto sul servizio di archiviazione cloud dell’azienda, noto come iCloud. A differenza di altri provider cloud, Apple non esegue la scansione di tutto nell’account online di un utente. Invece, Apple ha escogitato un mezzo per identificare le immagini su iPhone che corrispondono a un database di immagini illegali note.

Se una persona non carica mai immagini su iCloud, Apple non viene avvisata. Se un numero sufficiente di immagini offensive viene caricato su iCloud, il sistema avvisa Apple e l’azienda quindi controlla quelle immagini specifiche per confermare che sono in violazione prima di segnalarle al National Center for Missing and Exploited Children, che funge da punto di smistamento per le segnalazioni di abusi sui minori».

«Se e solo se raggiungi una soglia di qualcosa nell’ordine di 30 corrispondenti immagini pedopornografiche conosciute, solo allora Apple saprà qualcosa sul tuo account e sa qualcosa su quelle immagini e, a quel punto, sa solo su quelle immagini, non su una qualsiasi delle tue altre immagini. Questo non è fare delle analisi perché avevi una foto di tuo figlio nella vasca da bagno? O, se è per questo, avevi una foto di qualche altro tipo di pornografia? Questo corrisponde letteralmente solo alle impronte digitali esatte di specifiche immagini pedopornografiche conosciute».

Il dirigente Apple spiega anche il vantaggio in termini di sicurezza e privacy di effettuare la ricerca direttamente su iPhone. «Poiché è su [iPhone], i ricercatori di sicurezza sono costantemente in grado di analizzare ciò che sta accadendo nel software [del telefono] di Apple. Quindi, se sono state apportate modifiche per espandere l’ambito di questo in qualche maniera, in un modo che ci eravamo impegnati a non fare, c’è verificabilità, possono individuare ciò che sta accadendo».

Infine alla domanda se il database delle immagini usate per la ricerca può essere compromesso, magari inserendo materiali politici, Federighi ha dichiarato che l’archivio del sistema antipedofilia è costruito con l’inserzione di immagini da più organizzazioni per la sicurezza dei minori, di cui almeno due in diverse giurisdizioni. Sia le organizzazioni che revisori indipendenti potranno verificare che il database contiene solo immagini di questo tipo.

Tutti gli articoli di macitynet che parlano di Privacy e Sicurezza sono disponibili ai rispettivi collegamenti.