Si sente spesso parlare di TV con HDR, nuova tecnologia spesso associata ai televisori di fascia alta con risoluzione 4K. Sebbene possa sembrare una sigla come tante altre, pubblicizzata in pompa magna dai produttori solo per raggiungere l’utenza, non è così: ecco perché l’HDR è il presente e il futuro delle TV (e pure di iPhone e degli altri smartphone top di gamma)

- 1 Cos’è e a cosa serve HDR nei TV?

- 1.1 La sigla

- 1.2 Cosa rende una TV HDR?

- 1.3 Come faccio a sapere se una TV è HDR?

- 1.4 HDR Vs HDR10+

- 1.5 OLED Vs LCD: qual è migliore per l’HDR?

- 1.6 Quali contenuti TV sono disponibili in HDR?

- 1.7 Conviene acquistare una TV HDR?

- 1.8 Dolby Vision vs HDR10

- 1.9 Quali TV Dolby Vision e quali HDR10?

- 1.10 Apple TV con HDR

Cos’è e a cosa serve HDR nei TV?

La sigla

E’ bene anzitutto chiarire il concetto: cosa significa, e cosa fa, l’HDR? La sigla sta per High Dynamic Range, che in italiano è possibile tradurre con Ampia Gamma Dinamica. In termini spiccioli, significa fondamentalmente migliore contrasto, maggiori livelli di luminosità e una gamma di colori più ampia. Questo si traduce, in termini pratici, in film e spettacoli televisivi più simile alla vita reale o almeno rispetto alla rappresentazione dell’autore delle riprese. Questo perché l’occhio umano, grazie all’HDR, riuscirà a percepire bianchi più luminosi e neri più scuri – appunto, maggiore dinamicità – cosa che non accade con le TV tradizionali.

Ancor più nel dettaglio: migliori bianchi e neri, vuol dire che l’HDR riesce a conservare, e quindi mostrare all’utente, maggiori dettagli nelle aree più buie e in quelle più luminose della scena, rispetto a quanto avviene con lo standard Rec.709. L’HDR, inoltre, offre colori più naturali e vivi, più vicini a come l’occhio umano li percepisce nella vita reale.

L’HDR10 è la forma standard di HDR, già disponibile da tempo sulle TV, in diretta competizione con la tecnologia Dolby Vision. Si è già fatto un passo in avanti, però, con Samsung che ha proposto un proprio standard, noto come HDR10+, che sarà a breve supportato da Amazon Video, giusto per citare uno dei fornitori di contenuti in streaming che grazie alla possibilità di saltare i formati “fisici” sono tra i primi a potervi far provare le nuove tecnologie.

Cosa rende una TV HDR?

Sono due gli elementi chiavi che definiscono una TV HDR: prestazioni nel contrasto el numero di colori che possono essere visualizzati a schermo. Quanto al Contrasto, è uno dei fattori più importanti nella resa qualitativa definitiva, e in sostanza si riferisce alla differenza tra luce e buio. Maggiore è la differenza, maggiore è il contrasto. Per aspirare a ottenere il bollino “HDR” una TV deve riuscire a raggiungere alcuni parametri di luminosità massima, così come picchi li nero: entrambe gli elementi, luce e buio, si misurano in nits. Ed allora, per esempio, una TV potrebbe avere una luminosità di picco di 400 nits e un livello nero di 0,4 nits: la differenza tra la luminosità di picco livello nero è conosciuto come il rapporto di contrasto.

La UHD Alliance ha stabilito due diversi standard per etichettare una TV con HDR: il primo prevede più di 1.000 nits luminosità di picco e meno di 0.05 nits per il livello di nero. Lo standard 2 prevede, invece, più di 540 nits di luminosità e meno di 0.0005 nits per il livello nero. Questa distinzione, come vedremo più avanti, permette anche a TV OLED, che non raggiungono picchi di luminosità paragonabili alle TV LCD ma hanno neri assoluti, di ottenere tale certificazione.

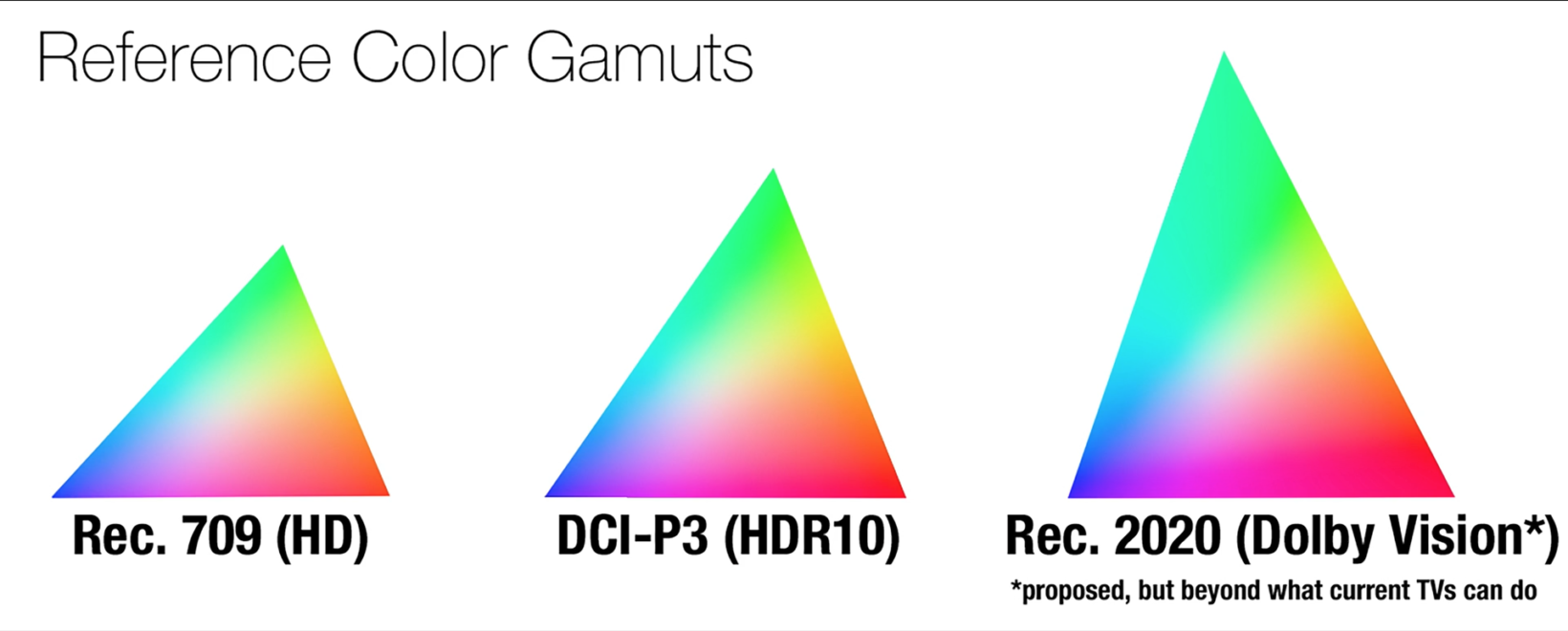

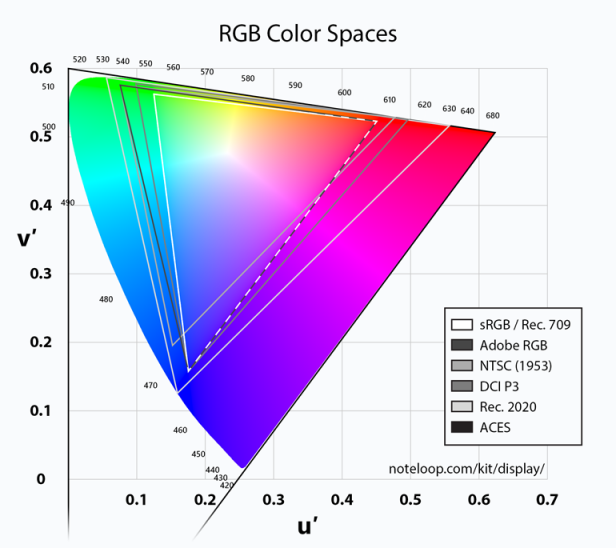

Il secondo elemento più importante che rende HDR una TV è il Colore. Quando si tratta di colore, una TV deve essere in grado di elaborare quello che è conosciuto come colore a 10 bit o “profondità”. Il colore a 10 bit equivale a un segnale che include oltre un miliardo di colori singoli. In confronto, il Blu-ray standard utilizza un colore a 8 bit, che ammonta a circa 16 milioni di colori diversi. Con il colore a 10 bit, i televisori HDR sono in grado di produrre una vasta gamma di tonalità di colore, riducendo gradualmente le sfumature evidenti tra le diverse tonalità. Una ombreggiatura quanto più sottile possibile aiuta a rendere una scena molto più realistica.

Per essere considerato “HDR”, un televisore non deve essere in grado di visualizzare tutti i colori in un segnale a 10 bit. Deve solo essere in grado di elaborare il segnale e di produrre un’immagine basata su queste informazioni. Inoltre, un televisore HDR deve essere in grado di produrre una certa quantità di ciò che è conosciuto come il colore “P3”. Il colore P3 si riferisce all’intervallo dello spettro di colore incluso. Il modo migliore per pensare a questo è immaginare uno spettro di colore complessivo, e all’interno di esso un insieme di spazi definiti. Lo spazio di colore P3 è più grande di quello utilizzato nelle TV standard che impiegano Rec. 709. In termini spiccioli, HDR significa che la TV può coprire un più ampio spazio all’interno dello spettro di colore, e all’interno di questo stesso spazio, avere gradazioni delle sfumature molto più dolci rispetto alle TV standard.

Come faccio a sapere se una TV è HDR?

Il modo più semplice è cercare il logo Ultra HD Premium. Si tratta di un timbro di approvazione da parte del consorzio UHD Alliance, un gruppo costituito da aziende tecnologiche e produttori di contenuti. L’idea è di eliminare possibile confusione, in maniera tale che l’utente, anche non troppo esperto, possa comunque distinguere una TV HDR, da una standard.

Ovviamente, non tutti i televisori “HDR” hanno la certificazione UHD Premium. In questi casi, acquistando la TV HDR senza il bollino, si otterranno dei vantaggi tipici dell’HDR, ma senza ottenere la migliore esperienza possibile. Il sistema UHD Premium non è perfetto, ma in genere è più sicuro acquistare un televisore UHD Premium.

HDR Vs HDR10+

Come poco sopra accennato, oltre all’HDR10, lo standard della tecnologia HDR, c’è già chi, come Samsung, ha lanciato il proprio standard HDR10+. Si tratta di uno standard aperto, creato da Samsung e disponibile su tutte le TV 2017 della società, che sarà implementato tramite aggiornamento firmware anche nei modelli 2016. Il “Plus” di questa tecnologia è che tende a migliorare l’HDR, utilizzando metadati dinamici invece che metadati statici utilizzati dall’HDR10. Ciò significa che tale standard può alterare dinamicamente la luminosità delle singole scene, e persino di singoli fotogrammi, durante la visione di uno show televisivo o di film. Ad esempio, se una scena doveva essere visualizzata a bassa luminosità, l’approccio dinamico di HDR10 + diminuirà in tempo reale il livello di luminosità, così da far visionare la scena nel modo in cui il regista aveva inteso realizzarla.

OLED Vs LCD: qual è migliore per l’HDR?

Senza scendere troppo nel dettaglio delle differenze tra OLED e LCD, basti qui sapere quanto segue: i televisori LED utilizzano luci per illuminare i pixel in uno schermo LCD tradizionale, mentre i pixel presenti nei display OLED producono luce propria. Questo si traduce in due differenze di fondo: la tecnologia OLED riesce a produrre un’immagine con luminosità massima inferiore all’ LCD/LED. Questo, anche per quanto detto in precedenza, porterebbe a pensare che l’OLED non è la migliore scelta per l’HDR. Ma l’OLED ha il vantaggio di poter spegnere il singolo Pixel…

Come già visto in precedenza, il consorzio UHD Alliance ha stabilito due diversi standard di HDR: il primo prevede più di 1.000 nits luminosità di picco e meno di 0.05 nits per il livello di nero. Lo standard 2 prevede, invece, più di 540 nits di luminosità e meno di 0.0005 nits per il livello nero.

Ciò significa che i produttori che desiderano realizzare televisori a LED HDR, dovranno rispettare il primo standard, mentre i produttori OLED potranno ottenere l’etichetta Ultra HD Premium conformandosi allo standard numero due. In definitiva, non si tratta di quanto sia brillante un pannello, ma del gap che si ha tra luce e buio.

E’ chiaro, però, che le TV a LED forniranno un’immagine HDR con una migliore luminosità di picco, ma con una minore profondità dei neri, mentre i televisori OLED daranno un’immagine HDR con luminosità di picco inferiore, ma con neri più profondi.

Quali contenuti TV sono disponibili in HDR?

Purtroppo non è sufficiente disporre di una TV HDR per poter fruire di tutte le trasmissioni televisive, o di tutti i film, in HDR. E’ necessario che il contenuto che si sta guardando sia stato masterizzato per l’HDR. In altre parole, sia la sorgente, sia la TV, devono essere compatibili con il formato HDR. Questo vuol dire, tendenzialmente, non avere benefici HDR dalle trasmissioni TV tradizionali. Fortunatamente, sempre più Ultra HD Blu-ray, o contenuti video in streaming online da Netflix e Amazon, godono del supporto HDR.

Conviene acquistare una TV HDR?

Dopo aver compreso cos’è l’HDR, e aver capito che anche la sorgente video deve essere masterizzata appositamente per sfruttare la tecnologia, la domanda sorge spontanea: conviene acquistare una TV HDR.

Se si guardano esclusivamente film, serie TV e programmi dalle emittenti tradizionali potreste anche fare a meno di acquistarlo. Se invece si fa un utilizzo di HD Blu Ray o si dispone di abbonamenti Amazon Prime Video o Netflix 4K, il consiglio è quello di puntare su una TV 4K HDR. E’ il momento giusto per investire sul formato, dato che i creatori di contenuti faranno a gara per produrre contenuti HDR 4K.