Apple sta esplorando l’idea di aggiungere fotocamere e funzionalità di Visual Intelligence nei suoi smartwatch, scelta che dovrebbe spingere l’azienda nel settore delle AI indossabili.

A riferirlo è Mark Gurman di Bloomerg spiegando che nel corso degli ultimi due anni abbiamo osservato la diffusione sul mercato di dispositivi AI indossabili, device che spaziano dal fallito AI Pin di Humane, agli occhiali smart di Meta.

Il filo conduttore di questi dispositivi è la possibilità di sfruttare fotocamere e microfoni a supporto dell’Intelligenza Artificiale permettendo di comprendere l’ambiente circostante dove si trova l’utente che indossa il dispositivo.

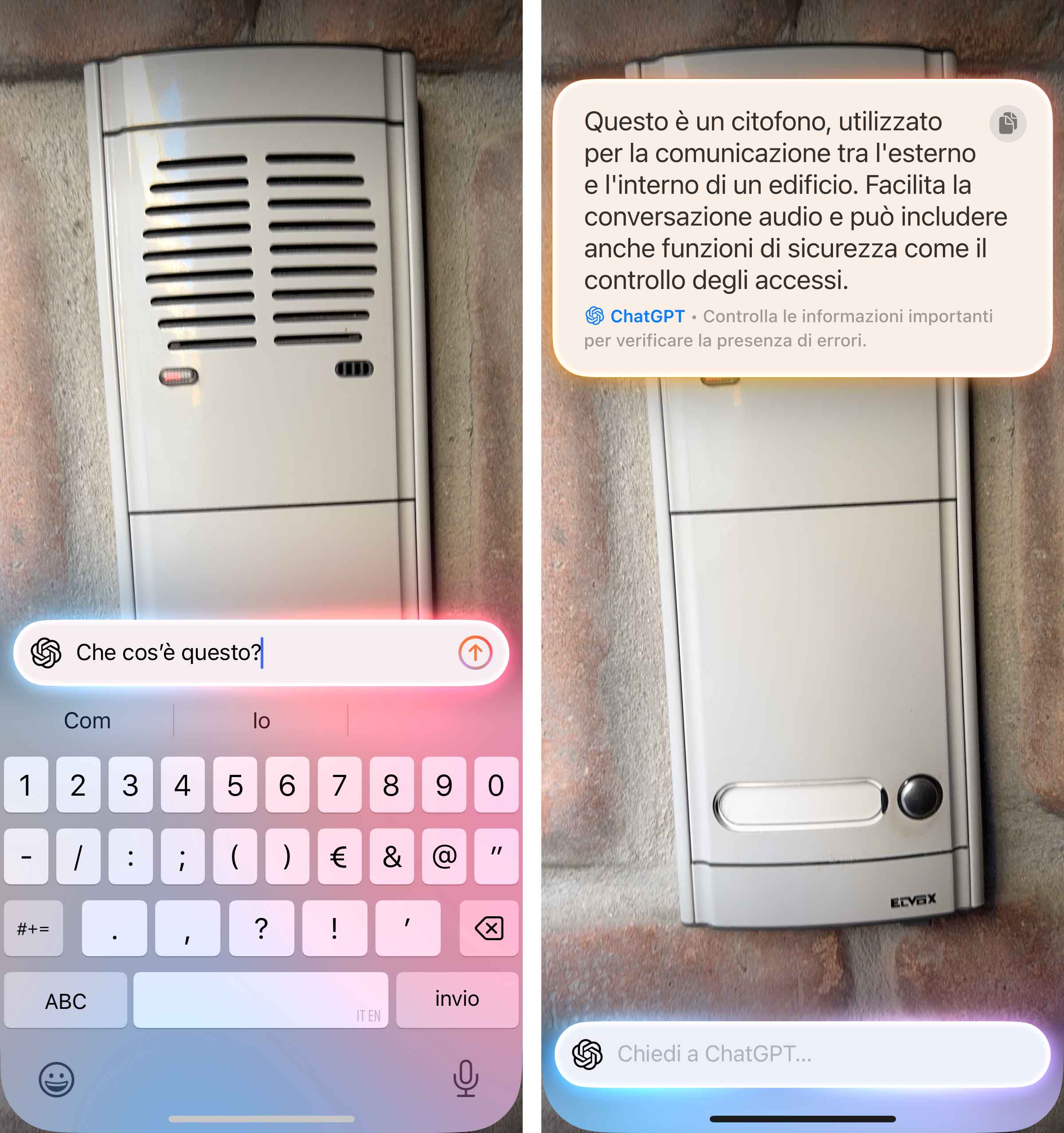

Apple ha iniziato a esplorare questo territorio lo scorso anno con la Visual Intelligence, funzionalità che permette di ottenere informazioni su luoghi e oggetti (prima disponibile solo su iPhone 16 ma da iOS 18.4 anche con iPhone 15 Pro). Sui telefoni più recenti, è possibile richiamare l’intelligenza visiva tenendo premuto il controllo fotocamera per eseguire operazioni come cercare dettagli su un ristorante o su un’attività, tradurre, riassumere o leggere un testo, identificare piante e animali e altro ancora.

Secondo Gurman Apple potrebbe integrare funzionalità simili anche su Apple Watch, ma anche su altri dispositivi, inclusi futuri AirPods con fotocamera, un modo per permettere all’AI di vedere il mondo esterno e individuare informazioni di rilievo. Si tratta di modelli AI che probabilmente vedremo fra generazioni di dispositivi, ma funzionalità del genere sarebbe sulle tabelle di marcia di Cupertino.

Apple intenderebbe sfruttare la Visual Intelligence sia sugli Apple Watch standard sia sui modelli Ultra; nel primo caso integrando la fotocamera nel display, e nel secondo caso vicino ai pulsanti laterali dell’orologio (il maggior spazio a disposizione consentirebbe questo approccio).

Con l’intelligenza visiva, lo ricordiamo, già ora (da iOS 18.4) su iPhone è possibile ottenere informazioni riguardo un attività (es. gli orari di apertura), identificare animali e piante ma anche interagire con il testo (ad esempio riassumere e tradurre un testo o leggerlo ad alta voce, identificare le informazioni di contatto in un testo, come i numeri di telefono e gli indirizzi email o i siti web, ed effettuare azioni in base al tipo di testo), chiedere a ChatGPT informazioni riguardo a ciò che stiamo vedendo, cercare elementi simili su Google, creare un evento nell’app Calendario quando ne vediamo uno su un poster o su un volantino e altro ancora.

Sempre a partire da una immagine o foto è possibile effettuare ricerche su Google per scoprire dove è possibile acquistare un articolo, o di sfruttare le capacità di problem solving di ChatGPT per chiedere spiegazioni su un diagramma complesso, per esempio negli appunti di una lezione.

L’utente ha il controllo su quando questi strumenti di terze parti vengono usati e su quali informazioni vengono condivise. È un primo esempio di AI multimodale offerto da Apple, con funzioni disponibili “al volo” senza bisogno di girare prima video o scattare immagini e poi effettuare la richies

Altre indiscrezioni sui futuri Apple Watch riferiscono del supporto ai messaggi via satellite (quando si è senza copertura cellulare e Wi-Fi) nei modelli Ultra e del supporto alla tecnologia 5G RedCap (quella che dovrebbe garantire connettività efficiente dal punto di vista dei costi e dei consumi per i dispositivi che non richiedono elevate velocità di trasmissione dei dati e in cui la latenza è meno critica).