I consumatori utilizzano sempre più la voce per interagire con il mondo che li circonda: dal comunicare con l’auto per avere indicazioni stradali all’accedere al conto bancario tramite smart speaker.

Rispetto ad altri assistenti vocali, Apple è rimasta un po’ indietro con Siri ma a Cupertino non dormono e da tempo studiano nuovi sistemi per migliorare il sistema conversazionale basato sull’IA di Siri e fornire risposte più appropriate e pertinenti.

In un documento di ricerca di Apple pubblicato da Arxiv.org – un archivio per bozze definitive (“pre-prints”) di articoli scientifici in fisica, matematica, informatica – un team di ricercatori della Mela descrive (PDF) un approccio per selezionare dati di training per il classificatore di dominio di Siri, un approccio nella classificazione dei testi che consiste nella creazione di un sistema esperto capace di prendere decisioni di classificazione.

Il componente in pratica decide a cosa fa riferimento il comando impartito da una persona, permettendo di comprendere se, ad esempio, ha a che fare con il calendario, anziché l’impostazione di una sveglia, un elemento che dovrebbe portare a una sostanziale riduzione degli errori in diversi ambiti.

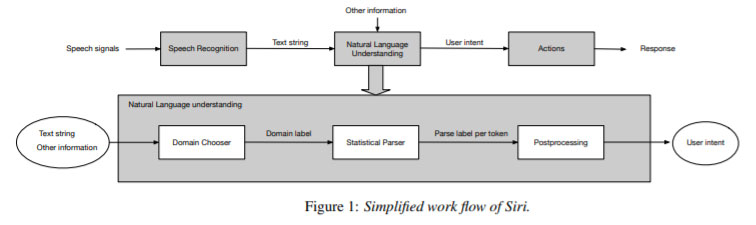

I ricercatori spiegano che Siri elabora il parlato per indagare il dominio previsto mediante un classificatore denominato “Domain Chooser” che consente di identificare l’intento dell’utente.

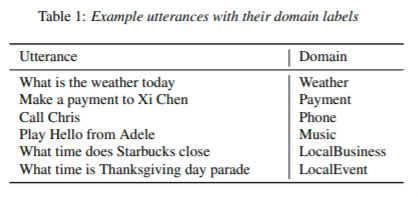

Quando, ad esempio, l’utente chiede: “Quali sono le previsioni del tempo oggi”, può tenere conto del dominio “previsioni”, e quando chiede: “Dov’è lo Starbucks più vicino”, può associare “vicino” al dominio delle “imprese locali”. Quando un’espressione riguarda uno dei 60 domini definiti, un componente denominato Parser Statistico assegna un’etichetta per misurare la salienza dei contesti, tenere conto di similarità̀ semantiche e creare una rappresentazione di intenti che avvia l’azione appropriata.

Il Domain Chooser è un sistema multi-classe composto da sette reti neurali di memorie bidirezionali a breve-termine (bi-LSTM, bidirectional long-short-term memory), un’architettura che, pur usando un catalogo di parole limitate, a quanto pare, ha permesso di ottenere prestazioni simili ad altre che impiegano cataloghi molto più ampi (da 70 milioni e 5 miliardi di parole).

Apple sta lavorando per fare comprendere a Siri frasi e parole nella globalità di un testo, un sistema che in futuro potrebbe permettere di prevedere in maniera precisa l’input testuale. Esperimenti hanno dimostrato la possibilità di ridurre il tasso di errore, migliorando i meccanismi di training sfruttando un contesto globale che elabora l’intero contesto semantico.

Gli sviluppatori Apple, insomma, non dormono sugli allori, ma stanno trovando nuovi metodi e tecnologie per migliorare Siri. Il Guardian pochi giorni addietro ha riferito che la Casa di Cupertino è al lavoro su una tecnologia che permetterà di conversare con l’utente, anche su argomenti concernenti la salute.

Non solo Apple ma anche i competitor sono al lavoro su strumenti di intelligenza artificiale che utilizzano le reti neurali di quarta generazione (DNN) e combinano biometria vocale e comprensione del linguaggio naturale (NLU) per offrire nei canali vocali esperienze più personalizzate e vicine a quelle umane.