Apple ha pubblicato una FAQ (un documento con domande e risposte) sul nuovo meccanismo che su iOS 15, iPadOS 15 e macOS Montery permetteràdi contrastare la pedopornografia, identificando le immagini sospette quando queste vengono caricate su iCloud Foto o scambiate con l’app Messaggi.

Il documento (in PDF) mira a placare gli animi di quanti non hanno capito come funzionerà il sistema, paventando censure preventive e potenziali rischi per meccanismi di controllo utilizzabili da governi e regimi vari che potrebbero pretendere anche il controllo per altre tipologie di immagini (es. simboli non graditi, avversari politici, ecc.).

“Da quando abbiamo annunciato queste nuove funzionalità”, si legge nel documento, “molti soggetti, incluse organizzazioni che si occupano di privacy e altre che si occupano di sicurezza infantile, hanno espresso il loro sostegno per la nuova soluzione, e alcune ci hanno contattato per porre delle domande”, si legge nella FAQ Apple sul sistema anti pedopornografia. “Questo documento è pensato per affrontare tali questioni, offrendo maggiore chiarezza e trasparenza sul procedimento”.

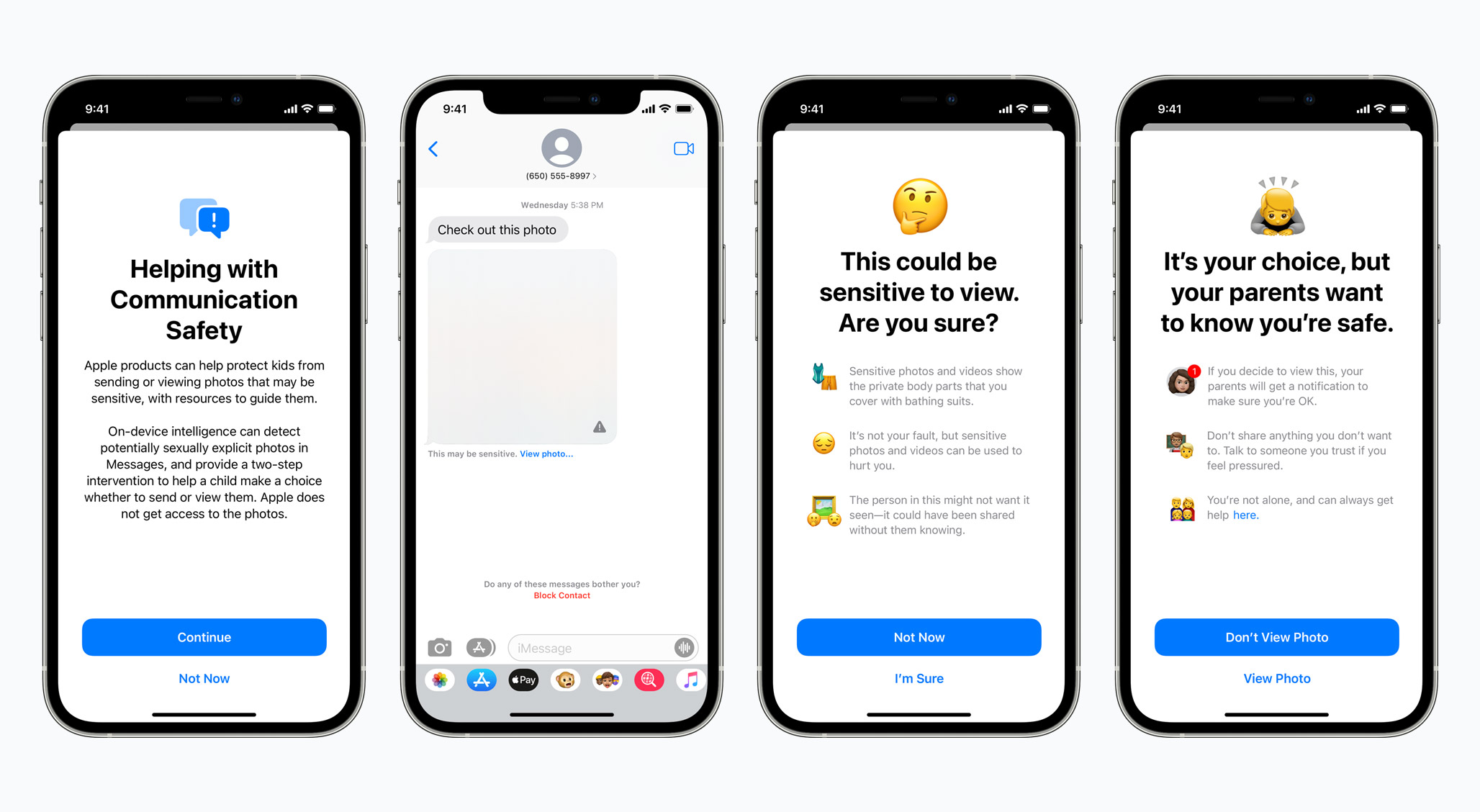

Nel documento Apple distingue la questione delle immagini automaticamente identificate e caricate su iCloud Foto da quelle scambiate con l’app Messaggi. Le funzionalità di sicurezza di quest’ultima app, spiega Apple, sono attive solo per gli account “In Famiglia”, gli account che permette fino a cinque persone dello stesso gruppo familiare di avere accesso ai vari servizi Apple. Il meccanismo di verifica è attivo solo per le immagini inviate e ricevute verso e da account “In Famiglia”; l’individuazione di immagini materiale pedopornografico (CSAM, acronimo di Child Sexual Abuse Material), “riguarda solo gli utenti che scelgono di caricare le foto su iCloud”, e la funzione non riguarda in alcun modo chi non carica le foto sul servizio di Apple.

Il documento è piuttosto completo e risponde a tutta una serie di domande e dubbi sulla sicurezza dell’app Messaggi, se è vero che Apple invia informazioni a forze dell’ordine, se questo sistema rende superflua la cifratura end-to-end e molto altro ancora.

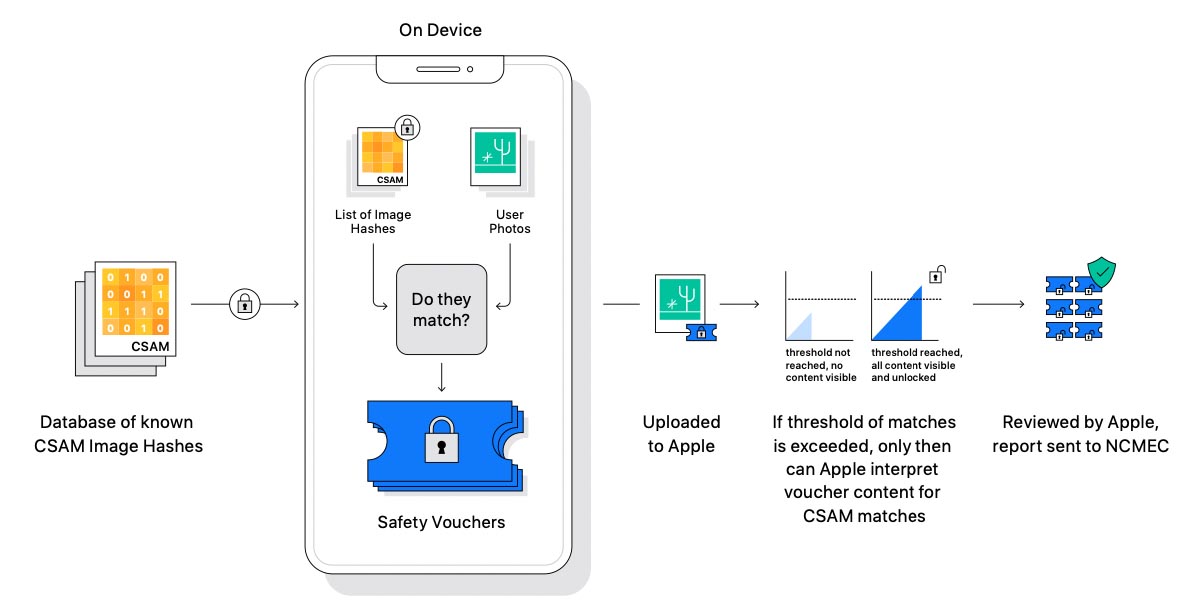

A grandi linee, come abbiamo già spiegato, Apple sfrutta un sistema di controllo che prevede un doppio processo crittografico per attingere a un database di immagini pedopornografiche note, al fine di ottenere stringhe di testo, una sequenza sfruttata per analizzare le caratteristiche delle immagini caricate su iCloud Photos e individuare similitudini. Le immagini nelle quali saranno individuate similitudini con quelle presenti in archivi noti saranno caricate con una etichetta nascosta attivando un controllo da parte di controllori umani. Ogni immagine viene rivista manualmente ed eventualmente segnalata al Centro nazionale per i bambini scomparsi e sfruttati (NCMEC), ente istituito dal Congresso e supportato dal dipartimento di Giustizia statunitense che collabora con le forze dell’ordine.

Apple ha già spiegato di non avere accesso in alcun modo alle immagini che non risultano simili a quelle degli archivi pedopornografici e di non poter accedere ai metadati delle immagini segnalate finché non viene raggiunta una determinata soglia di segnalazioni per un account.

Come abbiamo già spiegato qui, tra i dubbi dei ricercatori di sicurezza ed esperti di privacy, la possibilità che Apple venga in qualche modo obbligata da alcuni governi a individuare e rivelare scambio e caricamento di immagini poco gradite ai regimi, un pericoloso precedente che ha fatto scattare il campanello di allarme di organizzazioni quali Electronic Frontier Foundation (EFF).

Nella FAQ, Apple afferma che rifiuterà sempre di individuare richieste da parte di governi per identificare immagini diverse da quelle pedopornografiche. “Abbiamo già affrontato richieste dei governi per la creazione e distribuzione di cambiamenti che degradano la privacy degli utenti; abbiamo sempre fermamente rifiutato tali richieste e continueremo a farlo in futuro. Diciamolo chiaramente: questa tecnologia è limitata all’identificazione di materiale pedopornografico memorizzato su iCloud, e non aderiremo a qualsiasi richiesta governativa per espandere il sistema”.