Una vittima di abusi sessuali infantili ha citato in giudizio Apple per avere eliminato nel 2022 la tecnologia CSAM Detection – il sistema di tutela che avrebbe dovuto verificare automaticamente l’eventuale presenza di immagini pedopornografiche negli iPhone e negli altri dispositivi prodotti dall’azienda, per tutelare i minori – scansionando le immagini presenti su iCloud.

Apple aveva previsto questa funzionalità nel 2021, una novità che avrebbe voluto integrare in iOS 15 ma prima della presentazione del sistema operativo aveva fatto marcia indietro dopo che numerose organizzazioni per la difesa della privacy avevano segnalato contrarietà evidenziando pericoli per la possibilità che l’algoritmo generasse falsi positivi.

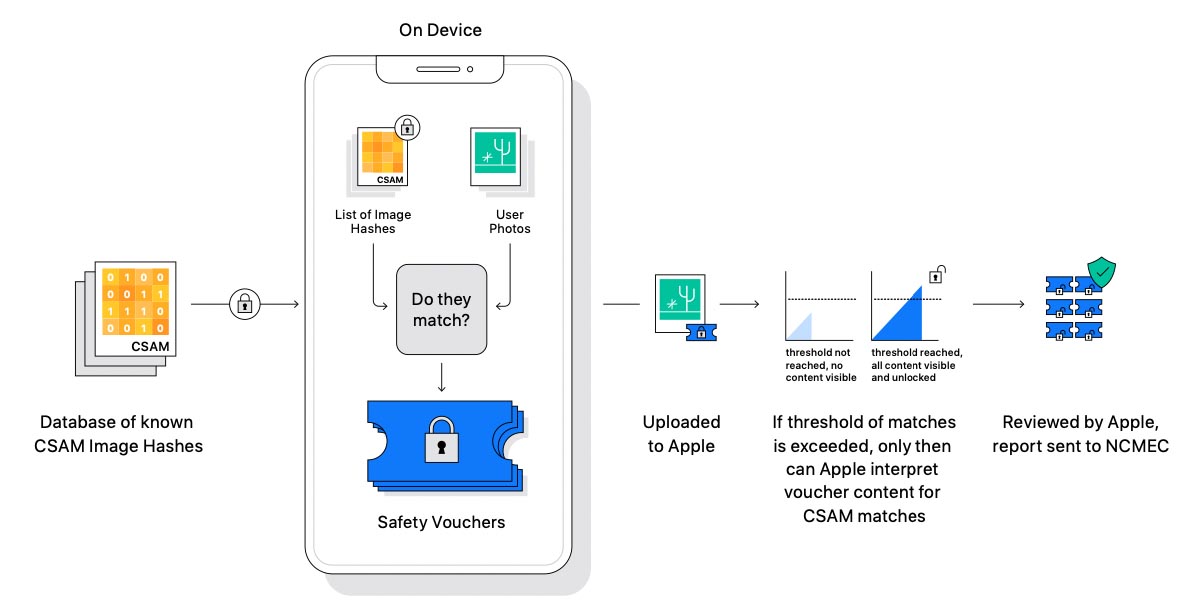

Dal punto di vista tecnico, il sistema permetteva di individuare automaticamente la presenza di materiale pedopornografico analizzando le immagini attraverso un algoritmo che in gergo si chiama NeuralHash: individuando la corrispondenza tra gli hash delle foto presenti sul dispositivo (solo quelle che vengono caricate su iCloud) con gli hash inclusi nel database del National Center for Missing and Exploited Children (NCMEC), inviando eventualmente segnalazioni alle forze dell’ordine.

Su pressione di gruppi per la difesa della privacy e non solo, Apple – come accennato – aveva fatto marcia indietro e ora una 27enne statunitense – vittima da bambina di abusi sessuali da parte di un familiare – ha citato in giudizio l’azienda per l’eliminazione della funzionalità in questione.

La donna afferma che quando Apple stava sperimentando la funzionalità, aveva ricevuto una segnalazione da parte delle forze dell’ordine perché immagini di suoi abusi erano state individuate su un account iCloud, caricate da un MacBook sequestrato nel Vermont.

Nella denuncia, la donna sottolinea che Apple non ha mantenuto la promessa di proteggere vittime come lei, eliminando la funzionalità di scansione CSAM da iCloud e permettendo ai pedofili di condividerle senza che le forze dell’ordine possano ricevere segnalazioni automatiche. Nella citazione la donna afferma che Apple vende “prodotti difettosi che danneggiano determinate categorie di clienti” come lei.

Nell’azione legale la donna chiede che Apple modifichi le procedure seguite, e pensi a eventuali obblighi di risarcimento nei confronti di 2680 potenziali altre vittime, evidenziando che tecnologie CSAM sfruttate da Google e Meta sono in grado di individuare molto materiale illegale in più rispetto alle funzioni anti-nudità di Apple.

Secondo la legislazione vigente negli USA, le vittime di abusi sessuali sui minori possono essere risarcite con un minimo di 150.000$; se tutti i potenziali ricorrenti citati nella denuncia della donna dovessero ottenere il ristoro per il presunto danno subìto, il risarcimento totale potrebbe superare 1,2 miliardi di dollari.

Prima che Apple decisse di eliminare la funzione di scansione CSAM, la Electronic Frontier Foundation aveva lanciato una petizione per chiedere ad Apple di non implementare simili meccanismi di verifica, altre associazioni invece avevano lodato l’iniziativa, indicata come positiva anche da associazione italiane per la tutela dei minori.