Oltre ad avere implementato nuove funzionalità di cifratura end-to-end per Foto di iCloud, Apple ha fatto sapere di avere abbandonato l’idea di implementare nei suoi sistemi operativi la funzionalità che avrebbe consentito di scansionare le foto caricate dagli utenti su iCloud consentendo di individuare materiale pedopornografico (CSAM, acronimo di Child Sexual Abuse Material), con l’obiettivo di riferire eventuali violazioni al National Center for Missing and Exploited Children (NCMEC), organizzazione non a scopo di lucro che si occupa – tra le altre cose – della tutela di minori.

L’abbandono della tecnologia di rilevamento CSAM è stato riferito da un portavoce di Apple a WIRED: “Dopo ampie consultazioni con esperti per raccogliere osservazioni su iniziative per la protezione dei minori che avevamo proposto lo scorso anno, stiamo dedicando investimenti nella funzionalità di Limitazioni Comunicazioni che abbiamo già reso disponibile a dicembre 2021. Abbiamo inoltre deciso di non portare avanti il precedentemente proposto strumento di rivelazione CSAM per Foto di iCloud. I minori possono essere protetti senza che le aziende setaccino dati personali, e continueremo a lavorare con governi, rappresentanti dei bambini e altre aziende per contribuire a proteggere i minori, preservare il loro diritto alla privacy e rendere internet un luogo più sicuro per i bambini e per tutti noi”.

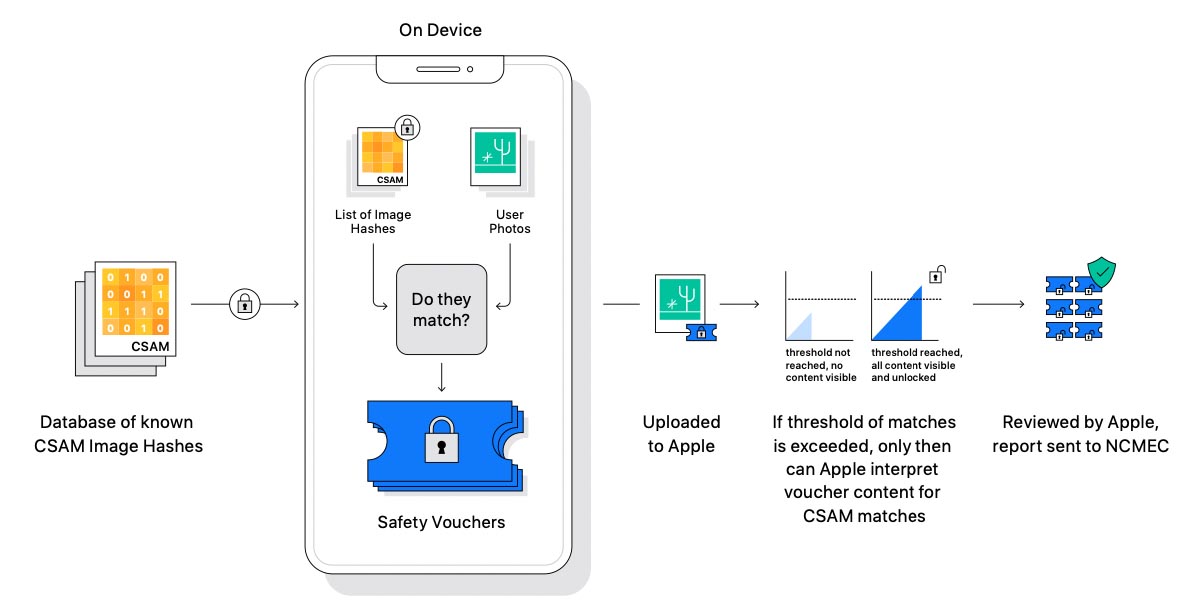

L’idea di Apple – ora abbandonata – era quella di sfruttare quello che in gergo si chiama hashing profondo per la per la ricerca di similarità, un meccanismo che avrebbe consentito di confrontare gli scatti caricati sul cloud con altre immagini note presenti in archivi CSAM. Trovata una qualche similitudine, la foto poteva essere caricata su iCloud con un “voucher di sicurezza crittografico” e – in determinate circostanze – attivare una procedura di revisione per verificare un legame con materiale pedopornografico.

Ricercatori contrari a questo sistema, hanno in precedenza evidenziato che il sistema di scansione preventivo in futuro poteva essere usato da qualche governo per obbligare la scansione di altre tipologie di immagini, es. simboli anti-governativi o immagini di proteste. Altri dubbi derivano dai falsi positivi che una simile tecnologia potrebbe generare, “collisione” causata da due immagini differenti con lo stesso hash: se a due immagini era associato lo stesso hash, Apple avrebbe potuto erroneamente rilevare come contenuto CSAM una foto normale.

La Electronic Frontier Foundation aveva lanciato una petizione per chiedere ad Apple di non implementare simili meccanismi di verifica, altre associazioni invece avevano lodato l’iniziativa, indicata come positiva anche da associazione italiane per la tutela dei minori.

Apple ha prima cercato di spiegare in vari modi che il sistema teneva conto di meccanismi sulla privacy, tenendo conto di specifiche porzioni di lettere e numeri (hash) ottenibili confrontando le immagini con archivi CSAM già noti alla ricerca di possibili corrispondenze, e che solo in questi cassi sarebbe scattata la verifica. L’EFF aveva nel frattempo raccolto migliaia di firme chiedendo a Apple di abbandonare il progetto; stesa cosa altre organizzazioni, criticando l’azienda per avere deciso unilateralmente cosa fare su argomenti così delicati. A settembre dello scorso anno Apple aveva dichiarato «Visti i riscontri da parte dei clienti, dei gruppi per la tutela dei minori, dei ricercatori e di altri soggetti, abbiamo deciso di prenderci altro tempo nei prossimi mesi per raccogliere suggerimenti e apportare dei miglioramenti prima di diffondere queste funzionalità essenziali per la sicurezza dei bambini”.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)