Apple ha preso provvedimenti contro alcune app che sfruttavano l’AI generativa per creare in modo non consensuale nudità partendo da immagini di persone, ignare di questo utilizzo.

A riferirlo è il sito 404 Media, spiegando che Apple ha rimosso alcune app che pubblicizzavano la possibilità di “spogliare” chiunque.

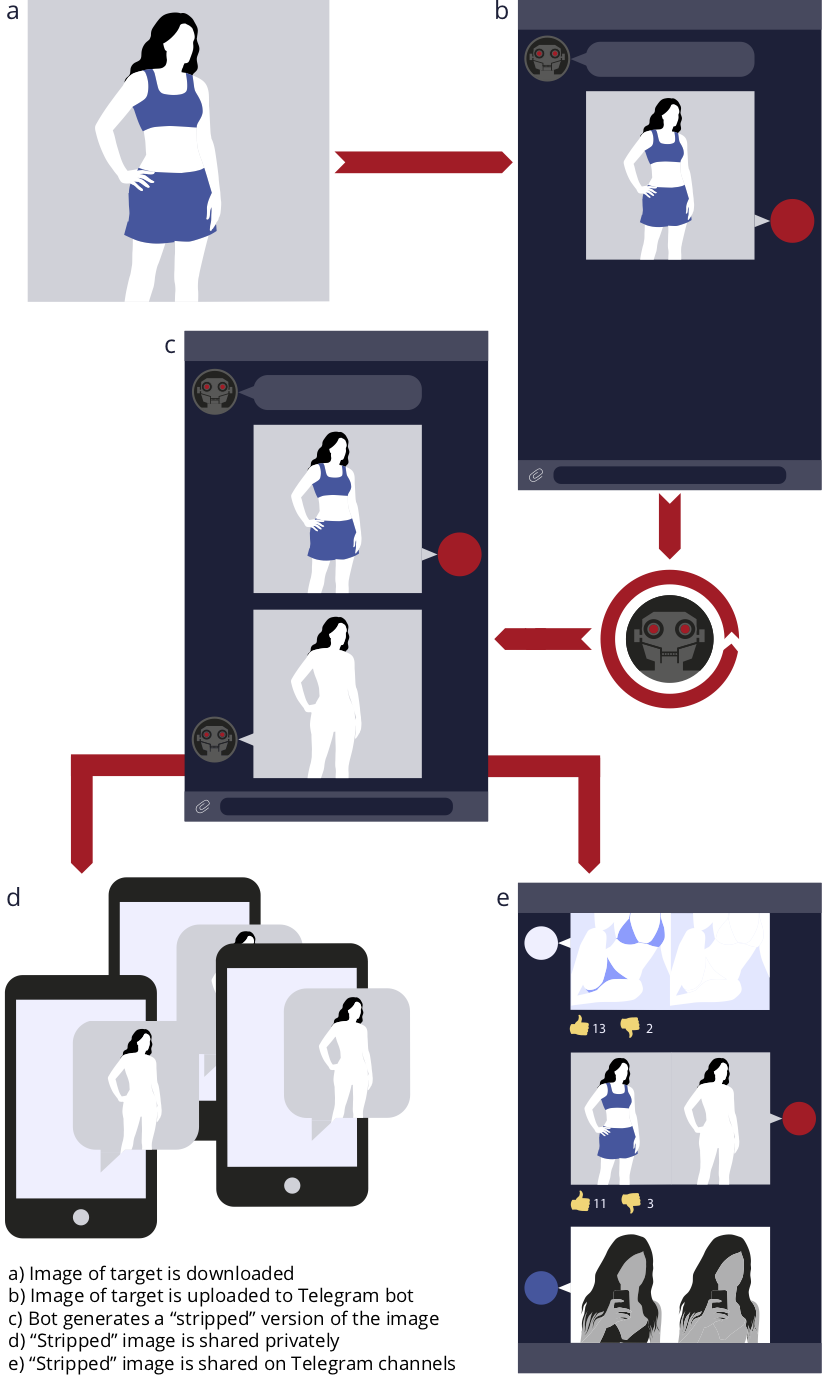

Tra i potenziali problemi dell’AI generativa, gli usi impropri, compresa la possibilità di spogliare virtualmente le persone, ottenendo una immagine analoga all’originale, con la rimozione virtuale degli indumenti del soggetto fotografato (tenendo conto di aspetti quali: scena, luci, corporatura, posa, colore della pelle, ecc.).

Stando a quanto riferisce 404 Media, sull’App Store era possibile trovare varie app in grado di ritoccare le immagini in modo artificiale e denudare malcapitati e inconsapevoli soggetti. Alcune di queste app si limitavano al semplice face-swapping (la sostituzione del volto di una persona nota, con quello di una nuda), altre erano reclamizzate come app “Undress” (per svestire virtualmente le persone). Dopo avere ricevuto più segnalazioni, Apple ha rimosso le app “incriminate”; una mossa simile è stata fatta anche da Google, rimuovendo app del tutto analoghe dal Play Store. Interessante notare che le app in questione erano pubblicizzate su Instagram; segnalazioni specifiche sono state fatte anche a Meta. Non è chiaro come le app incriminate abbiamo superato le procedure di revisione da parte di Apple.

Nel 2020 il nostro garante Privacy aveva avviato delle indagini per un bot Telegram in grado di spogliare le persone. Alcune donne si erano ritrovate vittime di un particolare tipo di “deep fake”, cioè video e immagini realizzati attraverso delle app che consentono di trasformare il volto, la voce e il corpo delle persone, creando veri e propri “falsi”.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)