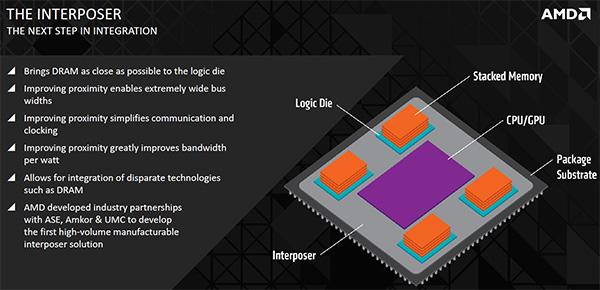

AMD ha rivelato nuovi dettagli su High Bandwidth Memory (HBM), tecnologia nata dalla collaborazione con SK Hynix che dovrebbe essere sfruttata al posto delle memorie GDDR sulle future schede video. La soluzione HBM promette di portare la DRAM vicinissima al die logico, consentendo la gestione di bus con grandi larghezze di banda e migliorare vari aspetti, inclusa la velocità e i consumi.

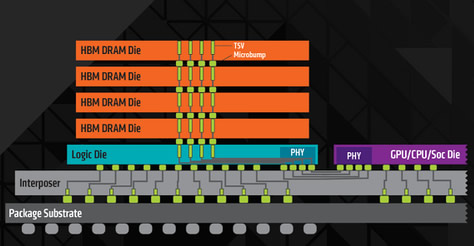

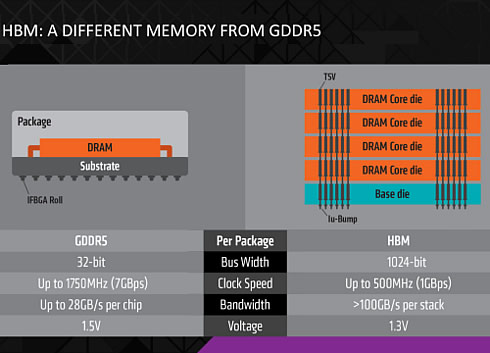

Secondo AMD l’uso della tecnologia High Bandwidth Memory permette di gestire 100 gigabyte al secondo di bandwidth, portata molto più elevata di dati rispetto ai 28 GB/s permessi attualmente dalle schede con memorie GDDR5. Il “trucco” è l’uso di un interposer, un componente passivo (senza transistor attivi) sfruttato per le interconnessioni elettriche permettendo di collegare più die DRAM sovrapposti uno sull’altro, a “stack” (una tecnica già usata su alcuni dispositivi FPGA di Xilinx). Ogni stack prevede cinque livelli, quattro per die per l’archiviazione e un die logico di controllo.

Oltre alla migliore ampiezza di banda per watt (35 GBytes/s) rispetto alle memorie GDDR5, lo stack HBM richiede uno spazio di 35 mm quadrati, il 94% in meno rispetto a quanto necessario con i chip GDDR5. Secondo AMD il package di una singola GPU con HBM richiederà meno di 70mm X 70mm contro i 110mm X 90mm richiesti, ad esempio, dall’AMD R9 290X; è dunque lecito aspettarsi l’arrivo di prodotti ancora più compatti.

Anche Nvidia aveva qualche tempo addietro annunciato di essere al lavoro con Micron, competitor di SK Hynix, su una memoria di nuova generazione denominata Hybrid Memory Cube (HMC), conduttori verticali che collegano elettricamente una pila di singoli chip per combinare dispositivi logici ad alte prestazioni con la DRAM.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)