A inizio aprile 2024 ricercatori di Apple hanno svelato un nuovo modello di linguaggio sul quale l’azienda sta lavorando e un documento di ricerca mostra ora interessanti aspetti di tecnologie AI sulle quali Apple sta lavorando.

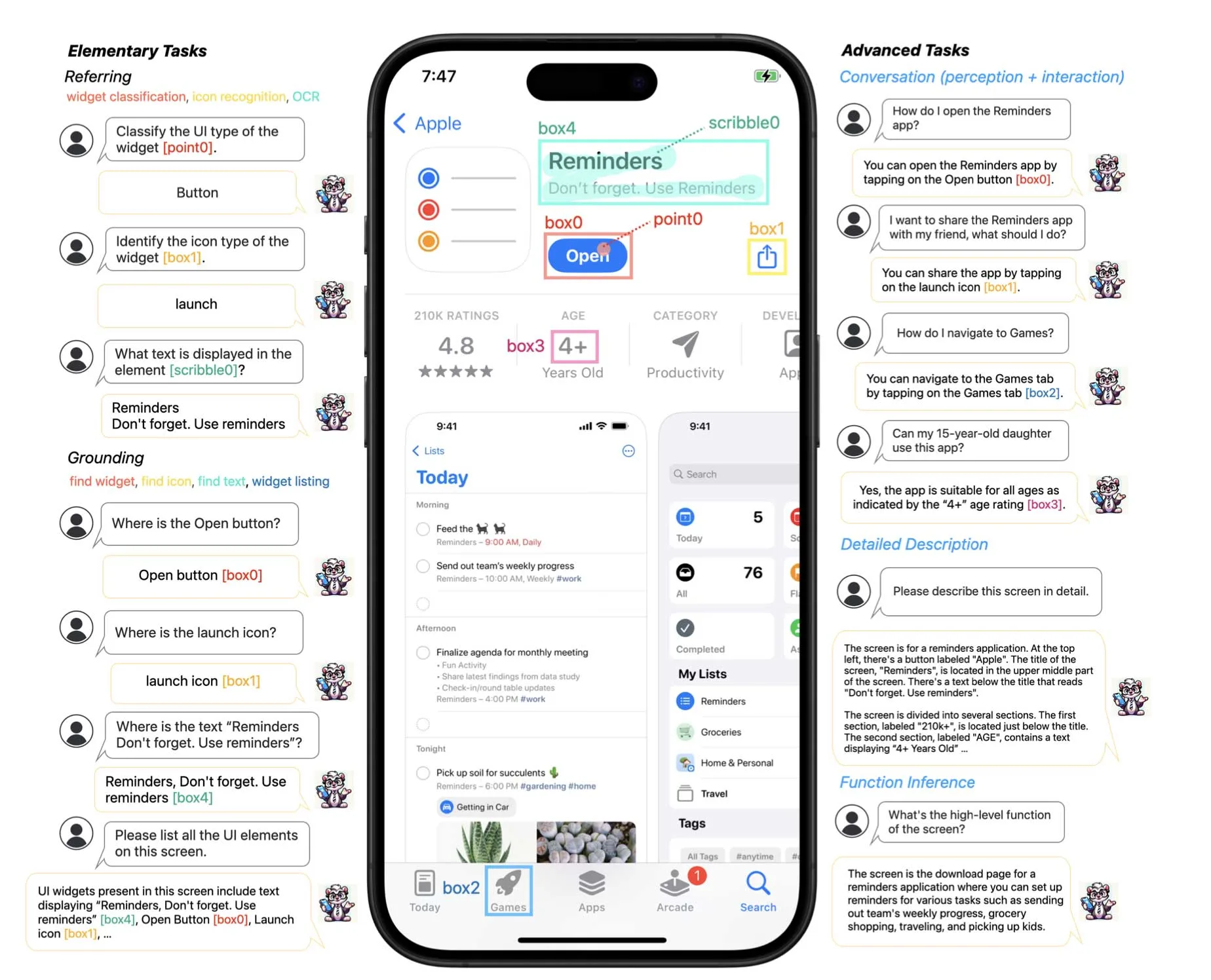

Sul sito arXiv (archivio di pubblicazioni scientifiche) è presente un documento di ricerca (PDF) con la presentazione di Ferret-UI, un modello linguistico multimodale di grandi dimensioni (MLLM) in grado di comprendere elementi dell’interfaccia utente sullo schermo.

Gli MLLM sono diverso dagli LLM (modelli linguistici di grandi dimensioni) perché oltre al testo, sono in grado di comprendere elementi multimodali quali gli elementi dell’interfaccia sullo schermo, combinando le capacità della comprensione del linguaggio, della computer vision e del riconoscimento audio in un unico modello.

Riconoscere automaticamente i vari elementi sullo schermo è sempre stato un compito complesso per le AI ma Ferret, frutto di una collaborazione tra Gan e altri ricercatori di Apple e della Columbia University, sembra in grado di riconoscere perfettamente vari elementi sullo schermo ed eseguire di conseguenza compiti specifici anche complessi.

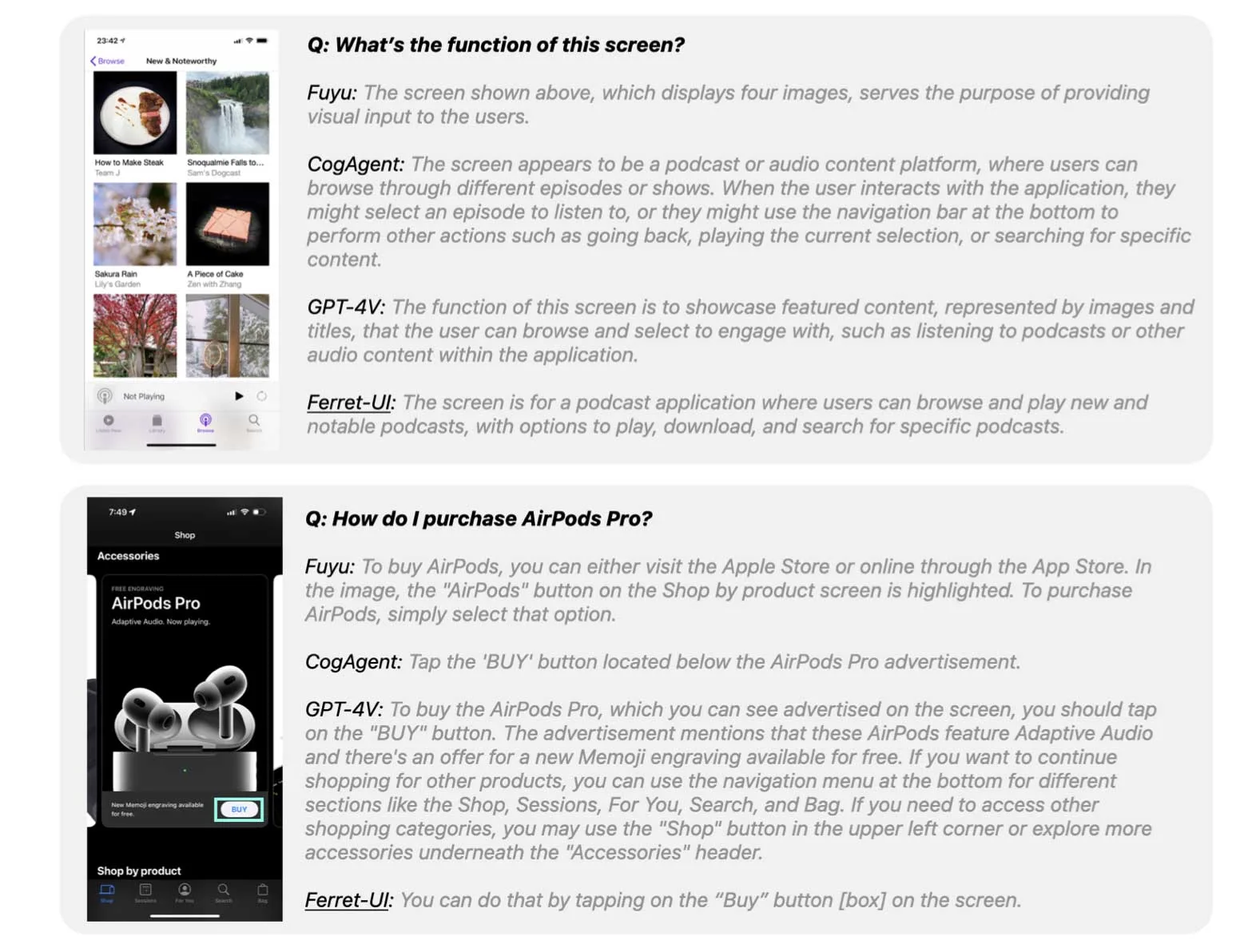

Sono stati fatti dei confronti con le possibilità offerte del modello in questione con altri MLLM e Ferret risulta migliore di GPT-4 di OpenAI in vari aspetti.

Ferret supera GPT-4V in vari compiti elementari quali il riconoscimento delle icone, l’OCR, la classificazione dei widget, nell’individuare icone e widget su iPhone e Android.

Obiettivo di Apple è rendere Ferret compatibile con gli smartphone, offrendo migliorie delle quali potrà tenere conto Siri permettendo all’utente di eseguire vari compiti con comandi vocali, azioni più complesse del rispondere alle domande con la voce, alla stregua di quanto possibile con un gadget come il Rabbit R1 (assistente portale con AI che si propone come alternativa allo smartphone). È probabile che funzionalità AI avanzate arriveranno con iOS 18 e nei futuri iPhone, permettendo di lavorare sia con testi, sia con le immagini, tenendo conto di quello che appare sullo schermo, combinando dati testuali e immagini. In un esempio in un diverso documento di ricerca di Apple un modello di intelligenza artificiale generativa, denominato MM1, è stato ad esempio in grado di analizzare due foto: un menu e delle bottiglie di birra sul tavolo e rispondere alla domanda sul conto da pagare, calcolando correttamente il costo, risposta possibile grazie alla sorprendente quantità di dettagli sui quali è stata addestrata l’AI.

Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili a partire da questa pagina di macitynet.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)