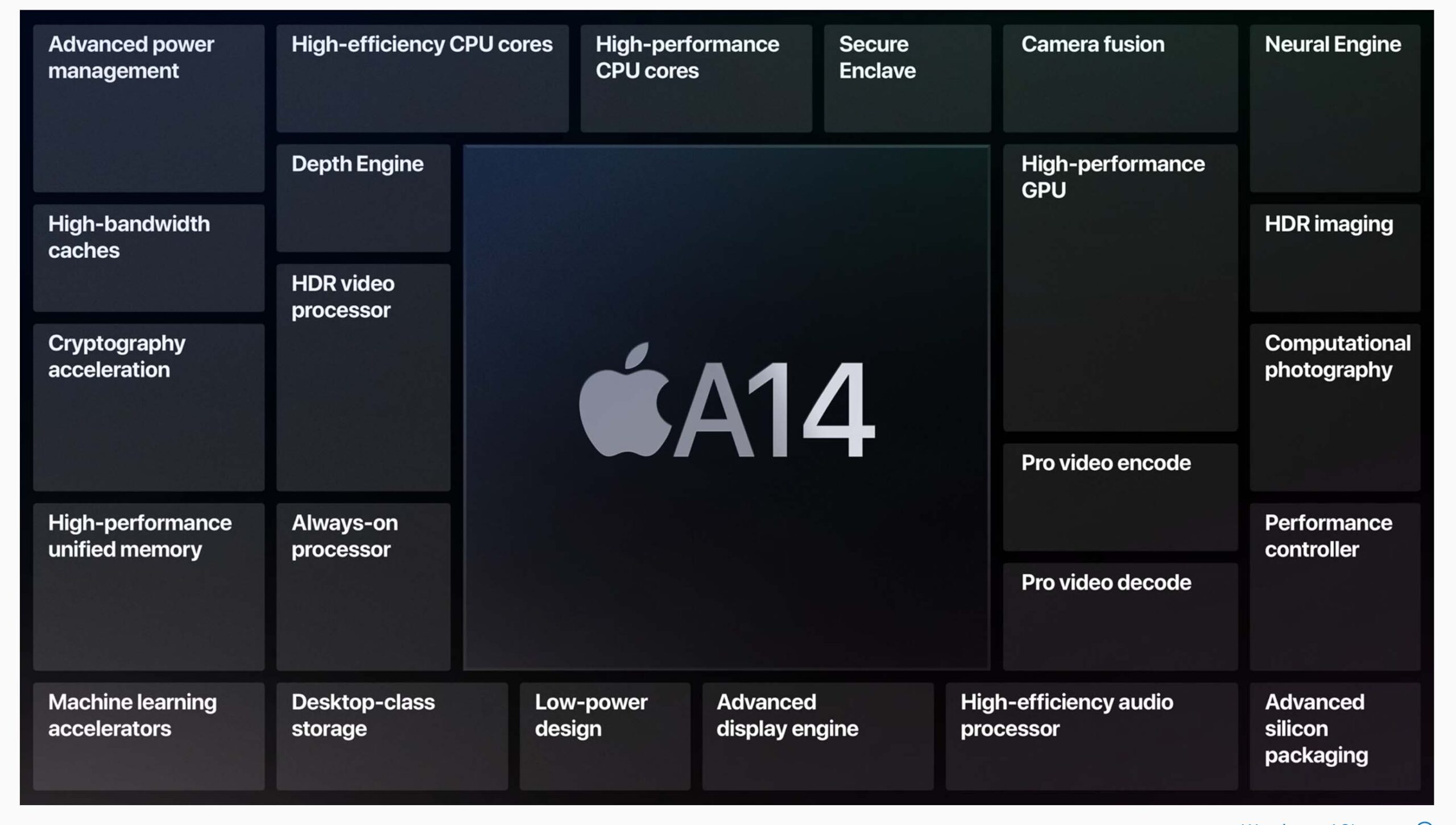

Bisogna aspettare ancora qualche giorno per la presentazione ufficiale di iPhone 12 e avere nuovi dettagli sull’A14, il SoC con tecnologia a 5nm che Apple ha già sfruttato su iPad Air 4. Non si conoscono ancora alcuni aspetti ma dai primi benchmark apparsi sul web emergono ad ogni modo dettagli decisamente interessanti sia per quanto riguarda le prestazioni della CPU (design a 6 core), sia per quanto riguarda le prestazioni della GPU con Metal (architettura grafica a 4 core).

In attesa di conoscere altri dettagli su nuclei di calcolo e GPU, Apple ha sottolineato le innovative capacità di apprendimento automatico dell’A14 Bionic con il nuovo Neural Engine a 16 core, evidenziando una velocità due volte superiore (rispetto alla generazione precedente), capace di eseguire fino a 11 trilioni di operazioni al secondo, funzionalità che permetteranno di portare a un nuovo livello le app che sfruttano il machine learning.

Intervistato dalla testata giornalistica tedesca “Stern“, il vice presidente responsabile platform architecture di Apple, Tim Millet, ha indicato alcune peculiarità sul versante apprendimento automatico, spiegando che questo permetterà di avere “una categoria di applicazione completamente nuove”, arrivando ad affermare di “restare senza fiato, quando penso a cosa le persone possono fare con l’A14”.

Apple non ha inventato le reti neurali, “le fondamenta per queste reti sono state poste molti decenni fa”, ha dichiarato Millet. “Ma all’epoca vi erano due problemi: non c’erano dati e non era disponibile la potenza di calcolo per sviluppare complessi modelli in grado di elaborare grandi quantità di dati”. “Nel 2012 c’è stata finalmente una svolta che ha consentito di accelerare i tempi di addestramento dei modelli. Solo allora tecnologie come lo sblocco con il riconoscimento facciale sono diventate concepibili con uno smartphone”.

Millet ha sottolineato che tra i benefici offerti da Apple c’è il lavoro congiunto dei team hardware e software in grado di lavorare a stretto contatto per massimizzare le performance dei processori, estendendo i vantaggi anche agli sviluppatori di terze parti. “Lavoriamo a stretto contatto con i nostri team software durante tutto il processo di sviluppo affinché non ci si limiti a creare un pezzo di tecnologia utile solo a pochi. Vogliamo essere sicuri che migliaia e migliaia di sviluppatori iOS siano in grado di poterci fare qualcosa”.

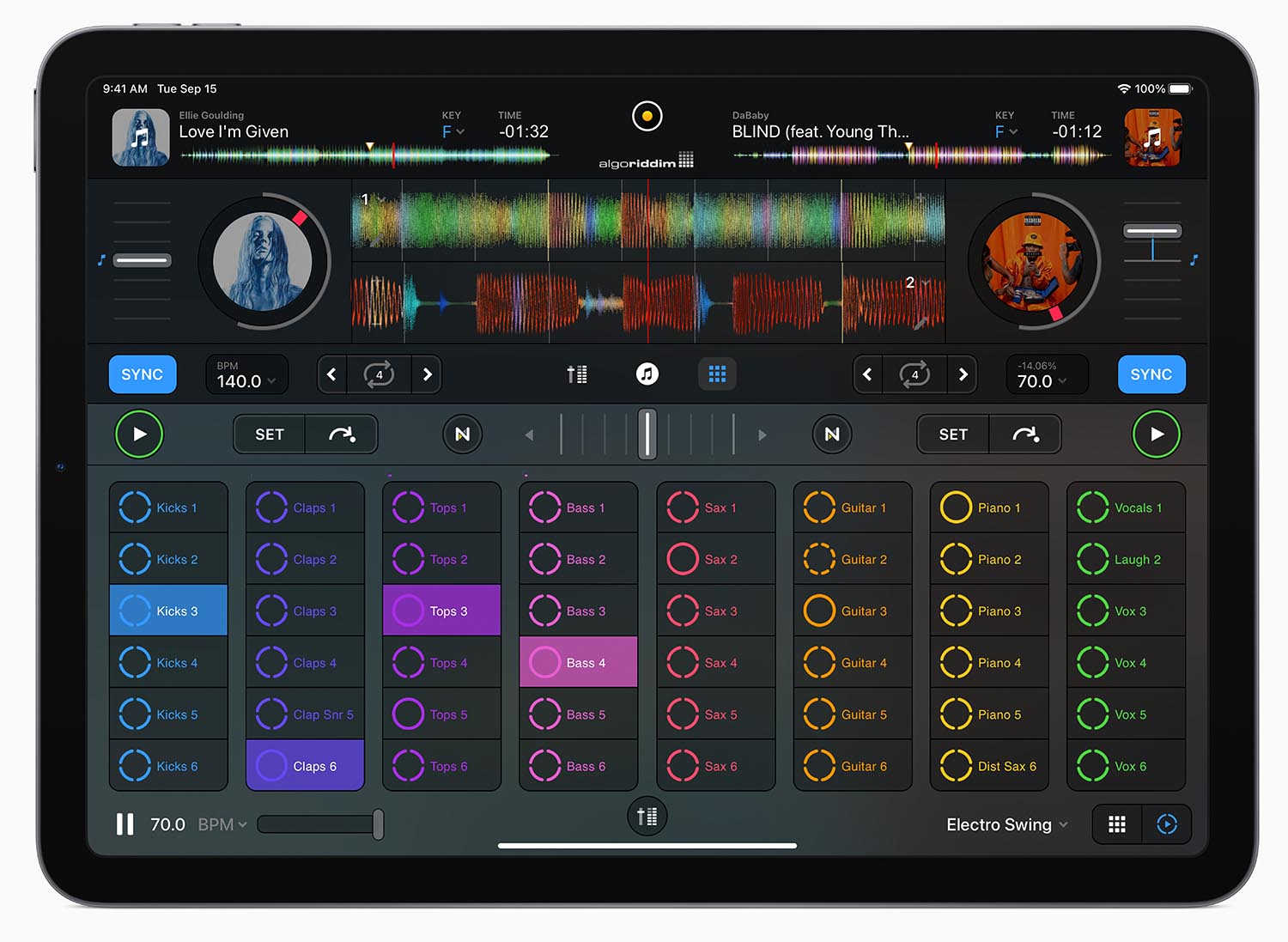

“Core ML (tecnologia che offre agli sviluppatori capacità di machine learning on-device, ndr), “è una fantastica opportunità per le persone che vogliono capire e scoprire quali possibilità hanno”. “Abbiamo investito molto tempo per essere sicuri di non inserire semplicemente nel chip dei transistor che poi non verranno utilizzati. Vogliamo un utilizzo di massa”.

Tra le funzionalità possibili grazie al Neural Engine, anche il Face ID, la tecnologia di sbloccare in sicurezza iPhone con il volto. A chi fa notare che Apple avrebbe potuto trovare un modo per offrire il riconoscimento anche con le mascherine sul volto, Millet spiega che questo avrebbe potuto compromettere la sicurezza. Sarebbe possibile sfruttare una forma di riconoscimento del volto usando solo la parte superiore del viso ma Apple ha preferito la sicurezza alla comodità dello sblocco con la mascherina sul volto. La soluzione potrebbe essere quella di mettere a disposizione sia Face ID, sia Touch ID (sblocco con le impronte) e non è detto che qualcosa non si muova in questo senso: sull’iPad Air 4 il Touch ID è stato integrato nel tasto superiore permettendo di fare login in modo veloce, semplice e sicuro.