Intel si ispira a Firenze per quella che ritiene la prossima rivoluzione non solo delle GPU, ma anche della programmazione e in generale per l’architettura dei processori: a Denver, in occasione dell’evento Supercomputing 2019, ha infatti presentato Intel “Ponte Vecchio“, una GPU ottimizzata per HPC e accelerazione AI, basata sull’architettura Xe.

Dietro al nome in codice che richiama uno dei simboli della città Toscana, si nasconde un prodotto che dovrebbe rivoluzionare il mercato dei processori per computer e materializzare la visione di Intel sulla convergenza di high-performance computing (HPC) e intelligenza artificiale (AI)

Raja Koduri, ingegnere che per anni ha lavorato con Apple e Advanced Micro Device (AMD), da tempo sta guidando un team in Intel che si occupa dello sviluppo di una GPU discreta. Intervistato da ZDNet, Koduri afferma che la rivoluzione del GPU computing da cui nasce Ponte Vecchio è tuttora in evoluzione.

“Siamo a un punto di svolta per l’high-performance computing”, riferisce Koduri. “Venti anni addietro, il settore dell’HPC era dominato da architetture integrate verticalmente, ma poi i prodotti X86 hanno preso il sopravvento, con il software open source e l’esplosione di librerie, i cluster e una pletora di software”.

È stato il movimento intorno al software a suo dire a permettere di arrivare a una nuova era che permette di eseguire calcoli su macchina dalla potenza equivalente ai supercomputer. Il prossimo ciclo è la combinazione dei mondi dell’IA con architetture eterogenee non lineari nel rapporto tra utilizzo tradizionale e throughput del sistema.

Koduri evidenzia che quanto presentato da Intel nell’ambito delle nuove Graphics Processing Unit (GPU) è progettato espressamente per l’high-performance computing, nome in codide “Ponte Vecchio”. Siamo ancora a un anno di distanza dalla produzione ma la direzione è indicata come un segno dei tempi, con ottimizzazioni possibili grazie al deep learning.

Le API OneAPI sono in un certo senso la continuazione del lavoro che Koduri ha portato avanti per molti anni. «Niente insegna meglio dei fallimenti». AMD, spiega ancora, è stata la prima a mettere a disposizione unità di elaborazione grafica (GPU) per scopi diversi dal tradizionale utilizzo nella grafica computerizzata. (in gergo GPGPU), due anni prima di Nvidia, facendo però l’errore di non partire dal software e permettendo così a Nvidia e al suo CUDA programming toolkit di aprirsi e suscitare l’interesse dell’industria del settore.

In Intel, spiega ancora Koduri «Abbiamo seguito un approccio completamente diverso», partendo prima di tutto dal software. «Abbiamo oltre 1.000 ingegneri che da 18 mesi stanno portando avanti uno sforzo immenso. La sfida per Intel è complessa perché non ha un’unica base di riferimento come Nvidia ma una serie di processori diversi, inclusi Xeon, Ponte Vecchio e future iterazioni della sua GPU, chip Mobileye, Movidius, la famiglia Agilex di FPGA e i processori neurali Nervana, solo per citarne alcuni. Quando Koduri era in AMD diceva sempre che Intel offriva un pranzo a “buffet” mentre molte persone erano semplicemente alla ricerca di un hamburger e un milkshake, la semplicità nell’offerta di Nvidia.

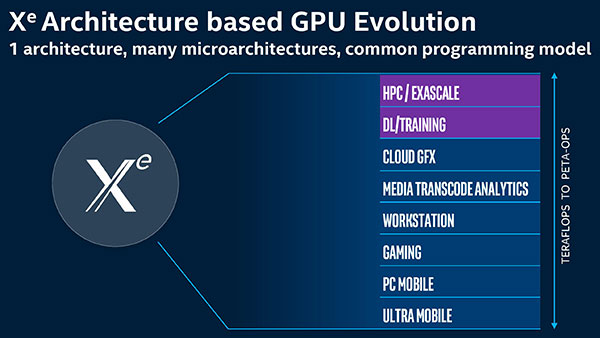

«OneAPI è pensato per funzionare con qualsiasi livello di astrazione» dice Koduri, spiegando che il modello creato è inteso come un “ponte” che è possibile sfruttare all’interno di varie tipologie di prodotti, inclusi gli ambiti di utilizzo dei supercomputer di classe Exascale.

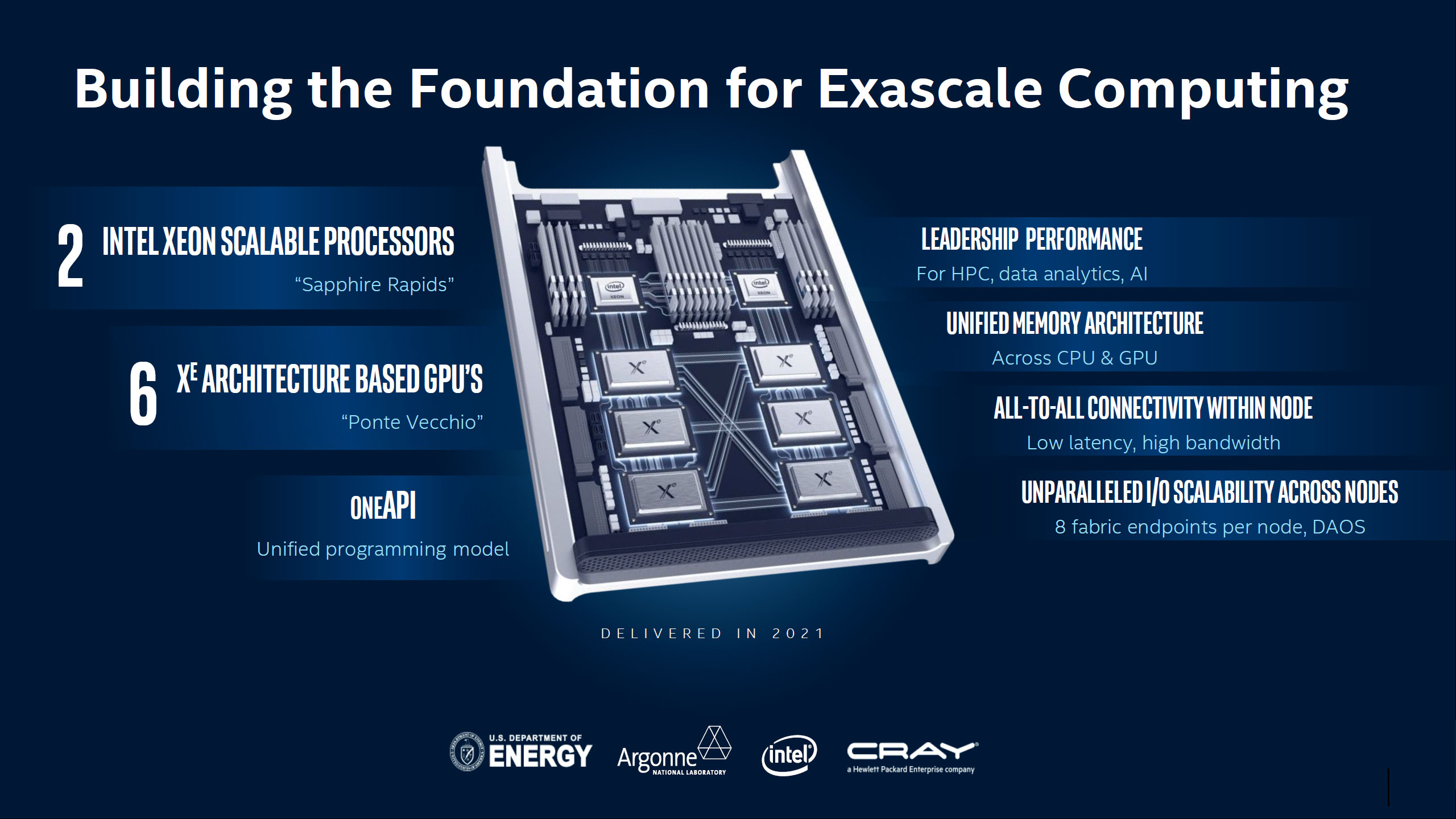

Intel spiega che offrirà strumenti in grado di analizzare ciò che gli sviluppatori fanno, ottimizzando porzioni di codice per le diverse GPU ancora prima del porting. “Ponte Vecchio”, una GPU a 7nm, debutterà dal 2021 e sarà integrata in Aurora, superocmputer da mezzo miliardo di dollari che sarà installato presso l’Argonne National Laboratory nell’Illinois, uno dei più grandi e antichi laboratori nazionali di ricerca degli Stati Uniti.

Koduri non spiega in dettaglio perché questa GPU sarà diversa da quanto visto finora riferendo solo che «Vi sono molti modi di operare con l’architettura che la rendono più flessibile rispetto alle attuali GPU con le esistenti architetture», rivelando la possibilità di «mappare molti carichi di lavoro» e nuovi modi di svolgere operazioni matematiche su più dati elementari contemporaneamente (vector processing).

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)