Tra le novità di iOS 18.2 (nel momento un cui scriviamo una beta per sviluppatori) una funzionalità attiva per gli utenti australiani e che permette di segnalare contenuti inappropriati direttamente a Apple.

La funzione in questione è una estensione delle misure di sicurezza già viste con iOS 17, in grado di individuare automaticamente in iMessage, AirDrop, FaceTime e nell’app Foto immagini e video con nudità.

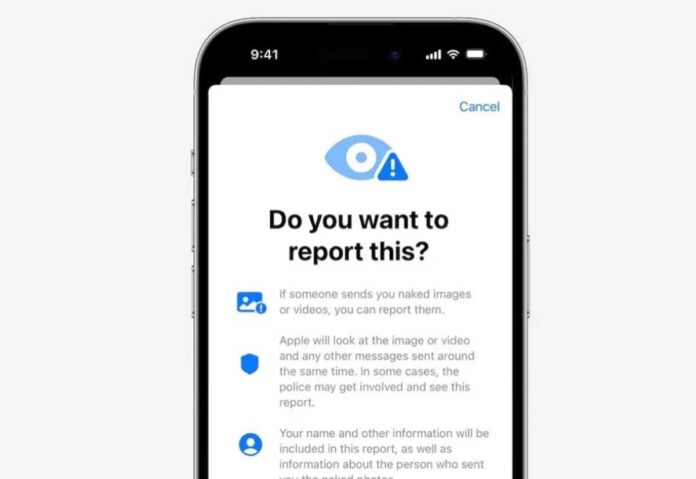

Quando un minore riceve immagini che il sistema identifica come nudità, appare una finestre popup per spiegare che è possibile intraprendere azioni, segnalando l’immagine a Apple che, a sua volta, può eventualmente inviare informazioni ad autorità competenti.

Quando appare l’avviso, il dispositivo dell’utente prepara un report, comprensivo di eventuale materiale offensivo, dei messaggi inviati prima e dopo la ricezione del materiale, e informazioni di contatto dei due account coinvolti. L’utente può compilare un modulo e descrivere l’accaduto.

Dopo avere ricevuto il report, Apple esamina il contenuto e può agire sull’account di chi ha inviato il materiale, inclusa la possibilità di disabilitare l’invio di messaggi con iMessage e segnalare il problema alle forze dell’ordine.

Come accennato all’inizio, la funzione in questione è integrata nella beta 1 di iOS 18.2; al momento è riservata agli utenti australiani ma dovrebbe essere disponibile in futuro a livello globale.

The Guardian riferisce che molto probabilmente Apple ha scelto di iniziare ad attivare la funzione in questione dall’Australia perché qui le aziende dalla fine del 2024 saranno obbligate a segnalare alle forze dell’ordine abusi su minori e materiale legato al terrorismo, elementi eventualmente individuati sui servizi di messaggistica cloud.

Il sistema in questione utilizza l’apprendimento automatico sul dispositivo per analizzare le foto e i video allegati e determinare se una foto o un video sembra contenere nudità.

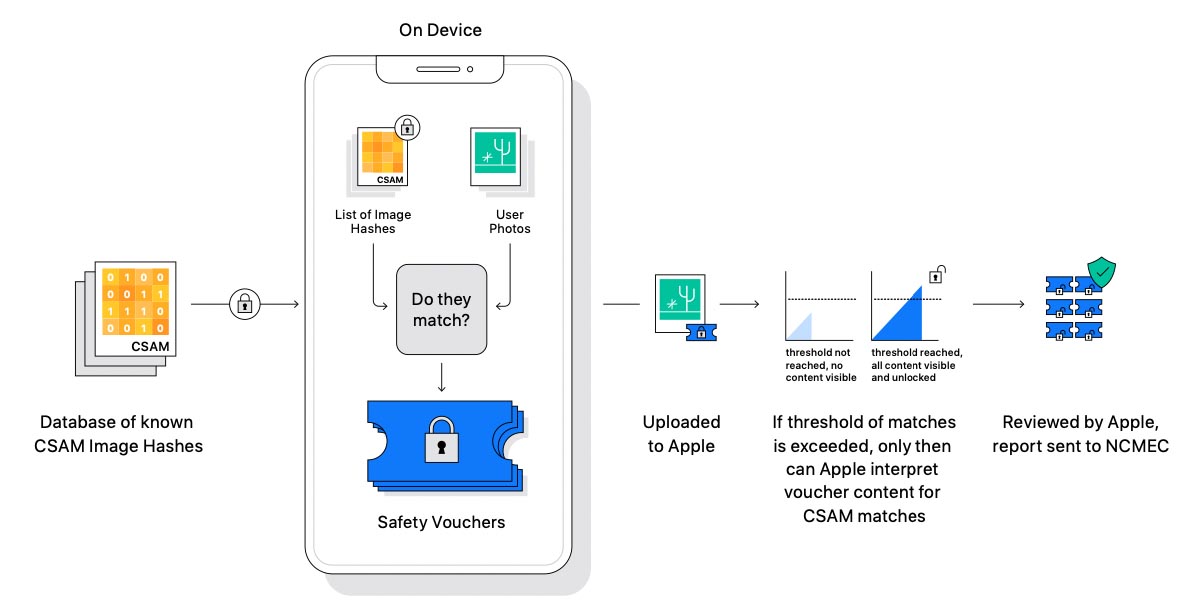

In precedenza Apple ha provato ad attivare funzionalità di protezione CSAM (Child Sexual Abuse Material) ma si è scontrata con organizzazioni che hanno criticato la tecnologia di scansione, potenzialmente pericolosa perché in futuro, lo stesso sistema potrebbe essere usato da qualche governo per obbligare la scansione di altre tipologie di immagini, es. simboli anti-governativi o immagini di proteste.

Apple aveva abbandonato l’idea ma varie associazioni per la protezione dei minori spingono per l’adozione di sistemi di protezione e un regolatore australiano aveva indicato come insufficienti gli sforzi delle multinazionali in tale ambito.