Apple alla WWDC ha aperto la sua era dell’intelligenza artificiale, che ha chiamato Apple Intelligence. E assieme a questo ha introdotto una serie molto lunga di nuove funzionalità e capacità che la tecnologia sviluppata internamente permetterà di realizzare nei prossimi mesi sia all’azienda in termini di integrazione dei suoi sistemi operativi e servizi, sia per le terze parti.

Sono inclusi ovviamente gli sviluppatori di app e i produttori di altri sistemi di intelligenza artificiale: infatti Siri si collega ad altri modelli; il primo è ChatGPT di OpenAI, ma ce ne saranno anche altri, ha detto Craig Federighi.

La strategia di Apple per l’intelligenza

La strategia della AI infatti è basata su tre livelli:

- attivazione dell’AI sul dispositivo

- se i carichi sono troppo complessi sul cloud privato di Apple (dove l’azienda garantisce la possibilità di verifica del rispetto della privacy degli utenti)

- agenti di terze parti.

Inoltre, il tipo di sistemi di GenAI che Apple utilizza sono ampi e versatili, dato che devono fare cose diverse: dalla generazione di immagini alla revisiono o creazione dei testi passando per altre funzionalità di ricerca tra i dati degli utenti e riorganizzazione di altre cose, a partire dalle foto ma ovviamente non solo. Apple ha svelato solo due dei vari modelli che adopera: uno in locale e uno nel cloud.

Il primo modello locale di AI di Apple

Per fare questo Apple utilizza in prima battuta un sistema di inferenza LLM on-edge (cioè sul dispositivo) basato su tre miliardi di parametri (che a dispetto del numero roboante sono relativamente pochi), questo piccolo modello LLM è a bassa latenza e verrà incluso in tutti i dispositivi iOS (ma anche iPadOS e macOS), sfrutterà i neural engine per comprendere ed eseguire i comandi degli utenti e interagire con le app.

Sarà in grado di gestire compiti semplici come fare i riassunti e aliementare le funzioni di Siri che diventa un agente delle AI: gestione dei comandi dell’utente che richiedono l’apertura e l’utilizzo delle app, come “Siri chiama un taxi per andare all’Esselunga più vicina”.

Il modello AI nel cloud privato

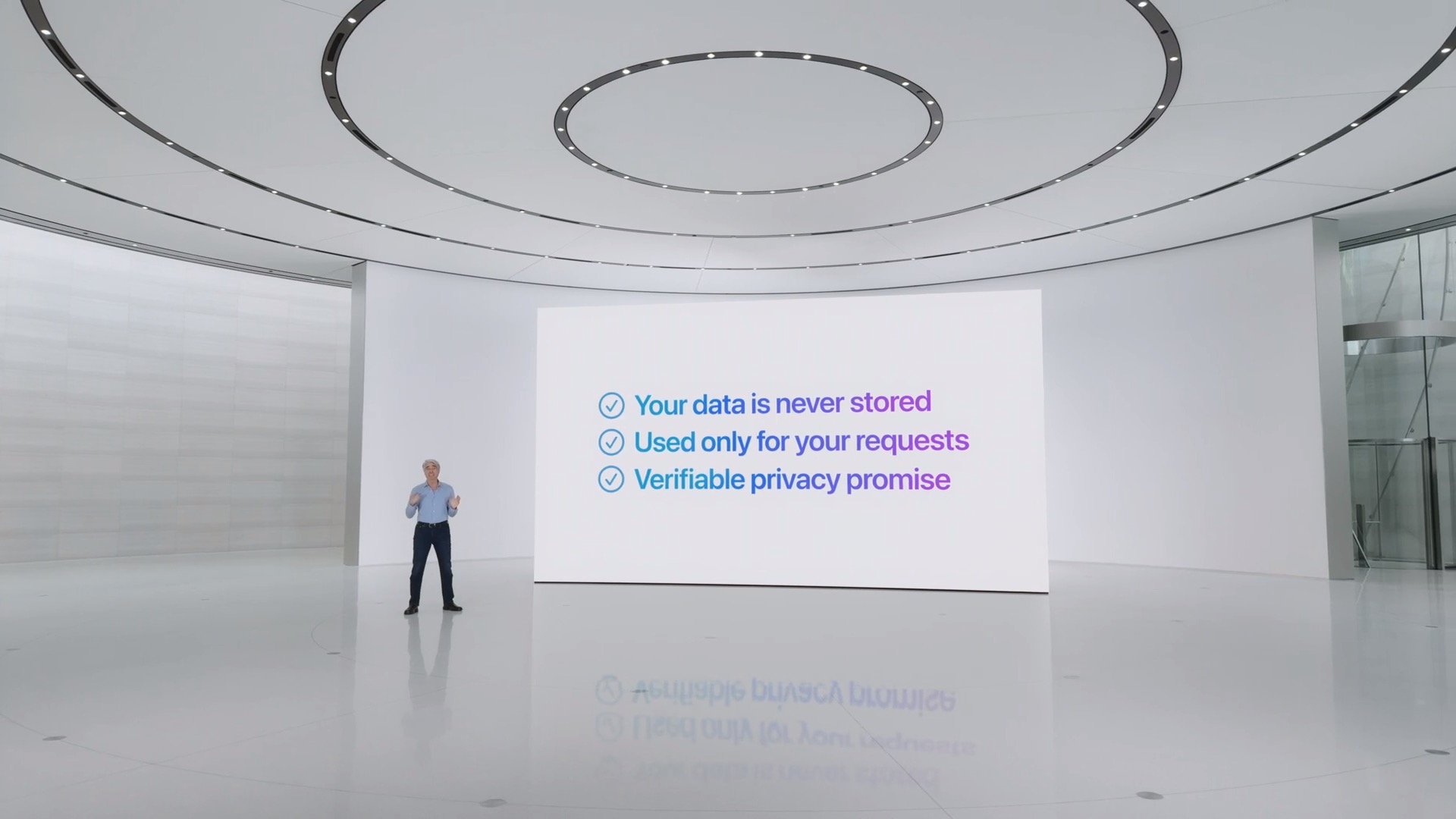

Apple poi, quando le cose si faranno più complicate, si baserà sulla riserva ben maggiore di calcolo in quello che chiama “cloud privato”: L’LLM on-device potrà infatti decidere di passare alcune attività complesse su modelli più potenti ospitati nei data center di Apple chiamati “Private Cloud Compute”.

Anche questi centri dati funzioneranno completamente con i chip M di Apple: in particolare, versioni potenziate dell’architettura M2. I dati inviati da e verso il modello nel cloud saranno completamente criptati e protetti. I server stessi sono realizzati da Apple da zero. In altre parole, Apple ha integrato verticalmente tutto ciò che è necessario per eseguire l’intelligenza artificiale sui dispositivi e all’interno dei centri di calcolo di sua proprietà. Il rischio di altri operatori che “vedano” qualcosa è praticamente inesistente.

Accesso strategico (e privato) a ChatGPT

Infine, c’è l’inferenza basata su modelli di terze parti. Un accordo commerciale e tecnologico con OpenAI per adesso, ma anche altre più avanti, che permette di fare questo a costo zero per gli utenti. Un accordo non dissimile da quello che Apple ha con Google per il motore di ricerca integrato di default con Safari: infatti Google paga fiori di miliardi di dollari per avere la possibilità di essere il motore di prima scelta delle ricerche degli utenti di centinaia di milioni di dispositivi Apple (è molto raro che gli utenti lo cambino con altri motori di ricerca).

Nel caso delle terze parti, cioè ChatGPT, Siri valuterà che una domanda non può avere una riposta diretta né dal modello locale né in remoto, e chiederà il permesso all’utente di “passarla” a ChatGPT, con la garanzia che comunque ci sarà un scambio limitato di dati: Apple non fa pagare un prezzo né passa informazioni non richieste. Tuttavia, è possibile collegare il proprio a pagamento con ChatGPT a Siri, e in questo caso aumenta l’uso della AI di OpenAI e con esso il trasferimento di dati.

La divulgazione tecnologica di Apple

Apple ha spiegato in un primo articolo in lingua inglese anche tutti i dettagli del suo lavoro di creazione e gestione delle sue AI. In particolare, l’addestramento è nato con un progetto del 2023, basato su una prima architettura aperta, che utilizzava dati ottenuti su licenza, con parte dei dati selezionati apposta per potenziare alcune funzionalità reputate strategiche da Apple.

Questo passaggio è cruciale perché si ritiene che sia la qualità dei dati (spesso molto scarsa perché basata su una sorta di “acchiappa tutto quel che puoi” in rete e su altre basi di dati) a generare risposte inaffidabili e talvolta completamente prive di senso. Gli informatici definiscono questa situazione “garbage-in, garbage-out“, cioè: “se alimenti il sistema con della spazzatura, ti restituirà spazzatura”.

L’addestramento e i rinforzi

Apple chiarisce poi che ha filtrato sia i dati personali identificabili che tutti i dati sensibili oltre a parolacce, contenuti di bassa qualità e non inclusivi. In pratica, il corpus di informazioni sulle quali sono state addestrate le sue AI è una delle versioni migliori delle informazioni generate dell’umanità.

Anche dopo aver addestrato il modello, Apple ha proceduto a una serie di raffinamenti progressivi della qualità dei dati e della loro cura, con una serie di algoritmi inventati apposta per garantire il miglioramento e il rinforzo della qualità dei modelli. Questo ha portato secondo Apple a un miglioramento significativo della qualità delle sue AI.

L’ottimizzazione è avvenuta con una serie di tecnologie particolarmente raffinate che Apple indica nel dettaglio e che mirano sostanzialmente ad avere modelli più efficienti e compatti, con latenza minore e maggiore qualità espressiva. Apple sostiene di aver portato avanti tecniche inedite o comunque particolari per la sintonia fine e l’ottimizzazione dei suoi modelli e ritiene di aver creato una architettura apparentemente molto complessa e capace di ottimi risultati.

Gli altri modelli di AI di Apple

Questi due modelli di base fanno parte di una più ampia famiglia di modelli generativi creati da Apple per supportare gli utenti e gli sviluppatori. Ci sono infatti anche altri modelli compreso quello per sscrivere codice che è integrato con Xcode e un modello diffusion per aiutare gli utenti a esprimersi visivamente, ad esempio nell’app Messaggi.

Apple ribadisce sempre il suo mantra per quanto riguarda la lo sviluppo responsabile delle AI: da un lato l’empowerment che deriva dall’usare strumenti intelligenti, pensati per gli utenti. Dall’altro la sensibilità di rappresentare gli utenti e progettare gli strumenti con cura, oltre ad avere sempre chiara la protezione della privacy.

L’azienda spiega che “Questi principi si riflettono in tutta l’architettura che abilita l’Apple Intelligence, collega le funzioni e gli strumenti con modelli specializzati e analizza gli input e gli output per fornire a ogni funzione le informazioni necessarie per funzionare in modo responsabile”.

In conclusione

Vanno notate alcune cose relative alla strategia AI di Apple. La prima è che il suo approccio con il dispositivo dell’utente al centro appare essere il più capace e responsabile, oltre che il più performante. A differenza di altre aziende (soprattutto Meta) Apple non è vincolata da un fornitore esterno di tecnologie chiave, come ad esempio Nvidia con le sue Gpu. Questo vuol dire avere più libertà di manovra e sviluppo su misura, grazie all’integrazione verticale, ma anche risparmiare tantissimi soldi.

Inoltre, l’integrazione con ChatGPT, che attualmente è il modello migliore sul mercato, ma fatto in condizioni di rispetto della privacy, permette ad Apple di sfruttare non solo la sua Apple Intelligence ma anche di non rimanere indietro con il mercato. Proprio come avere l’app di Google Maps in aggiunta alla propria app Mappe.

Da questo disvelamento di tecnologia, oltre che dalle demo offerte alla WWDC, appare evidente che Apple sa parecchie cose su come si fa l’intelligenza artificiale, come si sviluppano modelli di frontiera e come si porta avanti la strategia integrata di modelli pocket sui dispositivi, addestrati usando la stessa tipologia di processori (fondamentali per la resa in locale e su server). La ripartenza di Apple pare essere più strutturata e meno “di retroguardia” di quanto immaginato all’inizio, un passaggio di quel “pensare differente” che viene applicato qui come in tutta la storia della Mela.