Martedì 14 maggio è partita Google I/O, la conferenza annuale per sviluppatori di Google. La parola d’ordine del primo giorno è stata IA, ripetuta centinaia di volte, mentre per quanto riguarda Android 15, bisognerà attendere stasera.

Il CEO Sundar Pichai, ha riferito che Gemini – modello multimodale in grado di gestire testi, immagini, video, codice e altro ancora – sarà integrato in vari servizi.

Una delle trasformazioni che saranno permesse da Gemini, riguarda le ricerche, con funzionalità che permetteranno di porre domande, anche lunghe e complesse, tenendo conto, tra le altre cose, delle foto. Alcune novità riguarderanno a questo proposito anche Google Foto, con funzionalità che permetteranno di effettuare ricerche sulle foto in modo semplice, usando un linguaggio naturale. In uno degli esempi fatti sul palco di Google I/O, l’utente non ricorda la targa della propria auto: anziché scrollare gli scatti nel rullino alla ricerca di questo dato, è possibile partire da una foto della propria auto, chiedere all’AI se la riconosce tra quelle che appaiono di più nella galleria e richiedere la targa. Si possono fare domande più complesse partendo da elementi presenti nelle foto, con domande del tipo: “Quand’è che Lucia ha imparato a nuotare?”, per ottenere risposte tenendo conto delle foto scattate a un bambino, e ancora frase del tipo: “Mostrami i progressi di Lucia con il nuoto”, con Gemini in grado di tenere conto di diversi contesti, date, ricordi. Queste funzionalità arriveranno su Google Foto in estate.

Sundar Pichai ha poi annunciato gli AI Agents, “sistemi intelligenti” in grado di svolgere diversi compiti per conto nostro. Gli agenti sono in grado, ad esempio, di cercare una ricetta nella posta che abbiamo ricevuto, individuare uno specifico ordine nelle mail, compilare un modulo per la restituzione di un collo, programmare un appuntamento per il ritiro di un pacco, riassumere messaggi in Gmail, ma anche aiutarci nei viaggi individuando servizi di nostro interesse (es. lavanderia e dog sitter) nei dintorni della nostra permanenza.

Progetto Astra

Astra – sembra una risposta a Gpt-4o di OpenAI: è un agente per la vita di tutti i giorni, in grado di gestire elementi multimodali (combinando linguaggio, visione e audio) nelle conversazioni in tempo reale. In uno degli esempi mostrati, l’IA è in grado di individuare (dalla fotocamera) elementi in una stanza; l’utente può chiedere dettagli sulla funzionalità degli elementi individuati, ma anche porre domande del tipo: “Ricordi dove ho lasciato gli occhiali?” e domande ancora più complesse. In generale l’idea è permettere di fare domande e ottenere risposte, senza necessariamente rimandare l’utente a siti Internet, con l’IA in grado di comprendere sempre più le richieste.

Trilium, nuova generazione di TPU

Google ha annuncia il suo nuovo TPU (Tensor Processing Unit), che promette migliorie 4,7x rispetto alla precedente generazione e che sarà disponibile per i clienti Cloud a fine anno, con l’offerta di CPU e GPU a supporto di “qualsiasi carico di lavoro”, incluso il nuovo processore Axion, CPU basata su ARM progettata per i data center che promette prestazioni fino al 50% superiori e un’efficienza energetica fino al 60% migliore rispetto alle attuali istanze basate su x86 di pari livello.

Gemini Live

L’app Gemini Live permette all’utente di chiacchierare in tempo reale con l’AI. Google evidenzia la possibilità di conversazioni “approfondite” usando la voce, e riferisce che sta lavorando per offrire l’upload e l’analisi di dati complessi come ad esempio video e codice.

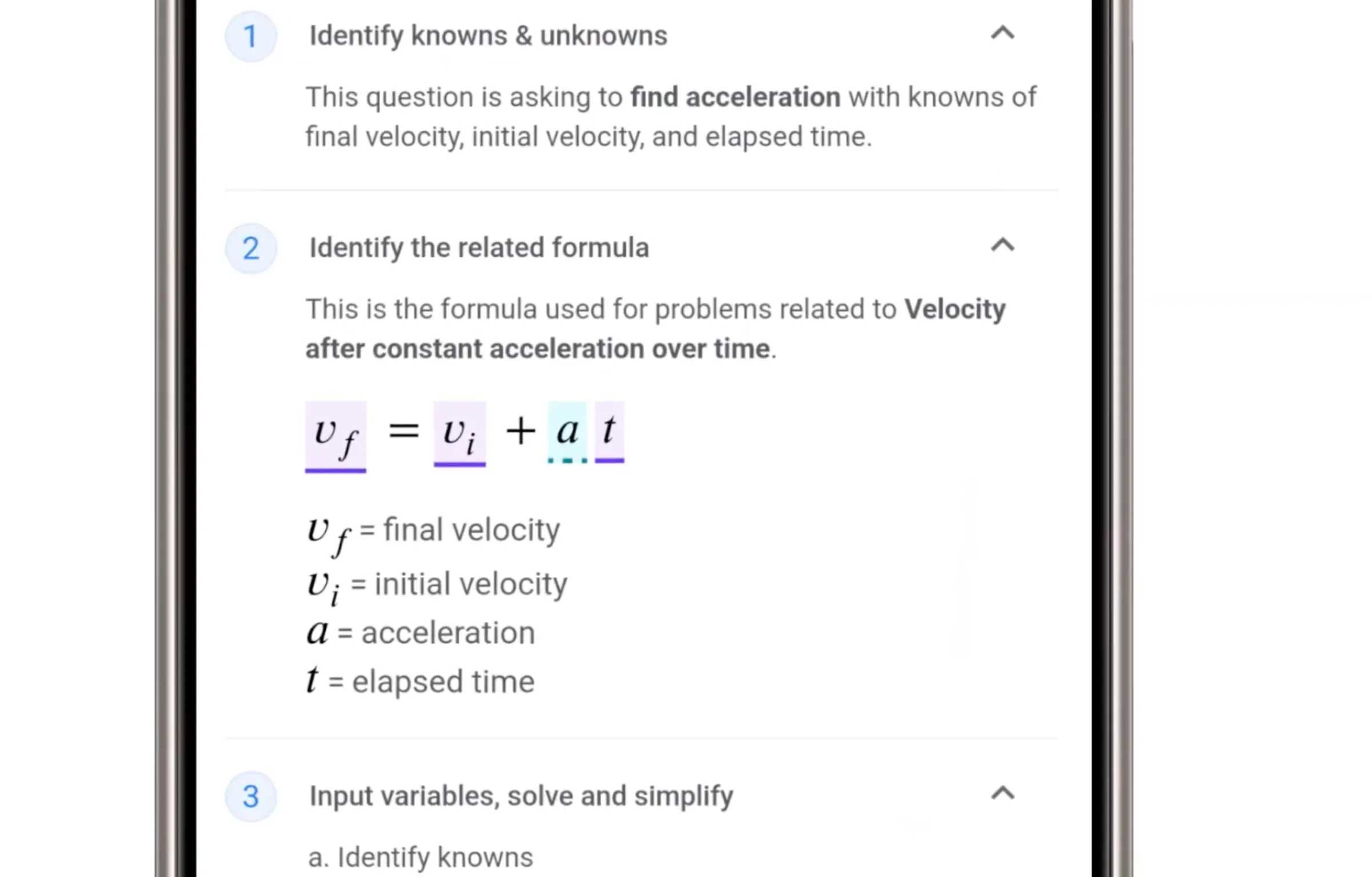

Gemini sarà integrata in Android 15, e la funzione Circle to Search (Cerchia e Trova) sarà offerta in molti più dispositivi (200 milioni entro fine 2024 secondo Google). Il “Cerchia e trova” potrà essere usato per aiutare gli studenti con i compiti, permettendo loro di comprendere concetti e non solo rispondere automaticamente alle domande. Sarà possibile interpellare l’AI cerchiando ad esempio un problema che non riusciamo a risolvere, con l’IA in grado di rispondere su varie questioni relative a materie scientifiche, aiutando anche a interpretare formule, diagrammi, grafici, ecc.

L’IA di Gemini è in grado di creare immagini partendo da testi, social media, e rispondere a domande su un video, elaborare PDF, siti web e altri contenuti fornendo sommari e traduzioni.

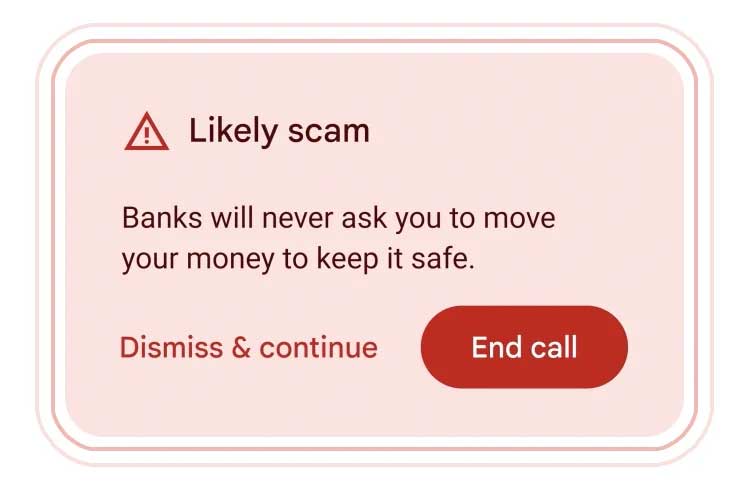

Per alcune funzionalità, Google riferisce che terrà conto della privacy e per l’elaborazione on-device (direttamente sul dispositivo) c’è Gemini Nano, IA che dovremmo vedere entro fine anno sui telefoni Pixel, permettendo funzionalità quali TalkBack, di aiuto per utenti ciechi e ipovedenti, per permettere di comprendere meglio il mondo circostante. Una delle funzionalità previste da Google per questa AI è la possibilità di ascoltare le chiamate e individuare truffe telefoniche.

Dopo gli ultimi annunci di OpenAI e Google, sarà interessante capire cosa ha in programma Apple, obbligata a recuperare il terreno AI che ha per troppo tempo trascurato. Novità specifiche sono attese per la WWDC24 di giugno, compresi probabili accordi con OpenAI e/o Google. Nei giorni passati sono circolate voci di un accordo che che potrebbe portare ChatGPT ad essere il sistema di interazione tra iPhone e un motore di intelligenza artificiale. Un accordo che dovrebbe prendere forma alla prossima WWDC.

Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili a partire da questa pagina di macitynet.