Anche se chatbot e modelli AI hanno preso il mondo di sorpresa con una serie di funzioni mai viste prima su schermo di computer, tutto quanto abbiamo visto finora sono solo i primi passi: nel 2024 i modelli che ora conosciamo e che spesso deridiamo per errori grossolani, compiranno un balzo spettacolare, raggiungendo livelli di precisione difficili da immaginare persino per gli addetti ai lavori.

Mentre la legge di Gordon Moore prevede il raddoppio di transistor e quindi della potenza di calcolo dei chip in 18 mesi, negli ultimi mesi si è scoperto che i modelli AI richiedono una potenza di calcolo che cresce di oltre tre volte nel giro di una manciata di mesi. Finora lo sviluppo e il miglioramento è stato molto vincolato dalla potenza di calcolo data in pasto a modelli AI che continuano a crescere. Solo i colossi che possono contare su costosissimi data center ad alssime prestazioni possono permetterseli.

Il guru Andre Ng, ex responsabile AI di Google Brain e Baidu, spiega che finora i modelli linguistici di grandi dimensioni LLM sono stati impiegati soprattutto in modalità zero-shot. In pratica il modello AI procede token per token (ogni singola parola digitata dall’utente o introdotta come input) per arrivare in un solo colpo alla risposta – output finale, senza mai rivedere il lavoro svolto.

Lo scienziato spiega che tutto ciò equivale chiedere a una persona di comporre un saggio o un articolo procedendo in una sola volta dall’inizio alla fine, senza mai permettere di tornare indietro per revisione. Insomma come chiedere una cosa scritta al volo e di prima stesura pretendendo non solo che sia di alta qualità ma anche priva di errori, anzi perfetta.

Man mano che i modelli AI migliorano, e aumentano le risorse hardware sottostanti, è possibile creare flussi di funzionamento molto più efficaci: non più solo una prima stesura ma un metodo di lavoro simile a un prfessionista in carne e ossa.

Come dovrebbe fare un redattore professionista il modello AI verrà istruito per pianificare uno schermo di lavoro, suddividendo il compito principale in più operazioni e passaggi intermedi. Creerà uno schema, deciderà se occorrono eventuali ricerche su Internet per ottenere più informazioni.

Solo a questo punto scriverà una prima bozza che poi lo stesso modello AI dovrà rivedere per individuare informazioni o argomenti estranei. Una volta individuati errori e punti deboli della prima bozza, il modello AI procederà a scrivere un’altra bozza o la versione finale. Nulla vieta di ripetere la procedura da capo, salvo sempre risorse hardware e consumi di energia.

Nel gergo di settore questa soluzione viene indicata come flusso di lavoro basato su agenti AI e richiede una potenza di calcolo enorme, ma è in grado di cambiare completamente le carte in tavola, secondo Andrew Ng molto più di una nuova generazione di modelli AI.

I think AI agentic workflows will drive massive AI progress this year — perhaps even more than the next generation of foundation models. This is an important trend, and I urge everyone who works in AI to pay attention to it.

Today, we mostly use LLMs in zero-shot mode, prompting… pic.twitter.com/nBqySLHqR6

— Andrew Ng (@AndrewYNg) March 21, 2024

Con il suo team lo scienziato porta a dimostrazione numeri concreti, rilevati nella generazione di codice di programmazione. GPT-3.5 in modalità zero-shot cioè tutto in un solo colpo è corretto al 48,1%, mentre GPT-4 sempre in zero shot arriva al 67%. Ma se si prende GPT-3.5 e si passa al flusso di lavoro basato su agenti AI la percentuale di risultato corretto aumenta al 95,1%.

Immaginate la precisione del 95% nel creare testo scritto e analisi finanziarie, per generare immagini, musica video e in qualsiasi altra delle infinite applicazioni e settori in cui si prevede o già si impiega AI. In un modo o nell’altro AI sembra tendere alla perfezione, ma per il redattore umano è più difficile.

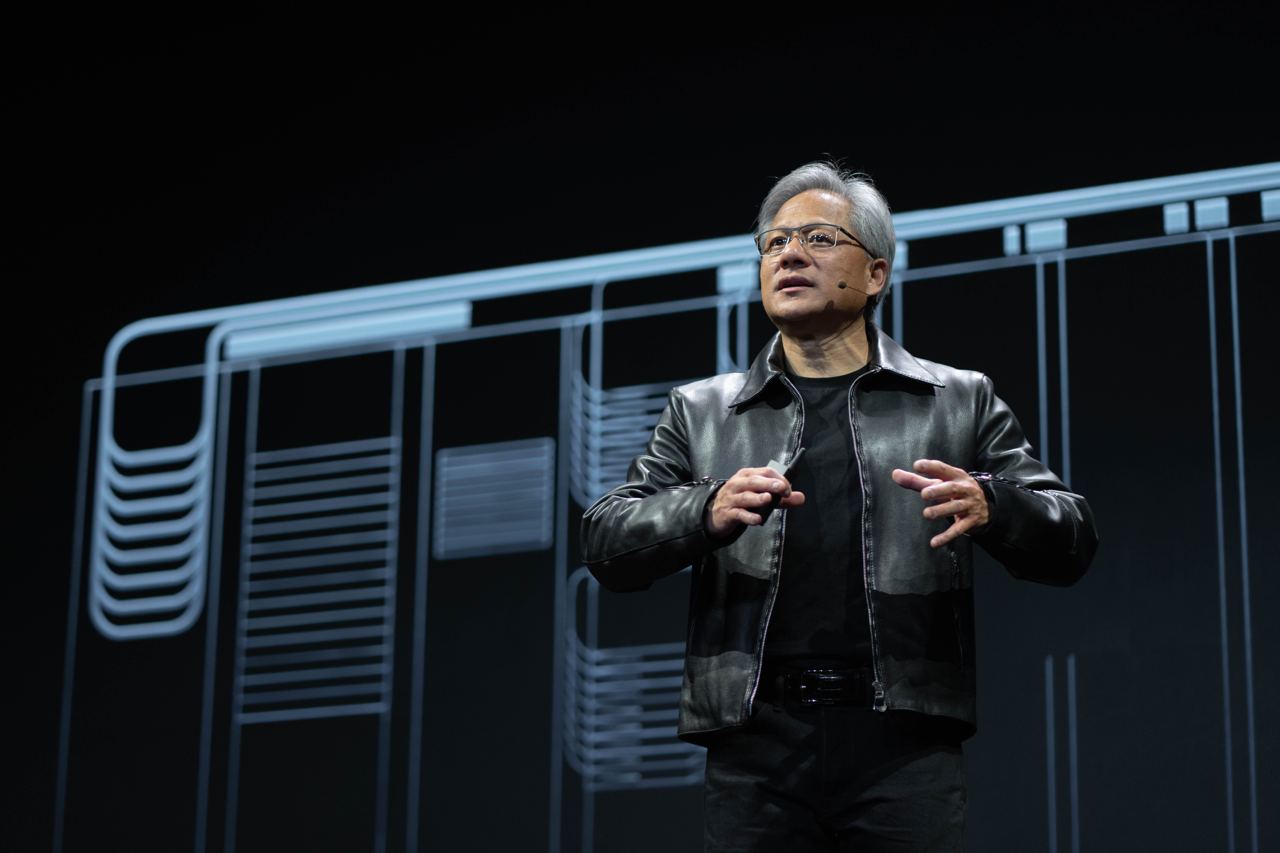

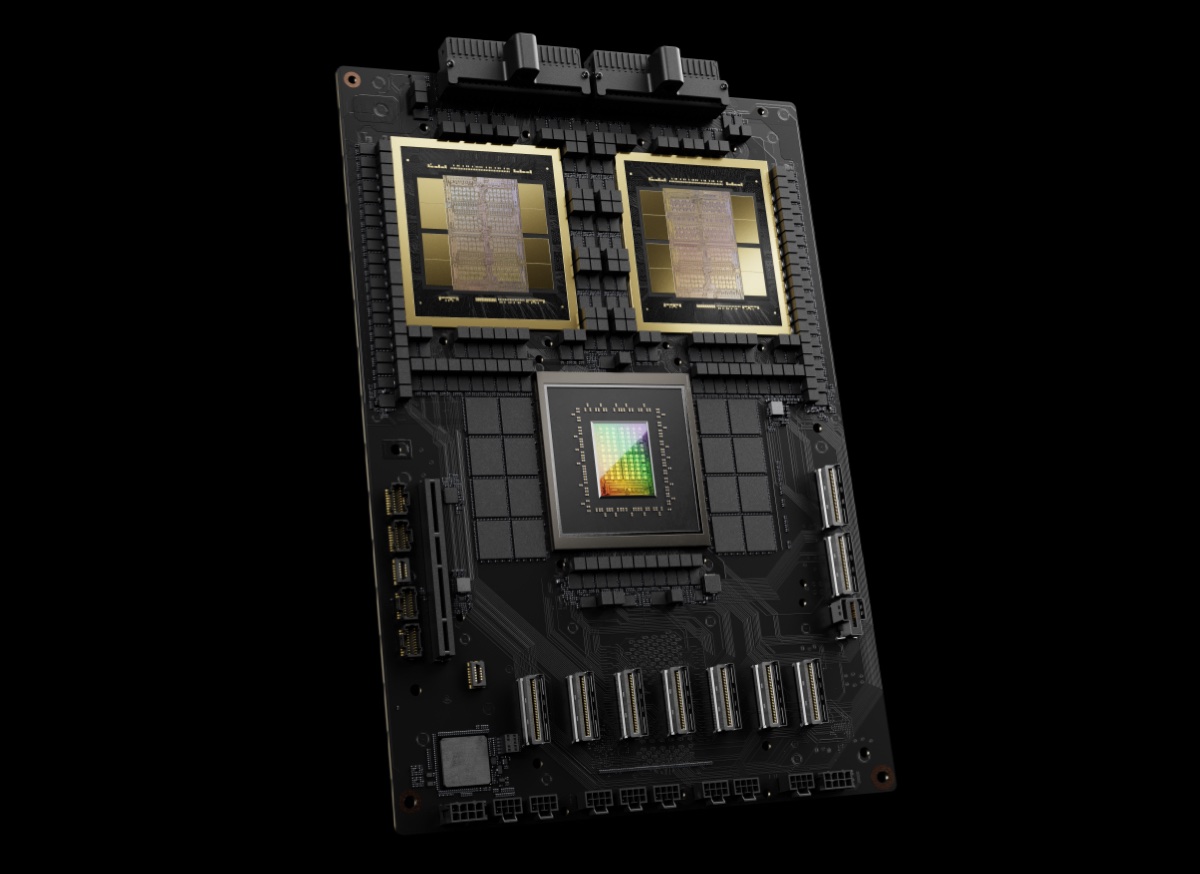

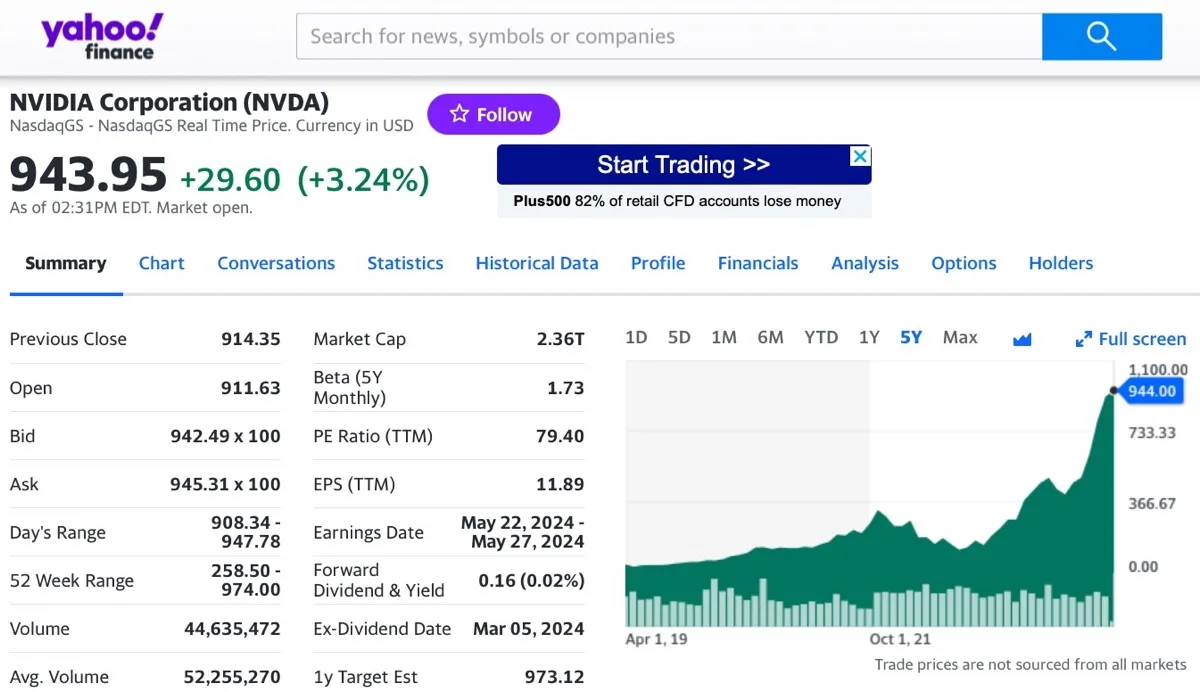

Nvidia sa benissimo che tutto ciò è vero: nel giro di due anni il marchio di GPU per videogiocatori e scienziati e diventato il punto di riferimento per data center e computing ad alte prestazioni indispensabili per AI. E continuerà così fino a quando e se emergerà una valida alternativa.

La nuova piattaforma Blackwell appena presentata promette di consolidare il dominio di Nvidia su questo mercato esplosivo, stimato più grande del boom Internet ed e-Commerce, forse anche sommati insieme.

Anche Elon Musk è convinto che quest’anno ne vedremo delle belle per la guida autonoma, guarda caso anche lui solo ora che ha accumulato una potenza di calcolo da fare Nvidia all’esercito USA. Anche se lui è meno credibile perché ormai lo promette da anni, anche questa volta potrebbe avere ragione ed essersi solo sbagliato sulle tempistiche, come già successo per il predominio delle auto elettriche.

L’immagine di apertura è di julien Tromeur su Unsplash. Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili nella sezione dedicata di macitynet.