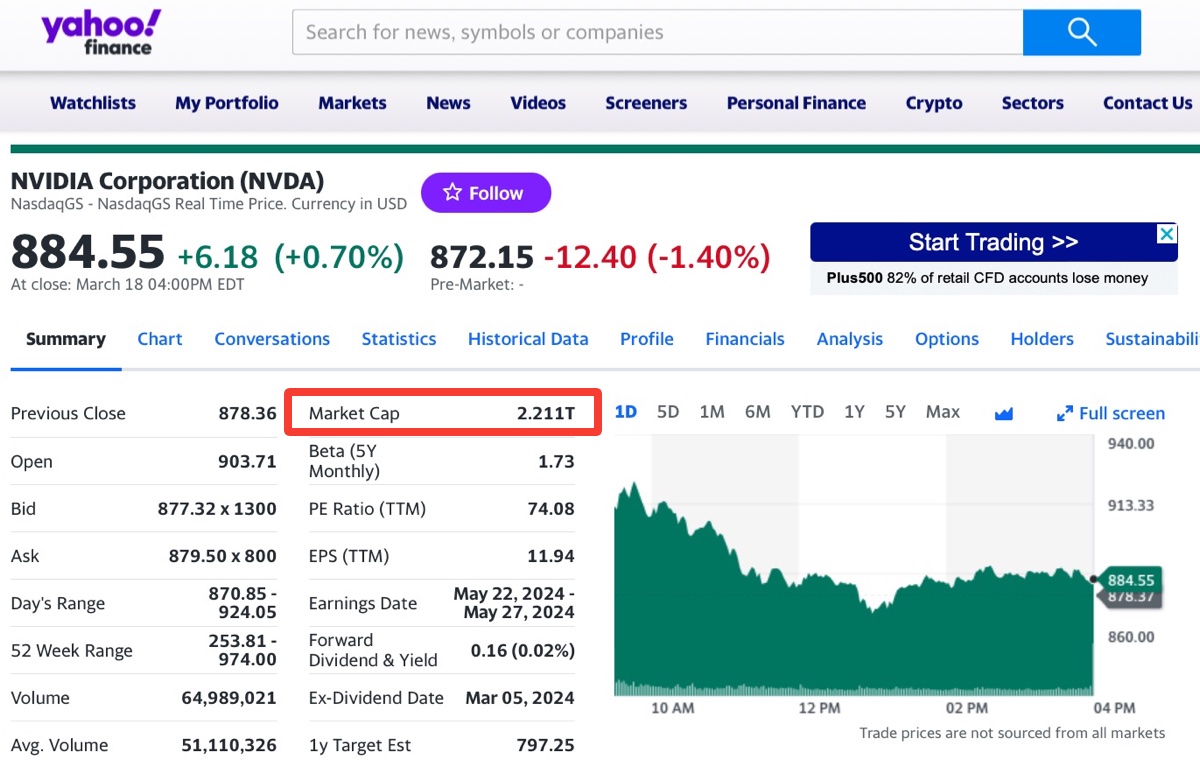

Praticamente con il solo chip H100 e la piattaforma hardware e software attuale Nvidia è diventata nel giro di due anni non solo la regina indiscussa del calcolo AI, ma anche una delle società a valere di più al mondo, superando in un balzo Amazon e persino Alphabet Google: ora con l’annuncio dei successori Blackwell B200 e GB200 il dominio di Nvidia nel settore Intelligenza Artificiale è pronto per un altro scatto.

In passato l’evento annuale GPU Technology Conference siglato GTC era dedicato alle GPU per videogiochi e grafica 3D ma negli ultimi anni focus della conferenza e le centinaia di sessioni tecniche sono stati sempre più dedicati a soluzioni AI hardware e software.

Negli USA l’edizione di quest’anno è già stata paragonata a un concerto di Taylor Swift o addirittura alla Woodstock dell’AI, tanta l’attesa e le brama per i nuovi super chip e architettura da dare in pasto a modelli AI generativi sempre più affamati di dati, potenza di calcolo ed energia.

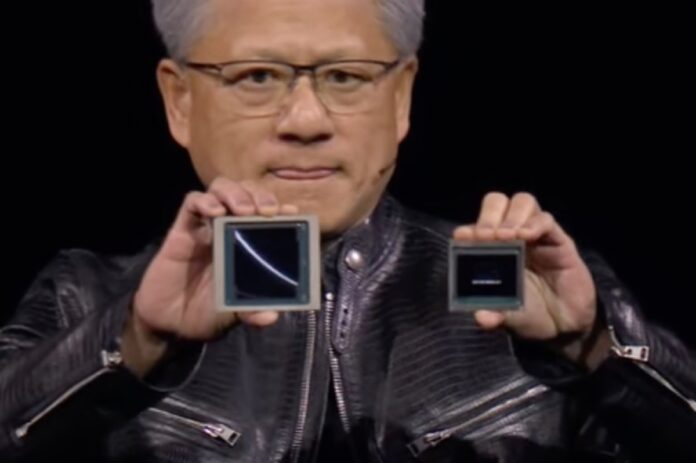

in questo impressionante tornado in accelerazione di tecnologie e capitali Nvidia si trova esattamente al centro, non a caso, ma grazie alla lungimiranza, quasi preveggenza del CEO Jensen Huang che è diventato l’oracolo del settore.

Sam Altman e gli altri ingegni possono sfornare tutti i modelli AI che vogliono, ma per addestrarli, farli crescere o anche semplicemente farli funzionare per metterli a disposizione degli utenti servono i chip Nvidia. Scattano così ordini per decine e centinaia di GPU, se possibile per budget, ma non ce ne sono abbastanza anche migliaia, e tanti centri di calcolo ad altissime prestazioni per far progredire AI sempre più.

Tutti in fila per Nvidia Blackwell B200 e GB200

Rispetto al chip attuale Nvidia H100, con la nuova architettura Blackwell in combinazione con GPU B200 e superchip GB200 le prestazioni nel calcolo AI aumentano da un minimo di sette fino a 30 volte, al contempo il consumo energetico risulta fino a 25 volte inferiore.

Bastano solo queste due specifiche per comprendere la portata del balzo offerto da Nvidia all’intero settore AI con applicazioni e investimenti che sembrano ormai coinvolgere qualsiasi settore, da riduzione dei costi, analisi e ottimizzazioni per società, passando per chimica, biologia, medicina, fino ad arrivare all’archeologia.

Dal palco di GTC 2024 e tramite comunicati stampa il Ceo di Nvidia ribadisce la nuova era in corso:

“L’intelligenza artificiale generativa è la tecnologia che definisce il nostro tempo. Lavorando con le aziende più dinamiche del mondo, realizzeremo la promessa dell’intelligenza artificiale per ogni settore”.

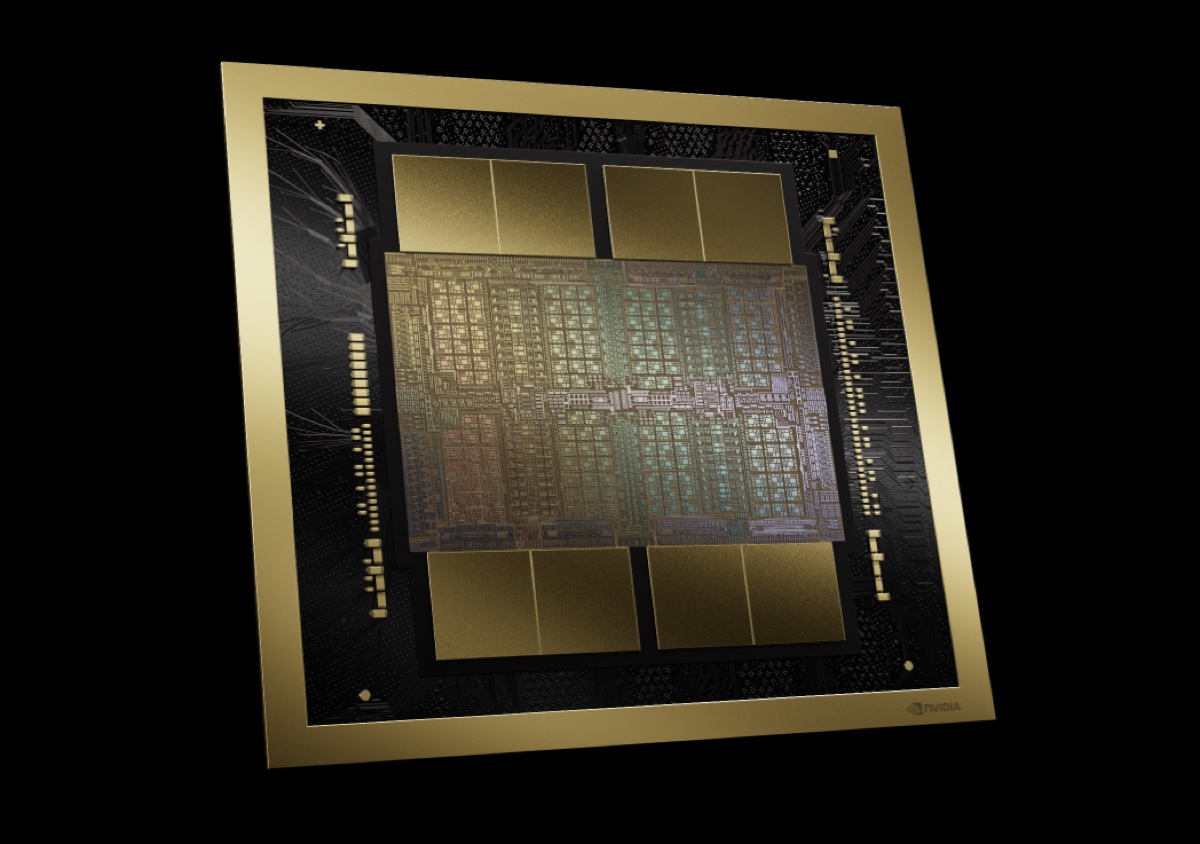

Il chip AI più potente al mondo

Il Ceo dichiara che la nuova GPU Nvidia B200 è composta da ben 208 miliardi di transistor ed è in grado di raggiungere 20 petaflop di prestazioni nel calcolo AI FP4. A confronto il precedente H100 arriva a 4 petaflop. Ma le prestazioni aumentano di più con il superchip Nvidia GB200 che racchiude in un unico componente due GPU B200, una CPU Nvidia Grace, il tutto interconnesso ad altissime prestazioni da 10 Terabyte al secondo.

Così il superchip Nvidia GB200 moltiplica per 30 volte le prestazioni nei carichi di lavoro di inferenza per grandi modelli AI, LLM da Large Language Model, il tutto in maniera molto più efficiente dal punto di vista energetico. Nvidia promette riduzione dei costi hardware e anche del consumo di energia nell’ordine delle 25 volte rispetto a soluzioni basate su Nvidia H100.

Un esempio: ora per addestrare un modello da 1.800 miliardi di parametri occorrono 8.000 GPU Hopper per un totale di 15 megawatt. Con la nuova piattaforma Nvidia Blackwell “bastano” 2.000 GPU B200 con un consumo di 4 megawatt.

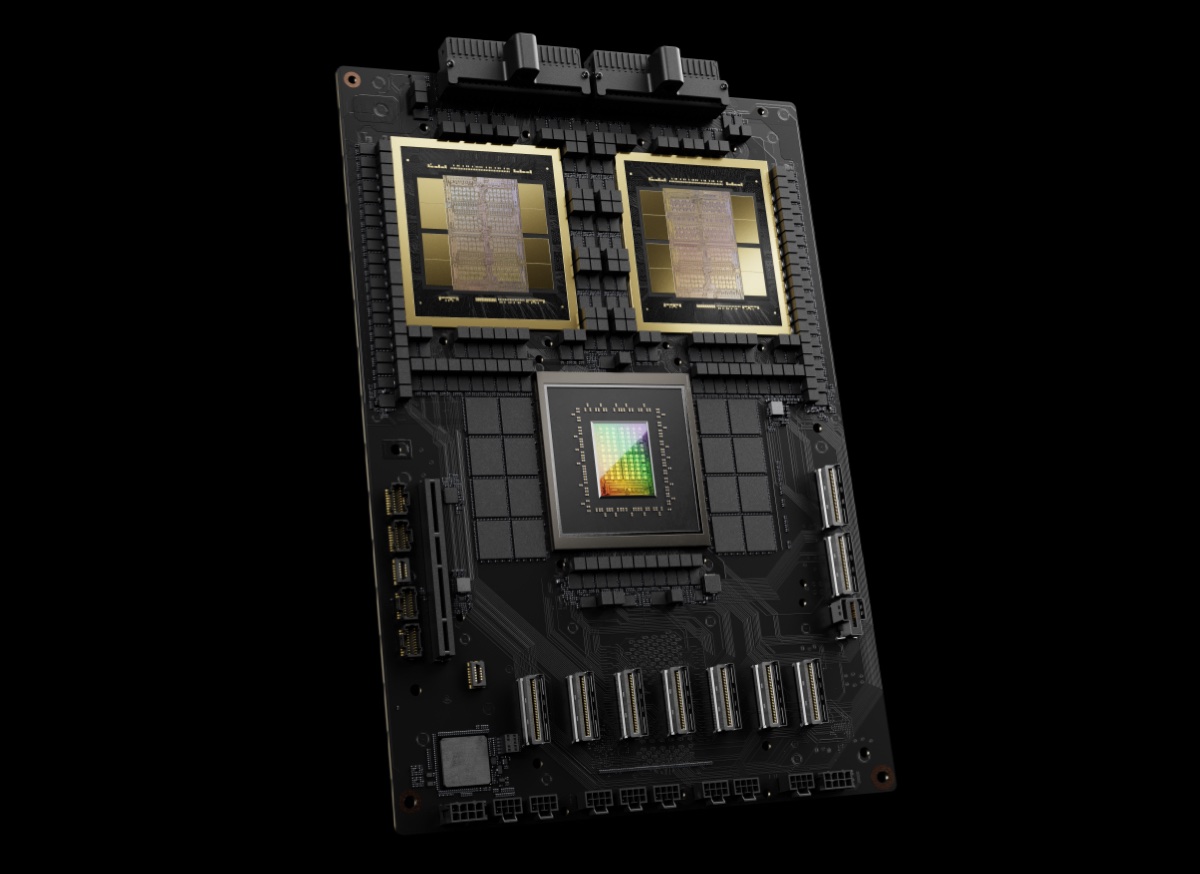

La scalata delle prestazioni non si ferma, anzi si moltiplica ulteriormente combinando più superchip e tecnologie di connessione Nvidia in uno o più server. La società propone diverse configurazioni per ogni esigenza.

Tra queste GB200 NVL72 che in un unico cabinet racchiude 36 CPU e 72 GPU, il tutto raffreddato ad acqua, per un totale di ben 720 petaflop per addestramento AI, oppure 1.440 petaflop (1,4 exaflop) per l’inferenza. Ognuno di questi cabinet racchiude 5.000 cavi singoli per un totale di oltre 3 km.

Si mangia ChatGPT-4 a colazione

Un singolo rack GB200 NVL72 è in grado di supportare un modello AI da 27.000 miliardi di parametri. A confronto si ritiene che la star attuale dei modelli AI GPT-4 di OpenAI funzioni su circa 1.700 miliardi di parametri.

I prezzi non sono stati comunicati, ma tanto è una informazione che non sembra interessare a nessuno, visti i nomi di tutti i più grandi colossi della tecnologia tutti in fila per parlarne bene nelle dichiarazioni ufficiali e per comprarli, previa una lista di attesa lunghissima, anche solo per avere i precedenti H100, figuriamoci i nuovi. Per avere un’idea secondo CNBC l’attuale H100 sebra oscillare tra 25mila e 40mila dollari a pezzo.

Il potere commerciale e tecnologico di Nvidia risulta evidente dai nomi dei CEO e delle società in fila per elogi e ordinativi. Per Sam Altman di OpenAI e ChatGPT “Blackwell offre enormi miglioramenti prestazionali e accelererà la nostra capacità di fornire modelli all’avanguardia. Siamo entusiasti di continuare a lavorare con NVIDIA per migliorare il calcolo dell’intelligenza artificiale”.

Più diretto e conciso Elon Musk “Attualmente non c’è niente di meglio dell’hardware NVIDIA per l’intelligenza artificiale”. Al coro si uniscono il CEO di Alphabet Sundar Pichai, il CEO di Dell Michael Dell, il CEO di Google DeepMind Demis Hassabis, il CEO di Microsoft Satya Nadella per finire con il CEO di Meta Mark Zuckerberg e con il presidente di Oracle Larry Ellison.

Tutti questi stessi colossi e molti altri ancora, startup incluse, stanno creando chip AI proprietari, ma per ora e per il prossimo futuro nulla sembra in grado di poter competere con la piattaforma Nvidia. Si prevede che la galoppata in borsa pocederà ancora, forse fino a raggiungere Apple e la prima tech ora per valore Microsoft, non a caso grazie alla spinta AI.

Gli articoli che parlano di Nvidia sono disponibili qui, invece per le notizie che parlano di Intelligenza Artificialerimandiamo alla sezione dedicata di macitynet.