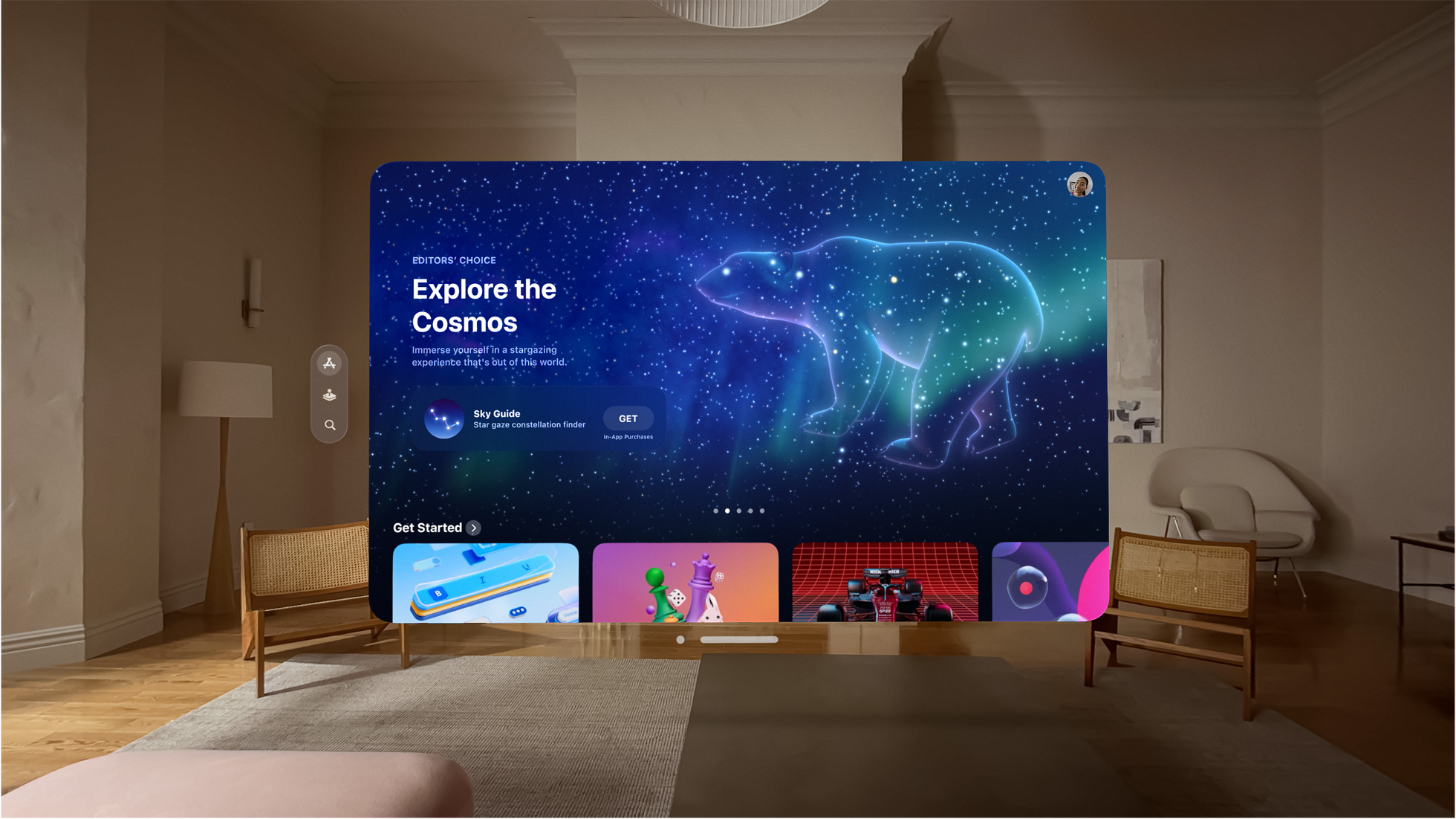

Come promesso nell’ambito della WWDC23 (annuale conferenza sviluppatori), Apple ha rilasciato il visionOS software development kit (SDK), insieme di strumenti che consente agli sviluppatori di creare già da ore app per Vision Pro, lo “spatial computer” che va oltre i limiti dei tradizionali monitor, offrendo un’interfaccia pienamente tridimensionale controllata dai sistemi di input più naturali che esistano: gli occhi, le mani e la voce dell’utente.

“A partire da oggi”, riferisce Apple, “la comunità globale di sviluppatori sarà in grado di creare una categoria interamente nuova di app per lo spatial computing in grado di sfruttare appieno la tela infinita di Vision Pro fondendo insieme contenuti digitali con il mondo fisico per consentire straordinarie nuove esperienze”.

Vision Pro arriverà all’inizio del prossimo anno, ossia nel 2024 ma da luglio, Apple metterà a disposizione developer lab a Cupertino, Londra, Monaco di Baviera, Shanghai, Singapore, e Tokyo per offrire agli sviluppatori la possibilità di testare le loro app sull’hardware Vision Pro e ottenere supporto dagli ingegneri Apple.

Apple spiega ancora che gli sviluppatori potranno creare nuove esperienze sfruttando caratteristiche innovative di Vision Pro usando framework che già conoscono e usano per altre piattaforme, comprese tecnologie quali Xcode, SwiftUI, RealityKit, ARKit e TestFlight. Questi strumenti permettono di creare nuove tipologie di app che si estendono in diversi settori immersivi, sfruttando finestre che possono mostrare contenuti 3D, visualizzabili da qualsiasi angolo. VisionOS, il sistema operativo di Vision Pro, permette all’utente di interagire con i contenuti digitali come se fossero fisicamente presenti nel suo spazio, fondendo perfettamente i contenuti digitali con il mondo fisico.

Per aiutare gli sviluppatori di creare contenuti 3D per app e giochi che gireranno su VisionOS, un nuovo strumento per Xcode denominato Reality Composer Pro permette di visualizzare in anteprima e preparare modelli 3D, animazioni, immagini e suoni ottimizzati per VisionPro. Gli sviluppatori possono interagire con le loro app nel nuovo visionOS simulato, esplorando e testando stanze con varie disposizioni e condizioni di illuminazione. I framework integrano, tra le altre cose, il supporto per le funzionalità di Accessibilità per garantire l’accesso a tutti delle app per visionOS.

Da luglio, riferisce ancora Apple, gli sviluppatori che hanno creato app 3D e giochi con gli strumenti di authoring di Unity, potranno eseguire il porting di app Unity su Apple Vision Pro sfruttando appieno le potenzialità offerte da quest’ultimo.

Apple riferisce poi di alcuni esempi di app che sarà possibil usare sul Vision Pro: Complete HeartX permette a studenti di medicina di visualizzare modelli 3D e animazioni iper-realistiche che aiutano a comprendere e visualizzare problematiche mediche quali la fibrillazione ventricolare; un’app come djay mette a disposizione un completo sistema da DJ direttamente tra le mani dell’utente, permettendo di mixare musica e applicare effetti in tempo reale usando solo gli occhi e le mani. Altri esempi di app sono JigSpace (per consente la visualizzazione di file CAD in modo nuovo) e soluzioni di Realtà Aumentata di PTC (riferimento nel settore della progettazione e lo sviluppo prodotto con modellazione parametrica, simulazione e analisi di prodotto).

VisionOS SDK, la versione aggiornata di Xcode, il Simulator e Reality Composer Pro sono disponibili per gli sviluppatori iscritti all’Apple Developer Program.